Betreibst du eine große Website, wie z. B. einen E-Commerce-Shop, so ist es wichtig auf Crawl-Budget ( Was ist Crawler?) zu achten. Schnell hat man Dutzende Unterseiten generiert, was man nicht unterschätzen sollte.

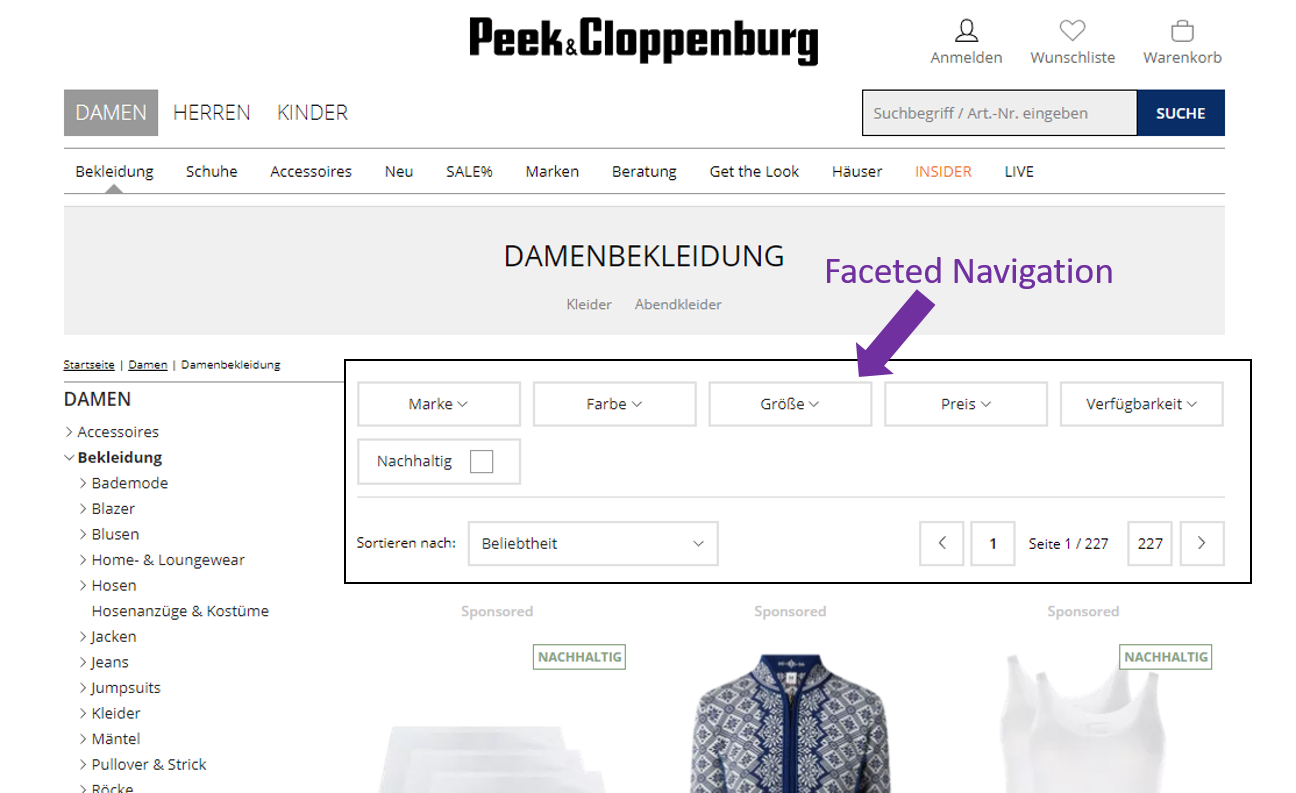

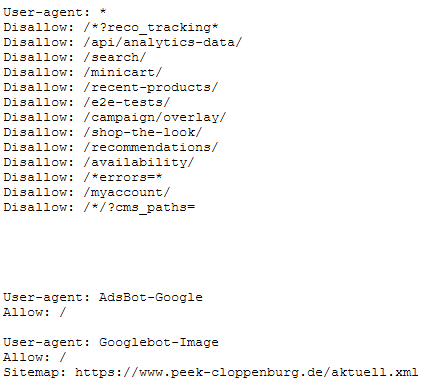

Mit der sogenannten Faceted Navigation unterstützt man User dabei, möglichst schnell und einfach, die gewünschten Ergebnisse zu filtern.

Obwohl die Facettennavigation für User hilfreich ist, kann es aus SEO-Gesichtspunkten schnell zu Problemen kommen.

Wir erläutern euch in diesem Artikel was man unter einer Faceted Navigation versteht, wofür man sie verwendet und besprechen zudem die gängigsten Lösungsansätze mit Fallbeispielen aus der Praxis.

Was ist Faceted Navigation?

Faceted Navigation leitet den Besucher mit Hilfe von verschiedenen Filterungen. Diese können wie hinzugefügt so auch aufgehoben werden, um zum vorherigen Punkt zurückzukehren. um einen früheren Stand herzustellen, was das Gegenstück zur oben beschriebenen Methode darstellt.

Definition & Überblick

Die Faceted Navigation (auch Faceted Search genannt) hilft Nutzern Produkte zu finden, welche auf mehr als einer Dimension beruhen. Dimensionen sind in diesem Fall u. a. Eigenschaften von Produkten, Farben, Größen, Artikeltypen sowie anderen Attributen. Sie bietet gegenüber der hierarchischen Navigation eine flexiblere Lösung.

Wie du in der nachstehenden Grafik erkennen kannst, gibt es bei der hierarchischen Struktur ( Website Struktur) nur eine Möglichkeit ans Ziel zu gelangen (“schwarzer Kasten”). Die hierarchische Struktur ist in der Regel in Silos (s. Beispiel mit Silo A und Silo B) gruppiert. Du kannst daher die gewünschte Teil-Kategorie (“schwarzer Kasten”) nur in der entsprechenden Produktkategorie (Silo A) erreichen.

Über eine sogenannte Drill-Down oder Drill-Up Navigation kann der Nutzer eine Ebene höher oder tiefer im Online Shop navigieren.

Die Funktionsweise einer Facettennavigation ist da deutlich flexibler, wie du in der Abbildung “Faceted Search” erkennen kannst.

Unabhängig von der Ebene kannst du mit verschiedenen Filtern auf die gewünschte Teil-Kategorie (“schwarzer Kasten”) zugreifen. Feste Strukturebenen gibt es hier nicht. Getroffene Einschränkungen (Filterauswahl) können zudem jederzeit zurückgenommen werden.

Vorteile der Faceted Navigation

Die Facettensuche bietet Nutzern die Möglichkeit Ergebnisse einer Kategorieseite nach bestimmten Attributen zu filtern und zu sortieren. Es wird dem Besucher ermöglicht die Suche entsprechend seiner Präferenzen zu verfeinern.

Im Beispiel unten befinden wir uns in der Kategorie “Notebooks” eines bekannten Online Shops. In der Kategorie befinden sich insgesamt 1276 Artikel.

Die Schwierigkeit besteht darin dem Kunden möglichst einfach und ohne Umwege gewünschte Produkte darzustellen. Die Facetten helfen dabei, die Produktliste einzugrenzen und eine personalisierte Suche zu definieren.

Voraussetzungen für eine Facettierte Navigation in Online-Shops

Punkt 1: Sortimentsgröße

Nur ab einer gewissen Shop-Größe bietet die Faceted Navigation Nutzern einen Mehrwert. Bei einer überschaubaren Produktmenge, die der Nutzer schnell erfassen kann, macht eine solche Navigation keinen Sinn.

Punkt 2: Produktart und -eigenschaft

Insbesondere Produkte mit mehreren Dimensionen (z.B. Farbe, Größe, Gewicht, etc.) sind für eine Faceted Navigation prädestiniert.

Punkt 3: Produktspezifikationen

Jedem Produkt müssen eindeutige Attribute zugeordnet werden. Anhand dieser Attribute werden Faceted Navigation URLs automatisch generiert.

Die Gefahren von Faceted Navigation

Bei der Implementierung einer Faceted Navigation kann einiges schiefgehen. Denn als Bestandteil der Seitenstruktur hat sie großen Einfluss darauf, wie Crawler deinen Online Shop sehen. Oder im schlimmsten Fall nicht sehen, wenn das Crawl Budget für die wichtigen Seiten nicht mehr ausreicht.

Doch nicht nur das Crawl Budget wird beeinflusst. Es können auch Probleme mit Duplicate Content und einer unerwünschten Verteilung des Link Juice entstehen. Sowohl falsche Seiten im Google Index ( Google Indexierung prüfen), als auch eine falsche Gewichtung wichtiger URLs im Shop sind die Konsequenz davon.

Welche Gefahren es sonst noch gibt, haben wir nachstehend zusammengefasst.

Tipp: Grundsätzlich empfiehlt Google jeder Kategorie und jedem Produkt eine repräsentative URL zu vergeben. Bei der Implementierung einer Faceted Navigation kann es allerdings problematisch werden, diese Empfehlung einzuhalten.

Duplicate Content und Thin Content

Ganz schnell kann es passieren, dass man den Google Bot plötzlich mit Duplicate Content konfrontiert. Denn mit einer Faceted Navigation kann das gleiche Produkt auf unterschiedlichen URLs erscheinen (Duplicate Content). Oder der Shop generiert Seiten, die aufgrund von ausgewählten Filter den gleichen Content zeigen (Thin Content).

Unterschiedliche URLs für das gleiche Produkt

Angenommen ein Sport Shop führt in seinem Sortiment drei Sprungseile in unterschiedlichen Längen: 5 Meter, 6 Meter und 7 Meter. Die Produkt-URL sollte nach Best Practice ungefähr so aussehen:

https://sport-shop.de/product.php?sprungseil-5-meter

https://sport-shop.de/product.php?sprungseil-6-meter

https://sport-shop.de/product.php?sprungseil-7-meterFührt der Shop nun eine Faceted Navigation ein und hängt getroffene Filtereinstellungen an die URL der Produkte, kann das gleiche Produkt unter verschiedenen URLs zu finden sein. Im folgenden Beispiel landet der Nutzer immer auf einer anderen URL, je nachdem, ob er nach dem Material (“&filter=baumwolle”), dem Preis (“&preis=10-20”) oder beidem filtert:

https://sport-shop.de/product.php?sprungseil-5-meter&material=baumwolle

https://sport-shop.de/product.php?sprungseil-5-meter&preis=10-20

https://sport-shop.de/product.php?sprungseil-5-meter&material=baumwolle&preis=10-20

https://sport-shop.de/product.php?sprungseil-5-meterDieser Fehler wird in der Praxis häufig begangen, weil diese Art der Implementierung oft am naheliegendsten ist. Dadurch erhöht sich allerdings die Komplexität beim Indexierungsmanagement, weil man für jede URL individuelle Indexierungsregeln festlegen muss.

Die bessere Möglichkeit ist es bei Googles Empfehlung zu bleiben und jedes Produkt bloß mit einer einzigen URL zu verlinken - unabhängig von den getroffenen Filtereinstellungen des Nutzers.

Unterschiedliche Kategorieseiten ohne Mehrwert

Ähnlich verhält es sich mit den generierten Seiten der Faceted Navigation. Denn bei einem Online Shop mit Faceted Navigation entsteht je nach Umfang der Filtermöglichkeiten eine große Anzahl dynamisch generierter Seiten.

Bleiben wir beim Beispiel mit dem Sport Shop und werfen einen Blick auf die Kategorien im Bereich Ballsport:

https://sport-shop.de/category.php?ballsport/fussball/

https://sport-shop.de/category.php?ballsport/handball/

https://sport-shop.de/category.php?ballsport/tennis/Mit einer Faceted Navigation kann sich die Anzahl der vorhandenen URLs ( URL Parameter) schnell aufblähen, indem bloß wenige Filtermöglichkeiten der Faceted Navigation hinzukommen:

https://sport-shop.de/category.php?ballsport/fussball&material=baumwolle

https://sport-shop.de/category.php?ballsport/fussball&filter=herren

https://sport-shop.de/category.php?ballsport/fussball&preis=10-30

https://sport-shop.de/category.php?ballsport/fussball&material=baumwolle&filter=herren

https://sport-shop.de/category.php?ballsport/fussball&material=baumwolle&filter=herren&preis=20-30

https://sport-shop.de/category.php?ballsport/fussball&filter=herren&preis=10-20

...Dabei passiert es häufig, dass unterschiedliche URLs sehr ähnlichen Content aufweisen (ähnliche oder gleiche Produkte). Oder auf gefilterten Seiten gar keine Produkte angezeigt werden, weil die viel zu genauen Filtereinstellungen keine Ergebnisse liefern und hunderte leere Seiten generiert werden.

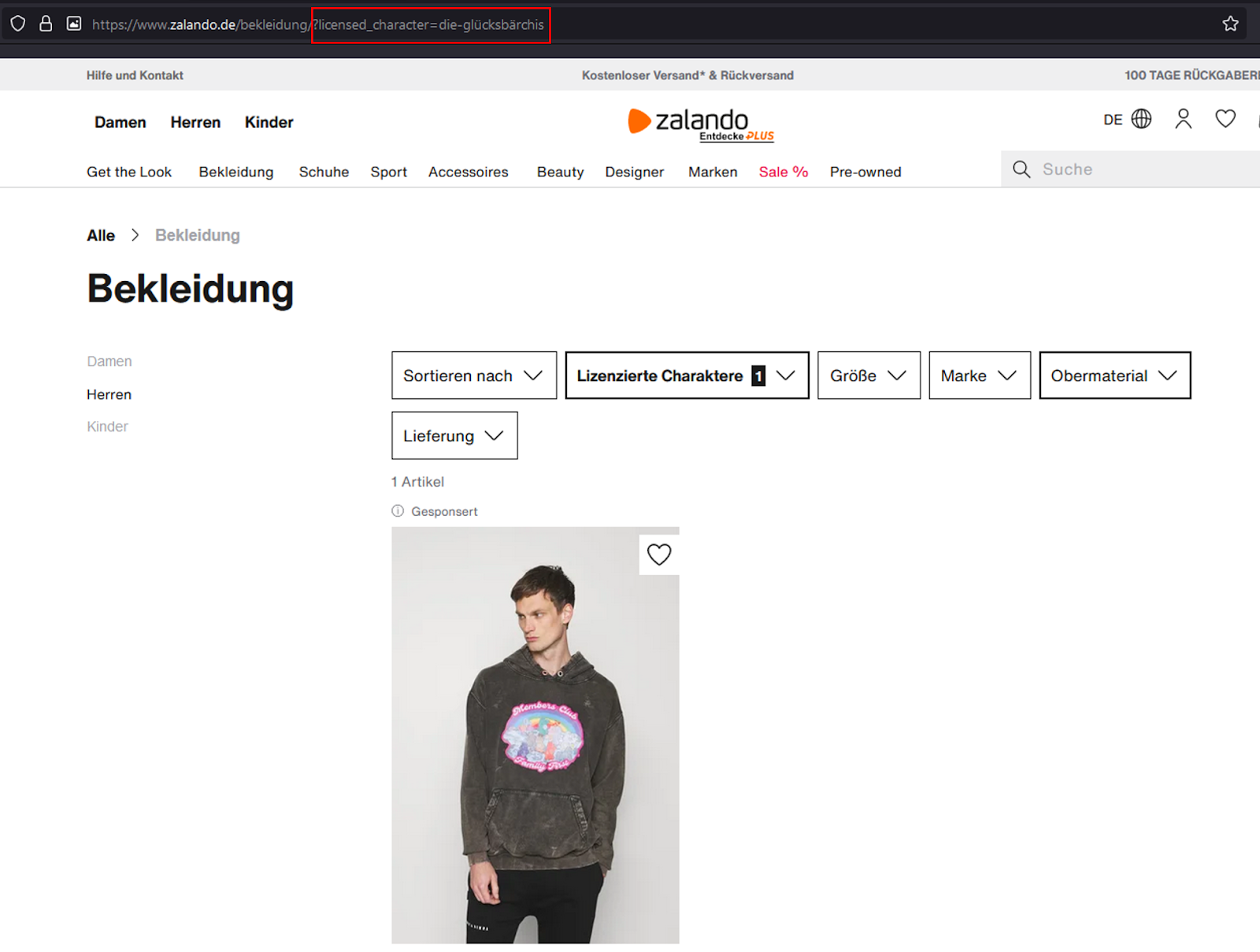

Auch bekannte Online Shops sind von diesem Problem nicht ausgenommen:

Hier auch das 2. Beispiel:

Entgegen dem Duplicate Content Problem bei URLs von Produktseiten, lässt sich die dynamische Generierung von Faceted Navigation URLs nicht wirklich umgehen. Hier kommt es ausschließlich auf den richtigen Umgang und ein durchdachtes Indexierungsmanagement an.

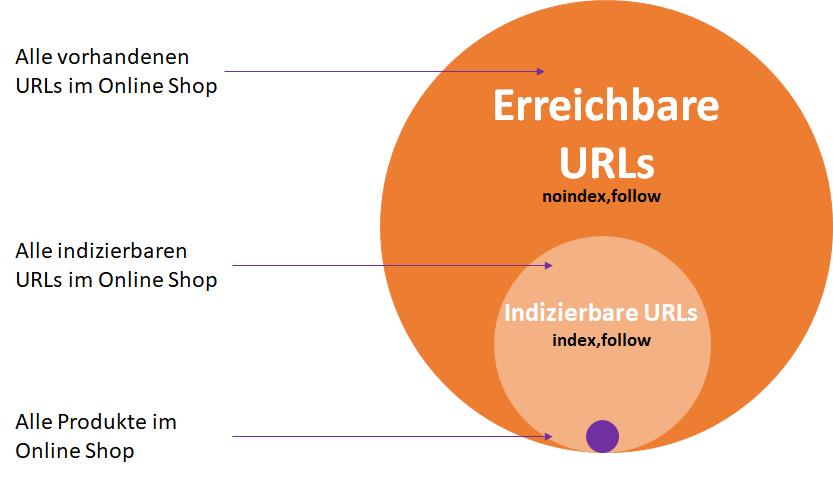

Index Bloat

Ohne weitere Maßnahmen können alle neu generierten URLs der Faceted Navigation von Google indexiert werden. Das kann zu einem sogenannten Index Bloat führen. Dabei wird der Google Index mit irrelevanten Seiten ohne Mehrwert für den Nutzer aufgebläht.

Das ist für keinen Shop-Betreiber wünschenswert. Denn bei der Beurteilung einer Website fällt für den Algorithmus jede einzelne Seite ins Gewicht. Lässt man auch Seiten mit geringer Qualität vom Crawler indexieren, wirkt sich das auf das Gesamtbild der eigenen Website aus.

Aufgrund dem fehlenden Mehrwert und der potentiell hohen Anzahl irrelevanter Seiten, verschlechtert die Indexierung von Faced Navigation-URLs die Website-Qualität in den allermeisten Fällen.

Tipp: Wie so oft macht die Dosis das Gift. Einige wenige Low Quality URLs haben keinen nennenswerten Effekt auf die Autorität einer Website. Eine große Anzahl geht hingegen schnell mit Rankingverlusten einher.

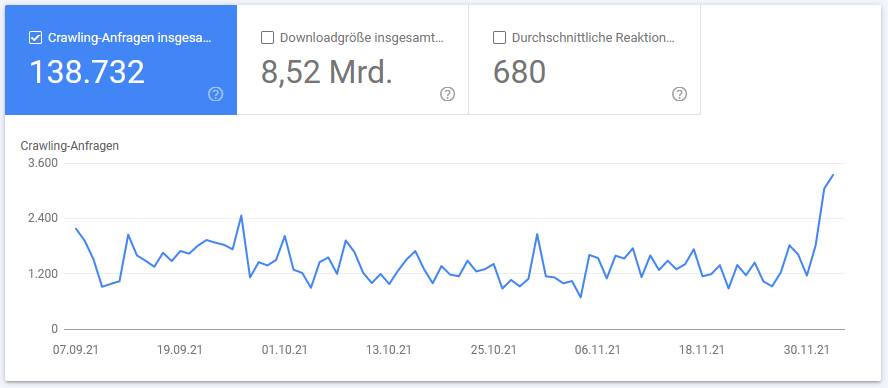

Verschwendung von Crawl-Budget

Bevor eine Website oder URL in den Google Index aufgenommen wird, muss sie zuvor evaluiert und bewertet werden. Man spricht dabei von “Crawling”. Jede öffentlich zugängliche Website im Internet wird von Suchmaschinen Bots gecrawlt und bei entsprechender Beurteilung in den Index aufgenommen.

Dieser Prozess geht natürlich mit einem Aufwand für Google & Co. einher. Die Zeit und Ressourcen, die Suchmaschinen Bots für das Crawlen einer Website aufwenden, bezeichnet man in der Praxis auch als Crawl Budget.

Mit der Größe einer Website steigt auch der Aufwand sie zu crawlen. Deshalb empfiehlt Google Website-Betreibern, sich ab einer gewissen Website-Größe genauer mit der Steuerung des Crawl Budgets auseinanderzusetzen. Dabei nennt Google zwei Anhaltspunkte:

- Websites mit über 1 Million einzelnen Seiten, deren Inhalt sich häufig (einmal pro Woche) ändert

- mittelgroße Websites mit über 10.000 einzelnen Seiten mit Inhalten, die sich sehr schnell (täglich) ändern

Auch mittelgroße Online Shops können mit einer Faceted Navigation schnell in dieses Raster fallen. Denn aufgrund der unterschiedlichen Kombinationsmöglichkeiten können bereits wenige Filter tausende neuer URLs generieren.

Info: Die Einführung von 4 Filterkategorien mit jeweils 8 Auswahlmöglichkeiten generiert 4096 neue URLs. Bei ursprünglich 10 vorhandenen Kategorie-Seiten entstehen 40960 neue URLs. Je nachdem, wie viele Produkte auf jeder der 40960 URLs dargestellt werden, kommt der Shop ziemlich schnell auf mehr als 1 Million einzelne Seiten.

Übersteigt die Anzahl von URLs im eigene Online Shop das Crawling Budget, werden Änderungen an der Website womöglich erst bei einem späteren Besuch vom Crawler erfasst. Im ungünstigsten Fall werden einzelne Seiten überhaupt nicht indexiert.

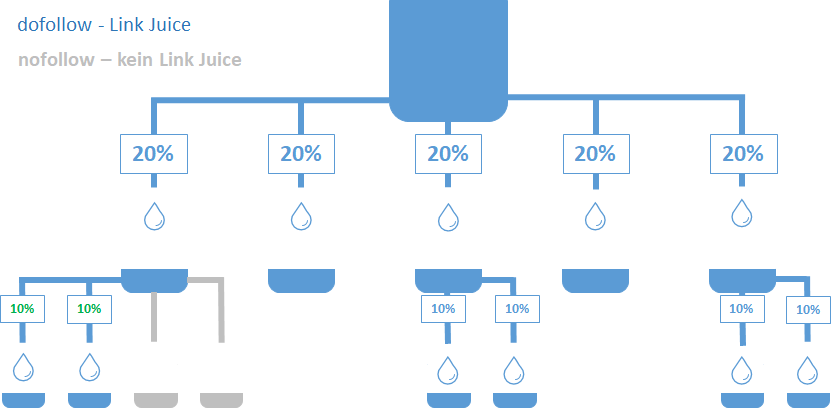

Verteilung von Link Juice

Natürlich wirkt sich eine Faceted Navigation genauso wie alle anderen Links in deinem Online Shop auf die Verteilung des Link Juice aus. Das gilt deshalb, weil der Linkjuice einer Seite zwischen allen ausgehenden Links vererbt wird. Erhöht sich der Anteil ausgehender Links, sinkt der Anteil des vererbten Link Juice.

Faceted Navigation Lösungsansätze

Um die genannten Gefahren zu umgehen und eine Faceted Navigation ohne negative Effekt einzuführen, haben wir folgende Tipps für dich zusammengestellt. Dabei gibt es verschiedene Herangehensweisen, die sich in der Praxis bewährt haben.

Noindex, follow

Die bekannteste Lösung für Indexierungsprobleme ist das Meta Robots Tag “noindex, follow”. Dieser HTML Tag wird von Suchmaschinen Bots ausgelesen und enthält Anweisungen zum Indexieren einzelner Seiten.

Besteht das Ziel darin einzelne Seiten aus dem Google-Index auszuschließen, ist diese Lösung ein ideales Instrument. Ausgeschlossene Seiten werden zwar weiterhin gecrawlt, aber nicht in den Google-Index aufgenommen.

Diese Lösung eignet sich allerdings nicht, um Probleme mit dem Crawl Budget in den Griff zu bekommen. Denn die Seiten werden wie gesagt immer noch gecrawlt. Außerdem wird dabei auch die Verteilung des Link Juice nicht weiter berücksichtigt.

Beispiel:

Wir haben eine Unterseite für Zirbenbetten, die wir in den Index aufnehmen möchten. Diese Unterseite kann nach Längenmaßen über die Faceted-Navigation gefiltert werden.

Kategorie-URL:

https://www.bettenwunder/betten/zirben/Faceted-Navigation-URL:

https://www.bettenwunder/betten/zirben/?size=2-meterDurch das Hinzufügen des noindex-Tags bei der Facetten-URL, können wir diese von der Indexierung ausschließen.

Canonical-Tags

Bei (kleineren) Online-Shops bietet sich der Canonical Tag als Lösungsansatz an. Während das Crawl-Budget-Management noch nicht so sehr ins Gewicht fällt, werden Probleme mit dem Link Juice und Index Bloating gelöst.

Info: Es ist aber auch bei kleineren Online Shops empfehlenswert genauer hinzuschauen. Einige URLs mit Filterkombinationen haben aufgrund von bestehendem Suchvolumen einen Platz im Index verdient.

Der Link Juice von Facetten-Seiten, die per Canonical-Tag auf indexierbare Kategorieseiten verlinken, geht nicht verloren. Die Linkpower geht auf die Kategorie-Seite über, statt auf nicht indexierbare URLs verteilt zu werden.

Ein Beispiel zur Implementierung:

Wir nehmen jetzt einfach mal an, die URL deiner Kategorieseite sieht wie folgt aus:

https://beispiel.de/betten/zirbenholz/ Nach Anwendung einiger Faceted Navigation Filter wird die URL um einige Parameter erweitert:

https://beispiel.de/betten/zirbenholz/?size=2m&color=brown&black=BDie obige Facetten-URL wird nun mit einem Canonical-Tag ausgewiesen, der auf die übergeordnete Kategorie-Seite verweist:

<link rel="canonical" href="https://beispiel.de/betten/zirbenholz/" /> Das Canonical-Tag ist jedoch lediglich ein Vorschlag für Suchmaschinen. Ist Google aus irgendeinem Grund der Meinung, die kanonische URL ist fehlerhaft implementiert, so wird der Tag einfach ignoriert.

Ignoriert Google deine Canonical-Tags liegt es in der Regel an einen der folgenden Gründe:

- Es handelt sich bei den Seiten um keine Duplikate (Duplicate Content):

Dies ist der Fall, wenn sich die Facetten-Seiten durch die Filter-Auswahl deutlich voneinander unterscheiden. Ändert sich der Title, die Description und die H1-Überschrift, so kann dies zu Verwirrung bei Google führen.

- Es wird mehrfach auf eine Facetten-Seite intern verlinkt:

Viele interne Links auf eine Facetten-Seite können die Bedeutung der Unterseite für Google verstärken. Die kanonische URL wird ignoriert.

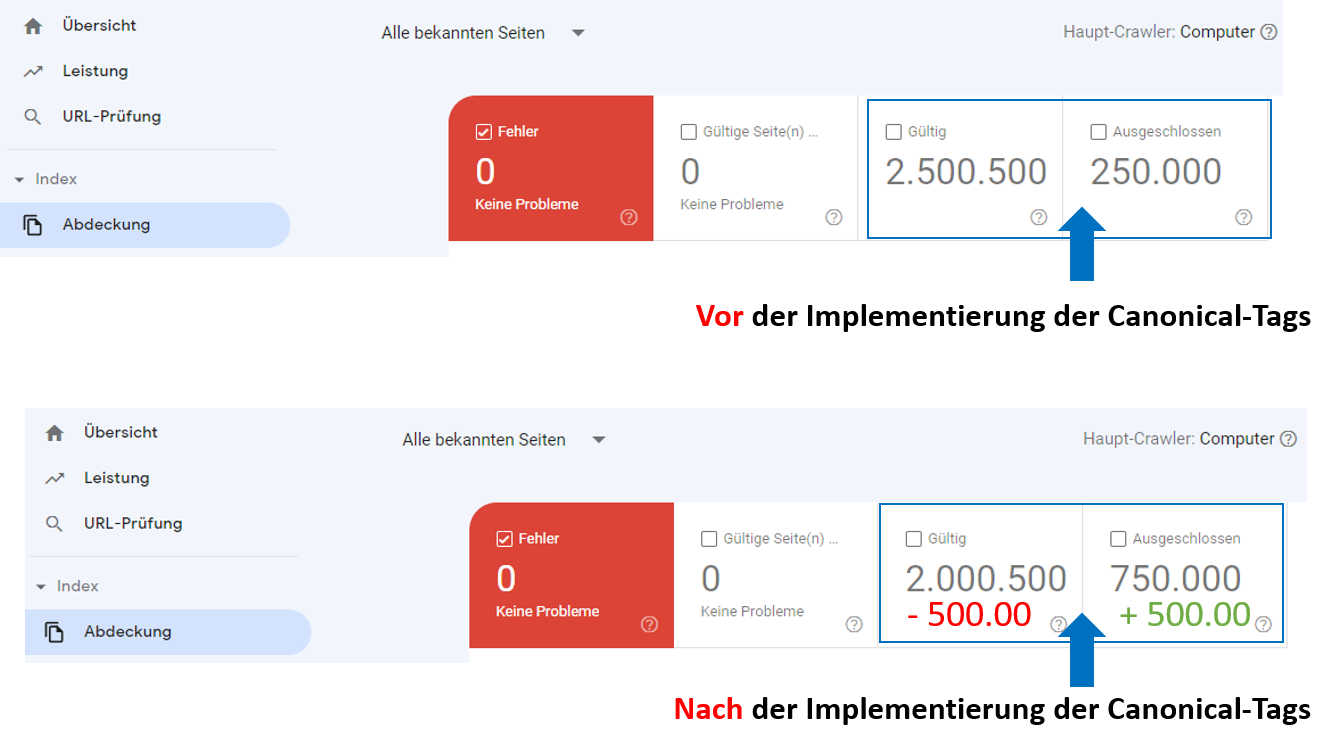

Du solltest dir auf jeden Fall nach der Implementierung der Canonical-Tags den Bericht “Abdeckung” im Menüpunkt “Index” in der Google Search Console anschauen.

Nehmen die indexierten Seiten deiner Website nicht ab, so solltest du genau prüfen, warum die Canonical-Tags nicht von Google akzeptiert werden.

Im Beispiel unten hat die Implementierung der Canonicals den gewünschten Effekt gezeigt. Es wurden insgesamt 500.000 URLs vom Index ausgeschlossen, was du in der Search Console ablesen kannst.

Beispielhafte Darstellung in der Google Search Console

Disallow robots.txt

Bei Problemen mit dem Crawl Budget kannst du über die robots.txt den Google Bot daran hindern bestimmte URLs zu crawlen. Dabei handelt es sich um eine Datei mit Anweisungen für Suchmaschinen Bots.

Das kann sinnvoll sein, wenn mehr URLs deines Online Shops indexiert sind, als täglich von Google gecrawlt werden.

Beispiel einer robots.txt Anweisung zum Ausschluss von Parametern:

User-agent: *

Disallow: *color=*Der Eintrag “User-agent” beschreibt für welche Bots diese Anweisungen gelten. Eine robots.txt kann aus verschiedenen Einträgen für unterschiedliche Bots bestehen.

Das Symbol * hinter User-agent steht für “alle Suchmaschinen”. Das heißt die nachfolgenden Anweisungen gelten für alle Suchmaschinen-Bots.

Verzeichnisse und URL-Parameter werden über den Eintrag “Disallow” ausgeschlossen. Im oberen Beispiel betrifft das alle URLs mit der Zeichenfolge “color=”. Das Zeichen “*” ist ein Platzhalter für vor- und nachgelagerten Text in der URL.

Die URL https://www.bettenwunder/betten/zirben/?size=2&color=red&black=B würde demnach vom Crawling ausgeschlossen werden.

Die URL https://www.bettenwunder/betten/zirben/?size=2&red&black=B würde nicht vom Crawling ausgeschlossen werden.

Beispiel einer robots.txt Anweisung zum Ausschluss von Verzeichnissen:

User-agent: *

Disallow: */color/*Bei zalando.de sieht die robots.txt wie folgt aus:

Es wurden die Verzeichnisse

- “/cart/*”

- “/wardrobe/*”

- “/myaccount/*”

- “/opinions*”

- “/api/navigation/*”

- “/api/*”

vom Crawling ausgeschlossen. Im zweiten Eintrag wird außerdem der Screaming Frog SEO Spider aus allen Verzeichnissen ausgeschlossen.

Tipp: Die Benutzung der robots.txt ist nur sinnvoll, wenn deine URLs erkennbare Muster aufweisen. Unterscheidet sich jede URL und hat einen einzigartigen Parameter, muss für jede URL ein eigenständiger Eintrag hinterlegt werden. Es muss in diesem Fall eine andere Lösung gewählt werden.

Das Risiko eines Crawls trotz Ausschluss in der robots.txt ist sehr gering. Solange du Google nicht signalisierst, dass eine URL (Facetten-Seite) relevant ist - etwa durch verstärkte interne Verlinkung oder externe Backlinks - hast du in der Regel keine Probleme.

Search Console Parameter

Da Parameter in der Praxis häufig zu Crawling Problemen führen, bietet Google die Möglichkeit einzelne Parameter auszuschließen. Die Voraussetzung dafür ist eine verifizierte Search Console Property deiner Domain. Mehr Informationen dazu findest du bei Google.

| URL | Beschreibung |

| https://beispiel-shop.de/damen/jacken/ | Statisch URL ohne Parameter |

| https://beispiel-shop.de/damen/jacken&material=baumwolle&preis=10-20 | URL nutzt die Parameter material und preis bei der Darstellung des gleichen Produkts. |

| https://beispiel-shop.de/damen/jacken&material=leder&sessionid=1234 | URL enthält Parameter aus der Faceted Navigation und eine Session-ID des Nutzers. |

Um bestimmte Parameter vom Crawling auszuschließen sind nur wenige Schritte nötig:

- Das URL Parameter Tool der (alten) Search Console öffnen

- Einen bestehenden Parameter ändern oder einen neuen Parameter hinzufügen

- Die Parametereinstellungen vornehmen

Online Shops mit vielen Parametern

Bei Online Shops mit vielen Parametern ist ein ganzes Setup zum Ausschließen irrelevanter Parameter nötig. Dabei werden gleich mehrere Regeln erstellt, die bloß einen Teil aller Parameter ausschließen:

| Parameter | Crawl Einstellungen |

| category | Every URL (jede URL) |

| sort-by | Only URLs with value = preis (nur mit bestimmtem Wert in der URL) |

| sort-order | Only URLs with value = absteigend (nur mit bestimmtem Wert in der URL) |

Aus den Parameter-Einstellungen der Tabelle ergeben sich folgende Regeln für den Google Bot:

- https://shop.de/kategorie?category=herren&sort-by=produktname&sort-order=absteigend

- Die URL wird nicht gecrawlt, weil der Parameter “sort-by” nicht den Einstellungen in der Search Console entspricht

- https://shop.de/kategorie?category=damen&sort-by=preis&sort-order=absteigend

- Die URL wird gecrawlt, weil der Parameter “sort-by” und der Parameter “sort-order” den Einstellungen in der Search Console entsprechen

- https://shop.de/produkt/12345

- Wird gecrawlt, da nicht von den Parameter Einstellungen betroffen

- https://shop.de/kategorie/winterjacke/

- Wird gecrawlt, da nicht von den Parameter Einstellungen betroffen

Nofollow Links

Mit dem Attribut “nofollow” kann verhindert werden, dass Linkjuice an Facetten-Seiten vererbt wird. Außerdem kann damit das Crawl Budget gesteuert werden. Wobei jede Suchmaschine anders mit nofollow-Links umgeht.

John Müller von Google meinte in diesem Zusammenhang, dass Seiten mit einem Nofollow-Link nicht so interessant sind und das diese nicht von Google gecrawlt werden müssen. Das heißt aber nicht, dass der Google Bot sich strikt an diese Vorgaben hält.

Außerdem wird das nofollow-Attribut von verschiedenen Suchmaschinen unterschiedlich behandelt:

Google wertet diese Links wie oben beschrieben in der Regel nicht. Yahoo hingegen folgt den Links zwar, unterbindet jedoch die Vererbung des Link Juice. Daher erscheinen mit nofollow verlinkte Seiten im Yahoo Index.

Die Vererbung von Link Juice wird übrigens bei allen Suchmaschinen unterbunden. Das wirkt sich positiv auf die Gesamtverteilung aus - verlinkte Seiten ohne Relevanz werden durch den nofollow-Tag ausgeschlossen.

Probleme im eigenen Shop finden

Wie findet und identifiziert man eventuelle Probleme im eigenen Online Shop? Dazu existieren verschiedene Methoden und Tools.

Google Site Abfrage

Mit einer Google Site Abfrage lassen sich potentielle Probleme im eigenen Shop schnell finden. Dabei wird der Google Index nach allen indizierten URLs einer Website abgefragt. Nimmt man dabei eine URL mit Parametern, zeigt Google ausschließlich indizierte Seiten mit diesem Parameter an.

Findest du in den SERPs viele Ergebnisse ist das wahrscheinlich kein gutes Zeichen. Denn das bedeutet Google hat viele parametrisierte URLs gecrawlt und indexiert.

Crawler sollten URLs jedoch lediglich bis zu einer bestimmten Verzeichnisebene crawlen und URLs mit irrelevanten Parametern vom Index ausschließen:

Online Shop crawlen

Mit dem Tools wie dem Screaming Frog kann der Besuch des Google Bots simuliert werden. Dabei werden relevante Informationen zur Indexierung einzelner URLs, wie z.B. Robots-Meta-Tags, Canonical-Tags und Link Attribute untersucht und gespeichert.

Sobald dein Online Shop vollständig gecrawlt wurde können die gesammelten Informationen aufbereitet und Rückschlüsse auf das Indexierungsmanagement gezogen werden. Die meisten Crawler Tools bereiten die Daten auch graphisch im Tool Interface auf.

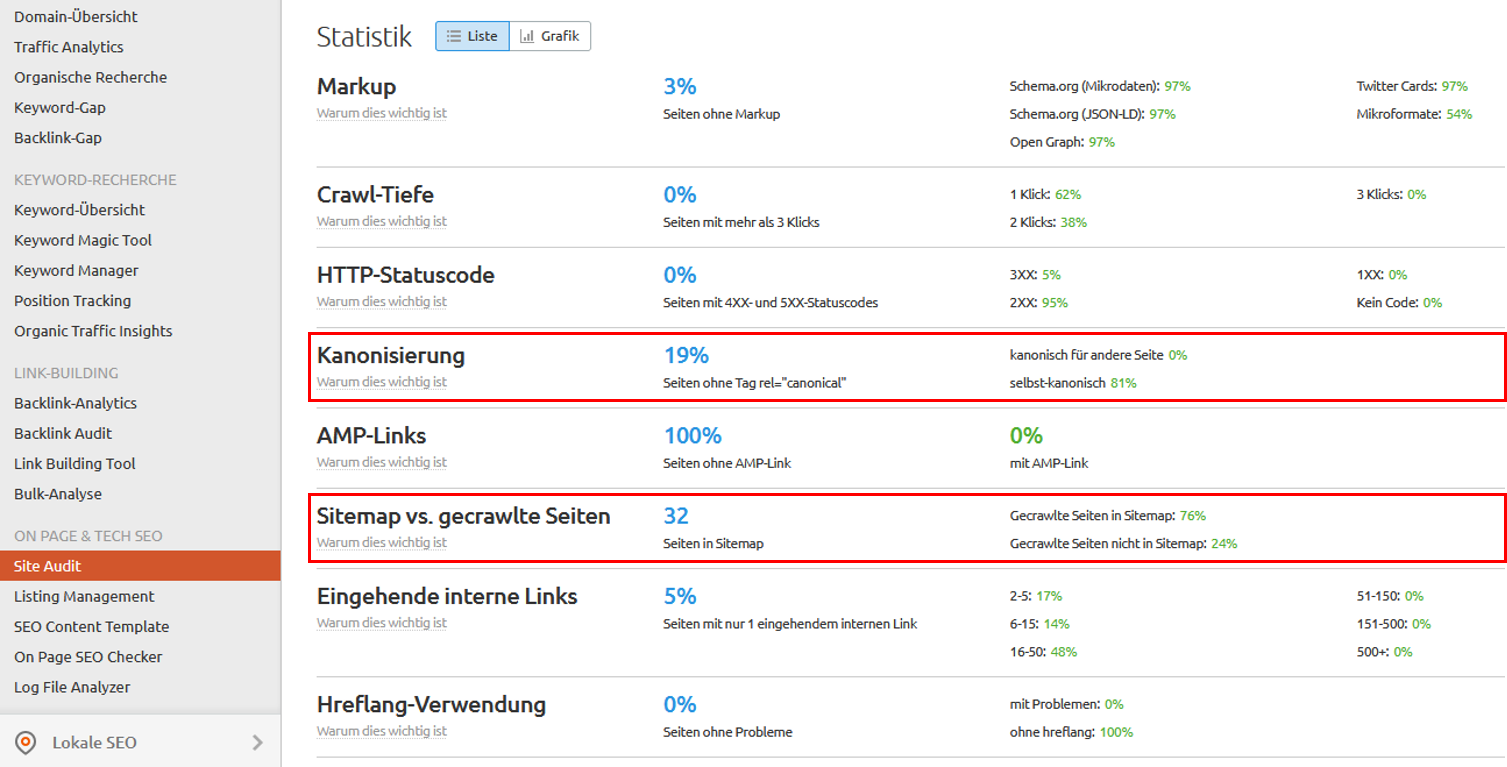

Probleme mit Semrush identifizieren

Auch mit Semrush kannst du deinen Online Shop crawlen. Hierfür muss ein Projekt angelegt und ein Site Audit durchgeführt werden. Nach Fertigstellung kannst du einzelne technische Aspekte des Online Shops näher unter die Lupe nehmen.

Im Statistik-Tab des Site Audits findest du z.B. Informationen zur Kanonisierung einzelner URLs und einen Vergleich zwischen gecrawlten und in der Sitemap enthaltenen URLs:

Und im interne Verlinkung-Tab kannst du sehen, ob interne nofollow-Links korrekt implementiert sind und gecrawlt werden können:

Der Semrush Crawler berücksichtigt dabei auch etwaige Restriktionen in der robots.txt und zeigt betroffene URLs an:

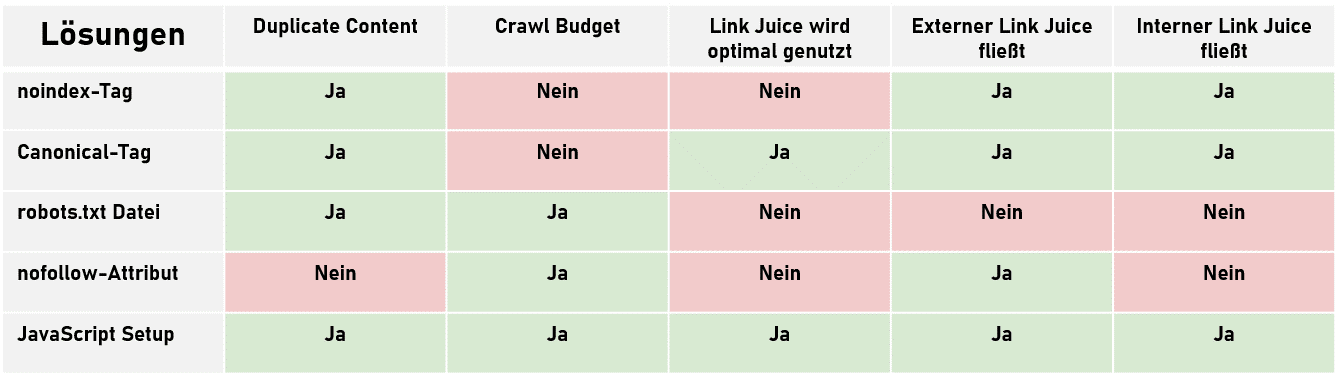

Lösungsansätze für Faceted Navigation mit Vor- und Nachteilen (mit Übersichtstabelle)

Wie du siehst gibt es unterschiedliche Möglichkeiten Probleme bei der Implementierung einer Faceted Navigation zu lösen. Dabei wirkt jede Methode unterschiedlich auf Crawler. In den meisten Fällen ist ein Mix aus den vorgestellten Lösungsansätzen sinnvoll.

Fallbeispiele: Faceted Navigation im eigenen Shop umsetzen

Du weißt nun, welche Gefahren eine Faceted Navigation birgt und welche Instrumente du als Online Shop Betreiber hast, dem entgegenzuwirken.

Aber wie wird die Faceted Navigation in der Praxis umgesetzt? Worauf achten andere Online Shops? Dafür haben wir 4 große deutsche Online Shops unter die Lupe genommen.

peak-cloppenburg.de

Die Faceted Navigation bei peak-cloppenburg.de

noindex, follow und Canonical

In der zweiten Kategorieebene (1. /damen/ & 2. /damen-bekleidung/) filtern wir nach gelber Farbe (/colorgroup-yellow/):

Das Robots-Tag steht auf “index, follow” und die URL des Canonicals zeigt auf die 2. Kategorieebene (/damen-bekleidung/).

Verfeinern wir die Suche und filtern zusätzlich noch nach Preis (40 - 50 €), ändert sich das Robots-Tag auf Noindex, Follow. Das Canonical zeigt ebenfalls auf die 2. Ebene (/damen-bekleidung/).

Filtern wir in der 2. Ebene (/damen-bekleidung/) nur nach der Marke “adidas Originals”, so ist hier schon beim 1. Filter das Robots-Tag auf noindex, follow gesetzt (im Gegensatz zur gelben Farbe). Das Canonical zeigt wieder auf die 2. Ebene (/damen-bekleidung/).

robots.txt Inhalte

Die robots.txt bietet keine Überraschungen. Ausgeschlossene Seiten sind zum Großteil auf das Shop-CMS zurückzuführen. Ein Indexierungsmanagement im Sinne relevanter und irrelevanter URLs mit Produkten ist nicht vorhanden. Die Faceted Navigation wird in der robots.txt nicht berücksichtigt.

nofollow interne Links

Es werden keine internen nofollow Links gesetzt

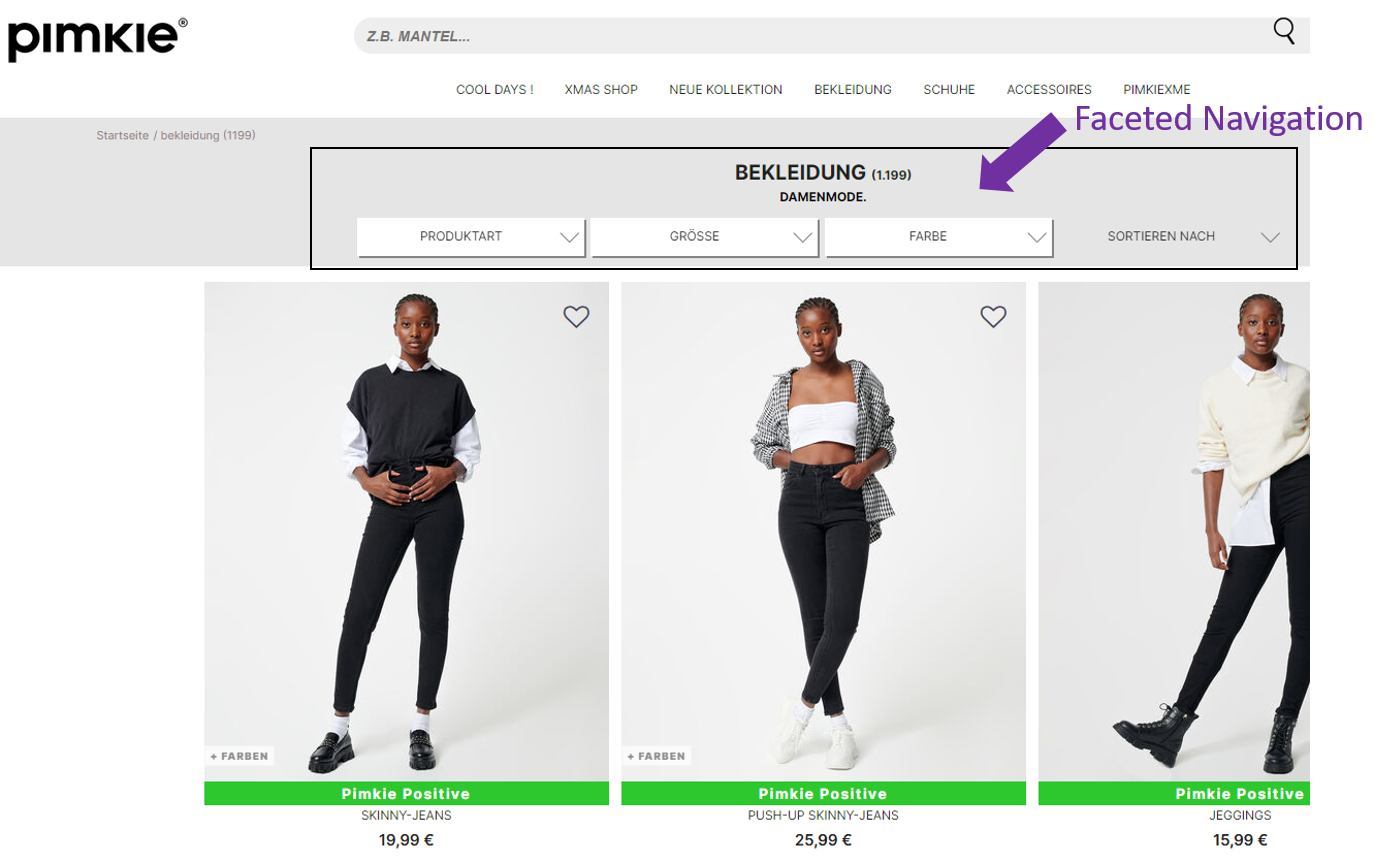

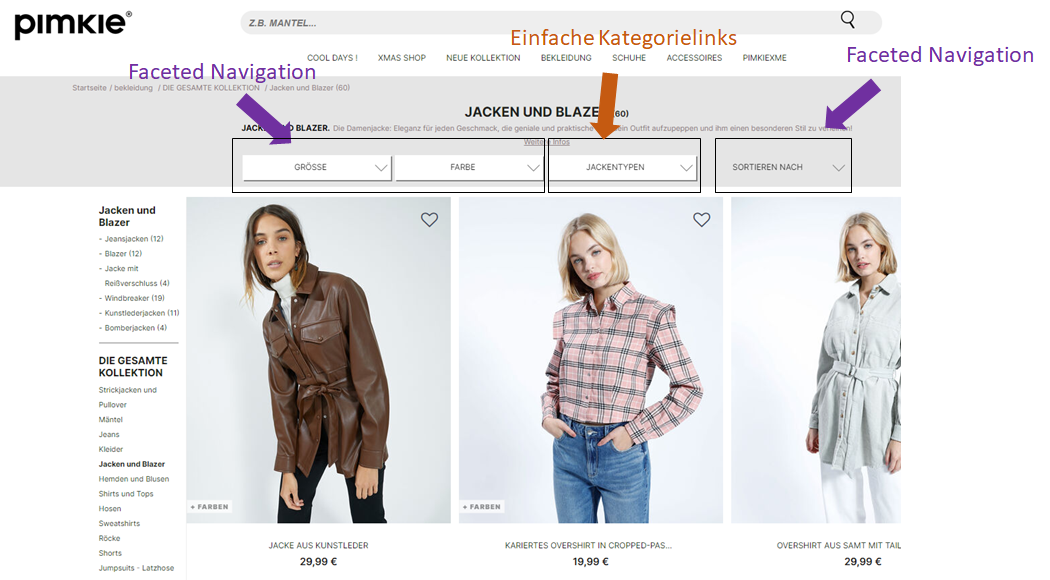

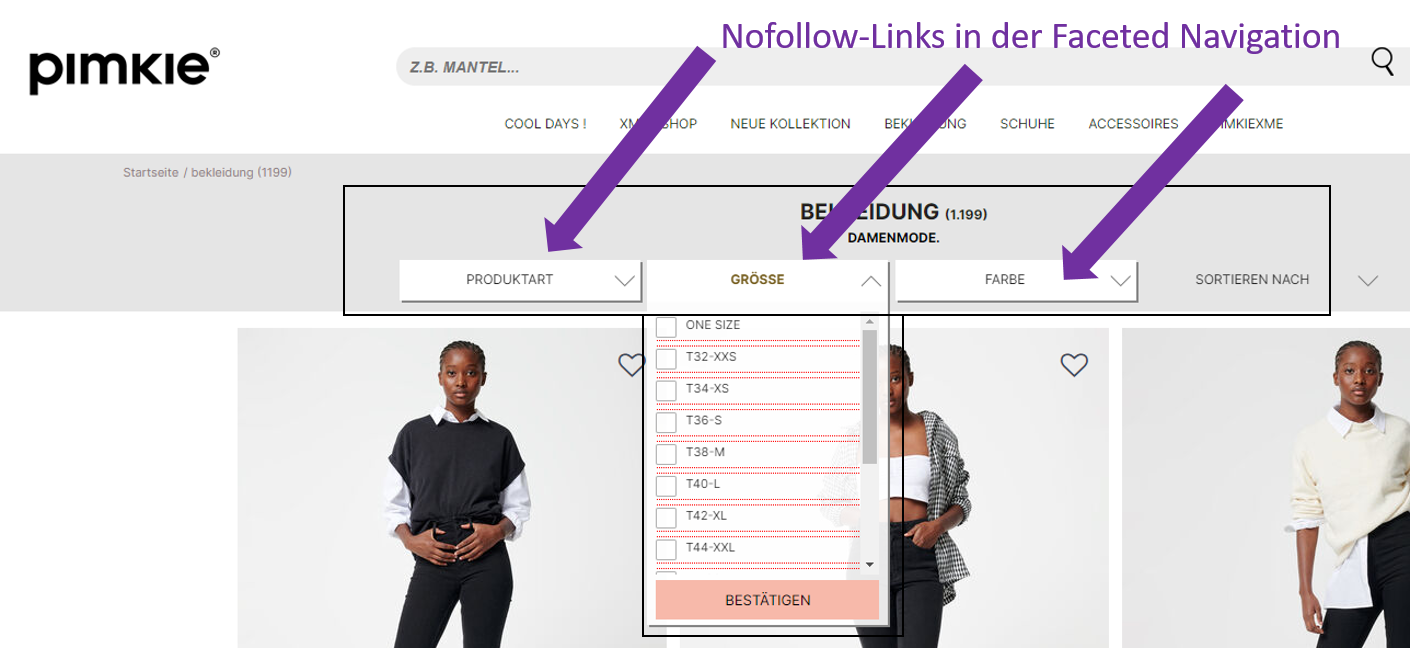

pimkie.de

noindex, follow und Canonical

In der ersten Kategorieebene (1. /c-bekleidung) filtern wir nach der Farbe schwarz/grau (?prefn1=refinementColor&prefv1=Schwarz%2FGrau).

https://www.pimkie.de/c-bekleidung?prefn1=refinementColor&prefv1=Schwarz%2FGrau

Das Robots-Tag wurde nicht definiert. Google wird diese Seite daher indexieren bzw. selbst entscheiden, da keine Anweisung hinterlegt ist. Das Canonical zeigt auf die 1. Kategorieebene (/c-bekleidung).

nofollow interne Links

In der Faceted Navigation werden die Links auf Nofollow gesetzt.

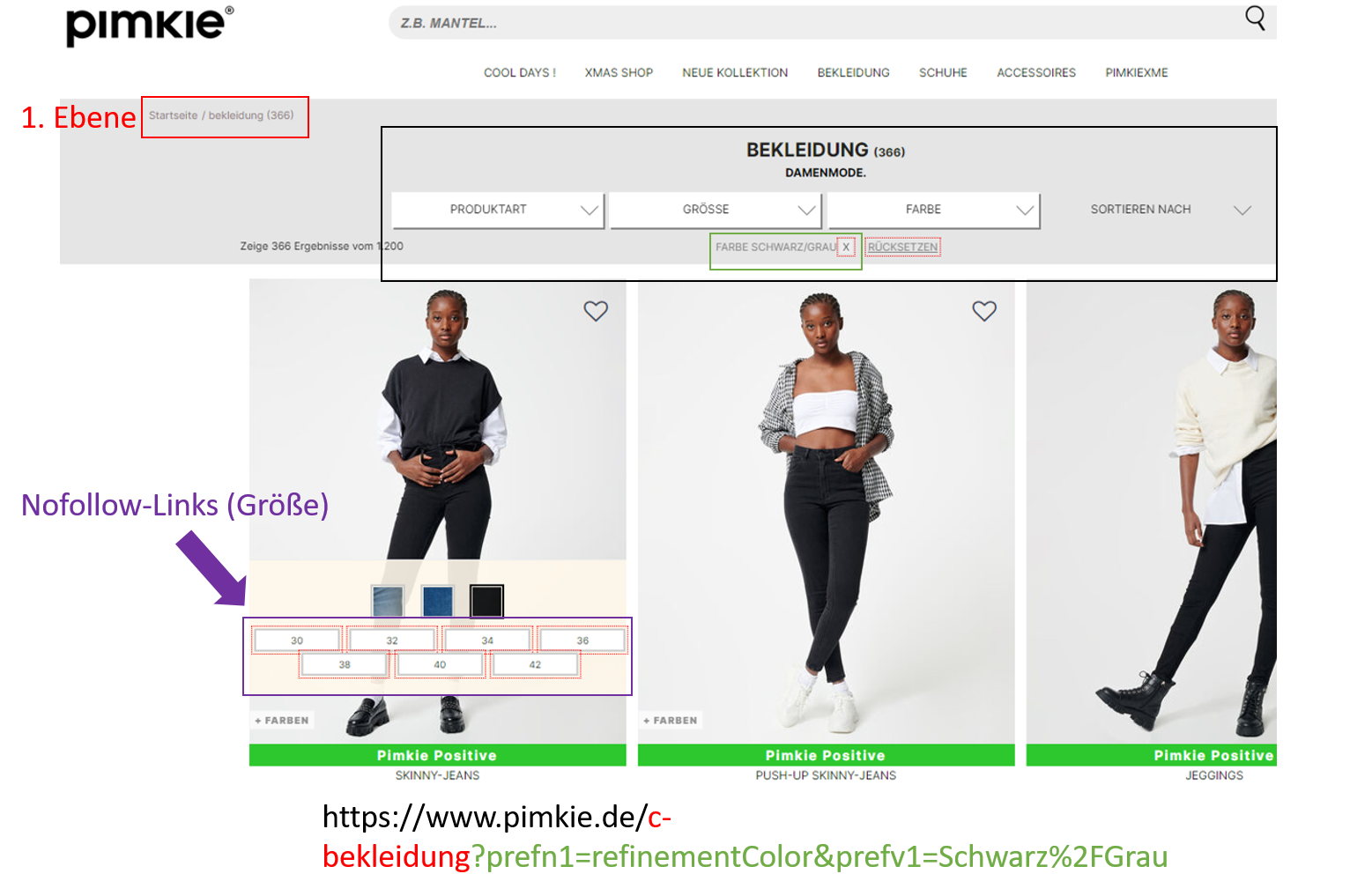

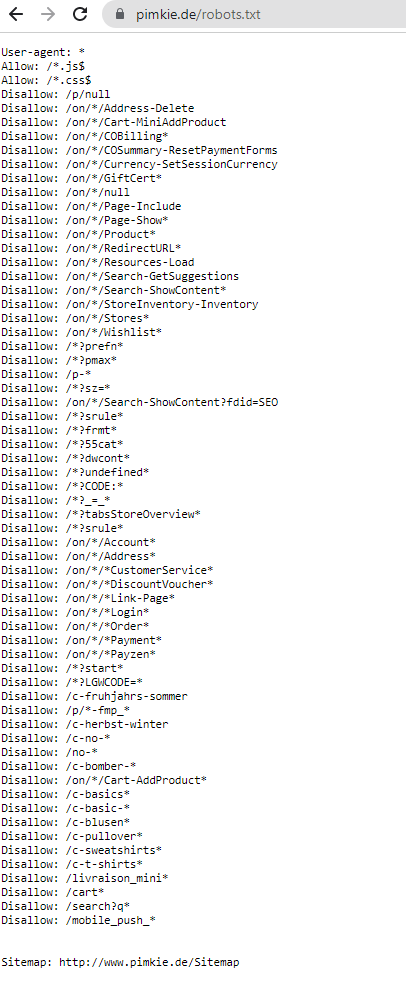

robots.txt Pimkie.de

Diese robots.txt bietet ein paar spannende Erkenntnisse. Neben ausgeschlossenen Shop-CMS Seiten wird dort auch die Faceted Navigation berücksichtigt. Denn beim Filtern der Faceted Navigation wird die URL um den Parameter “?prefn” erweitert. Der Eintrag “Disallow: /*?prefn*” in der robots.txt schließt diese URLs vollständig aus.

Außerdem werden auch einzelne Kategorien ausgeschlossen:

Disallow: /c-fruhjahrs-sommer

Disallow: /c-herbst-winter

Disallow: /c-bomber-*

Disallow: /c-basics*

Disallow: /c-basic-*

Disallow: /c-blusen*

Disallow: /c-pullover*

Disallow: /c-sweatshirts*

Disallow: /c-t-shirts*Während Einträge mit Platzhaltern (/c-bomber-* & /c-basic-*) schwer nachvollziehbar sind, können andere gut zugeordnet werden. Ein Versuch die ausgeschlossenen URLs aufzurufen kommt zu folgendem Resultat:

Ausgeschlossene URLs mit Bindestrich-Platzhaltern

- https://www.pimkie.de/c-bomber- = Status Code 404

- https://www.pimkie.de/c-basic- = Status Code 404

In der Kategorie Jacken und Blazer gibt es zwar die Unterkategorie Bomberjacken, die dazugehörige URL (https://www.pimkie.de/c-bomberjacken-2) wird allerdings nicht vom Disallow Eintrag erfasst.

“C-Basic” kann sich auf viele Kategorien beziehen. Wir haben Basic Shirts (https://www.pimkie.de/c-basic-shirts) als Unterkategorie der Shirts und Tops-Kategorie (https://www.pimkie.de/c-shirts-und-tops) ausmachen können. Offensichtlich schließt Pimkie die Kategorie Basic Shirts vom Index aus - bei einem Umfang von lediglich drei Produkten in der Kategorie nachvollziehbar.

Ausgeschlossene URLs ohne Bindestrich Platzhalter

- https://www.pimkie.de/c-sweatshirts = Status Code 200, selbstverweisender Canonical, keine Meta Robot Tags

- https://www.pimkie.de/c-pullover = Status Code 200, selbstverweisender Canonical, keine Meta Robot Tags

- https://www.pimkie.de/c-blusen = Status Code 200, selbstverweisender Canonical, keine Meta Robot Tags

- https://www.pimkie.de/c-t-shirts = Status Code 200, selbstverweisender Canonical, keine Meta Robot Tags

- https://www.pimkie.de/c-basics = Status Code 404

Diese Seiten existieren, bis auf /c-basics/, ausnahmslos im Online Shop. Trotz dem Ausschluss über die robots.txt werden alle von der jeweiligen Überkategorie mit einem do-follow-Link verlinkt. Dadurch wird Link Juice an Seiten vererbt, die eigentlich über die robots.txt vom Index ausgeschlossen wurden.

Ausgeschlossene URLs mit saisonalem Bezug

- https://www.pimkie.de/c-herbst-winter = Status Code 301

- Redirect auf: https://www.pimkie.de/c-die-gesamte-kollektion-1 = Status Code 200, selbstverweisender Canonical, keine Meta Robot Tags

- https://www.pimkie.de/c-fruhjahrs-sommer = Status Code 301

- Redirect auf: https://www.pimkie.de/c-die-gesamte-kollektion-2 = Status Code 200, selbstverweisender Canonical, keine Meta Robot Tags

Hierbei handelt es sich aller Wahrscheinlichkeit nach um alte URLs. Offensichtlich gab es bei pimkie in der Vergangenheit Kategorien mit saisonalem Bezug. Diese existieren inzwischen aber nicht mehr und sind mit einem Redirect auf das Produktsortiment umgeleitet.

Warum der Herbst & Winter Link in das Verzeichnis “Accessoires” und der Frühjahr & Sommer Link in das Verzeichnis Bekleidung umgeleitet wird, erschließt sich uns nicht ganz. Eine naheliegende Überlegung wäre, dass der Abverkauf von Accessoires im Herbst & Winter und der Abverkauf von Bekleidung im Frühling & Sommer besser läuft. Mit dem Redirect wird dann versucht die Saisonalität zu vererben.

Fazit

Die Faceted Navigation gehört zum Standard moderner Online Shops. Der positive Einfluss auf die User Experience ist zu groß, um als Shop-Betreiber darauf ernsthaft verzichten zu können. Es hängt aber natürlich auch vom Umfang des Produktsortiments ab. Kleine Shops können mit einer ordentlichen Menüführung die gleiche User Experience bieten.

Allerdings birgt die Umsetzung auch einige Gefahren. Schnell kann es zu Problemen mit dem Crawl Budget oder einer unerwünschten Verteilung von Link Juice kommen. Daher ist ein gut durchdachtes Indexierungsmanagement notwendig. Das ist aber leichter gesagt, als getan. Denn einerseits sind Logikfehler recht naheliegend und andererseits kann schon der Ausschluss eines einzigen falschen Verzeichnisses zu Ranking-Einbrüchen führen.

Das zeigt sich auch in der Praxis. Während die allermeisten (großen) Online Shops zwar eine Faceted Navigation nutzen, verfolgen sie unterschiedliche Ansätze potentielle Probleme zu beheben. Das verläuft nicht immer erfolgreich. So finden sich auch bei bekannten E-Commerce Größen Flüchtigkeits- oder Logikfehler im Indexierungsmanagement.

Versuche bei der Implementierung einer Faceted Navigation einfach alle Eventualitäten zu bedenken. Das betrifft alle Verzeichnisse und Parameter, die in deinem Shop überhaupt generiert werden können. Und achte auf die interne Verteilung des Link Juice. Dann kann auch nichts schiefgehen. Und wenn doch, stehen dir Tobias Gabel und HammerSEO gerne beratend zur Seite