Für einige Inhalte auf deiner Website ist die Indexierung durch Suchmaschinen nicht notwendig. Um die Indexierung von unnötigen Seiten zu verhindern, kannst du das Robots-Meta-Tag oder das X-Robots-Tag nutzen. In der technischen SEO kommt diese Fragestellung sehr oft vor und es ist umso wichtiger, die Antworten darauf zu haben.

Allerdings werden die robots.txt-Datei und die Robots-Meta-Tags häufig falsch eingesetzt. Das führt zu unklaren und miteinander in Konflikt stehenden Anweisungen, die nicht zum gewünschten Ergebnis führen: dass eine Seite nicht wirksam vor der Indexierung bewahrt wird.

In dieser Anleitung möchten wir dir das Verständnis darüber geben, wie die Robots-Meta-Tags und das X-Robots-Tag genutzt werden, um die Indexierung der Inhalte deiner Website zu steuern, und dir beim Aufspüren häufig vorkommender Fehler helfen.

Konkret werden wir uns folgende Punkte anschauen:

- Was sind Robots-Meta-Tags?

- Verstehe die Attribute und Direktiven der Robots-Meta-Tags

- Code-Beispiele für das Meta-Robots-Tag

- Nutzung von Meta-Robots-Tags zur Steuerung von Snippets

- Was ist das X-Robots-Tag

- Wie du die Robots-Meta-Tags und das X-Robots-Tag einrichtest

- Häufig vorkommende Fehler bei Meta-Robots-Angaben

Was sind Robots-Meta-Tags?

Ein Robots-Meta-Tag – auch als Robots-Tag bezeichnet – ist ein Stück HTML-Code, das innerhalb des <head></head>-Bereichs einer Internetseite platziert wird. Es dient zur Steuerung von Suchmaschinen beim Crawlen und Indexieren einer URL.

So sieht ein Robots-Meta-Tag im Quelltext einer Seite aus:

<meta name="robots" content="noindex" />Diese Tags sind jeweils spezifisch für eine einzelne Seite. Sie ermöglichen dir, den Suchmaschinen Anweisungen zu geben, wie sie diese Seite behandeln sollen und ob sie in den Index aufgenommen werden soll oder nicht.

Wofür werden Robots-Meta-Tags genutzt?

Robots-Meta-Tags werden eingesetzt, um zu steuern, wie Google den Inhalt deiner Internetseite indexiert. Dazu zählen:

- Ob eine Seite in den Suchergebnissen angezeigt werden soll oder nicht

- Ob den Links auf der Seite gefolgt werden soll oder nicht (auch dann, wenn sie für die Indexierung gesperrt ist)

- Aufforderungen, die Bilder auf einer Seite nicht zu indexieren

- Aufforderungen, keine gecachten Ergebnisse der Seite in den SERPs anzuzeigen

- Aufforderungen, kein Snippet (Meta Description) für die Seite in den SERPs anzuzeigen

Wir werden uns in diesem Tutorial die verschiedenen Attribute und Direktiven anschauen. So erlangst du ein besseres Verständnis, wie du die Robots-Meta-Tags einsetzen kannst. Außerdem zeigen wir Code-Beispiele, die du direkt übernehmen kannst. Füge sie in den Header deiner Seite ein, um den Suchmaschinen Anweisungen zu geben, wie sie deine Seite indexieren sollen.

Verstehe die Attribute und Direktiven der Robots-Meta-Tags

Die Nutzung der Robots-Meta-Tags ist ziemlich einfach, wenn du verstanden hast, wie du die beiden Attribute „name“ und „content“ setzt. Beide Attribute sind erforderlich. Daher musst du für beide jeweils einen Wert einsetzen.

Schauen wir uns die Erklärung zu diesen Attributen einmal genauer an.

Name

Das „name“-Attribut steuert, dass Crawler und Bots (die User-Agents, auch als UA bezeichnet) den Anweisungen folgen, die im Robots-Meta-Tag enthalten sind.

Um allen Crawlern zu befehlen, den Anweisungen zu folgen, verwendest du

name="robots"

In den meisten Fällen passt diese Standardeinstellung. Aber du kannst so viele Meta-Robots-Tags verwenden wie nötig, um Anweisungen für verschiedene Crawler zu spezifizieren.

Um unterschiedliche Crawler anzusprechen, bietet sich die Nutzung mehrerer Tags an:

<meta name="googlebot" content="noindex">

<meta name="googlebot-news" content="nosnippet">Es gibt Hunderte verschiedener User-Agents. Die häufigsten davon sind:

- Google: Googlebot (eine vollständige Liste der Crawler von Google kannst du hier ansehen)

- Bing: Bingbot (eine vollständige Liste der Crawler von Bing kannst du hier ansehen)

- DuckDuckGo: DuckDuckBot

- Baidu: Baiduspider

- Yandex: YandexBot

Content

Das „content“-Attribut nutzt du, um dem spezifizierten User-Agent Anweisungen zu geben.

Unbedingt zu beachten: Wenn du keine Meta-Robots-Tags auf einer Seite spezifizierst, wird standardmäßig die Seite indexiert und der Crawler folgt allen Links (es sei denn, es wurde für sie das Inline-Attribut rel=”nofollow” angegeben).

Zu den unterschiedlichen Direktiven, du du verwenden kannst, zählen:

- index (die Seite wird in den Index aufgenommen) [Hinweis: Diese Anweisung ist nicht notwendig. Sofern keine Noindex-Direktive angegeben wurde, wird automatisch von "index" ausgegangen)

- noindex (die Seite wird nicht in den Index aufgenommen oder in den SERPs angezeigt)

- follow (den Links auf der Seite wird gefolgt, um andere Seiten zu entdecken)

- nofollow (den Links auf der Seite wird nicht gefolgt)

- none (eine Abkürzung für "noindex, nofollow")

- all (eine Abkürzung für "index, follow")

- noimageindex (Bilder auf der Seite werden nicht indexiert)

- noarchive (keine Anzeige einer gecachten Version der Seite in den SERPs)

- nocache (entspricht noarchive, aber nur für den Bingbot)

- nositelinkssearchbox (keine Anzeige einer Suchbox für deine Website in den SERPs)

- nopagereadaloud (Sprachdienste dürfen deine Seite nicht laut vorlesen)

- notranslate (keine Anzeige von Übersetzungen der Seite in den SERPs)

- unavailable_after (Angabe eines Zeitpunkts, nach dem die Seite nicht mehr indexiert werden soll)

Eine vollständige Liste der von Google unterstützten Direktiven findest du hier. Diese Anweisungen werden von Bing unterstützt.

Code-Beispiele für das Meta-Robots-Tag

Suchst du Beispiele für Meta-Robots-Tags, die du verwenden kannst, um zu steuern, wie Suchmaschinen deine Seiten im Internet crawlen und indexieren? Die unten aufgeführten Beispiele decken die häufigsten Szenarien ab:

Indexiere die Seite nicht, aber folge den Links zu anderen Seiten

<meta name="robots" content="noindex, follow" />Indexiere die Seite nicht und folge auch nicht den Links zu anderen Seiten

<meta name="robots" content="none" />Indexiere die Seite, aber folge nicht den Links zu anderen Seiten:

<meta name="robots" content="nofollow" />Zeige keine gecachte Kopie der Seite in den SERPs an:

<meta name="robots" content="noarchive" />Indexiere nicht die Bilder auf einer Seite:

<meta name="robots" content="noimageindex" /Zeige die Seite in den SERPs nach dem angegebenen Datum/Uhrzeit nicht mehr an:

<meta name="robots" content="unavailable_after: Friday, 01-Jan-21 12:59:59 ET" />Falls nötig, kannst du Direktiven kommagetrennt in einem einzelnen Tag aufführen.

Wenn du zum Beispiel nicht möchtest, dass den Links auf einer Seite gefolgt wird, und auch Bilder auf ihr nicht indexiert werden sollen, nutzt du:

<meta name="robots" content="nofollow, noimageindex" /Nutzung von Meta-Robots-Tags zur Steuerung von Snippets

Am häufigsten kommen Meta-Robots-Tags zwar zum Einsatz, um zu steuern, ob eine Seite indexiert werden soll oder nicht und ob die Links auf dieser Seite von Suchmaschinen gecrawlt werden sollen oder nicht. Aber sie lassen sich auch nutzen, um Kontrolle über die Snippets in den SERPs zu haben.

Im September 2019 gab Google bekannt, dass Webmaster in der Lage sind, ein Set von Methoden zu nutzen, die eine feinkörnigere Konfiguration der Vorschau-Inhalte für die Seite zulassen

Dafür kannst du folgende Meta-Robots-Tags nutzen:

- nosnippet (zeige kein Snippet/keine Meta Description für die Seite in den SERPs an)

- max-snippet:[number] (spezifiziere die maximale Textlänge eines Snippets in Zeichen)

- max-video-preview:[number] (spezifiziere die maximale Dauer einer Videovorschau in Sekunden)

- max-image-preview:[setting] (spezifizierde die maximale Größe eines Vorschaubilds als “none”, “standard” oder “large”")

Nutze den folgenden Code, um zu steuern, wie die Snippets deiner Internetseite angezeigt werden:

Keine Snippets für eine Seite in den SERPs anzeigen:

<meta name="robots" content="nosnippet" />Die maximale Länge eines Text-Snippets auf 150 Zeichen begrenzen:

<meta name="robots" content="max-snippet:150" />Die maximale Länge einer Video-Vorschau auf 20 Sekunden begrenzen:

<meta name="robots" content="max-video-preview:30" />Die maximale Größe eine Vorschaubilds auf „groß“ setzen:

<meta name="robots" content="max-image-preview:large" />Die Tags lassen sich auch miteinander kombinieren. So erhältst du noch mehr Kontrolle über die Snippets deiner Seite. Wenn du zum Beispiel die maximale Länge deines Snippets auf 150 Zeichen setzen und große Vorschaubilder zulassen möchtest, verwendest du:

<meta name="robots" content="max-snippet:150, max-image-preview:large" />Falls deine Zielgruppe sich in Frankreich befindet, musst du diesen Tags besondere Aufmerksamkeit widmen. Denn das französische Urheberrecht lässt nicht zu, dass die Snippets für deine Website überhaupt angezeigt werden – es sei denn, du stimmst ihrer Nutzung per Opt-in zu.

Falls deine Snippets uneingeschränkt angezeigt werden sollen, kannst du den unten gezeigten Code über die gesamte Website im Kopfbereich der Seiten unterbringen:

<meta name="robots" content="max-snippet:-1, max-image-preview:large, max-video-preview:-1" />Was ist das X-Robots-Tag

Eine alternative Möglichkeit, um zu kontrollieren, wie Suchmaschinen deine Unterseiten crawlen und indexieren, ist die Nutzung des X-Robots-Tags anstatt von Meta-Robots-Tags.

Die Implementierung von Meta-Robots-Tags in HTML-Seiten ist ziemlich einfach. Beim X-Robots-Tag ist das etwas komplizierter. Wenn du steuern willst, wie Inhalte behandelt werden sollen, die nicht im HTML-Format vorliegen – etwa eine PDF-Datei – ist das X-Robots-Tag unverzichtbar.

Dies ist ein HTTP-Antwort-Header anstatt eines HTML-Tags. Jede Direktive, die als Meta-Robots-Tag genutzt werden kann, lässt sich auch als X-Robots-Tag einsetzen.

Hier siehst du ein Beispiel, wie eine Header-Response des X-Robots-Tags aussieht:

x-robots-tag: noindex, nofollow

Um das X-Robots-Tag zu nutzen, benötigst du Zugriff auf die header.php, die .htaccess oder die Serverkonfigurationsdatei deiner Website. Falls du darauf nicht zugreifen kannst, musst du Meta-Robots-Tags einsetzen, um den Crawlern Direktiven zu geben.

Wann solltest du das X-Robots-Tag einsetzen?

Die Verwendung des X-Robots-Tags ist nicht so unkompliziert wie bei den Meta-Robots-Tags. Allerdings ermöglicht es dir, Suchmaschinen Anweisungen zu geben, wie sie andere Dateitypen crawlen und indexieren sollen.

Setze das X-Robots-Tag ein, wenn:

- du steuern musst, wie Suchmaschinen Dateitypen crawlen und indexieren, die nicht aus HTML bestehen

- du Direktiven auf globaler Ebene (websiteübergreifend) anstatt nur auf Seitenebene ausgeben musst

Wie du die Robots-Meta-Tags und das X-Robots-Tag einrichtest

Die Einrichtung von Robots-Meta-Tags ist in der Regel einfacher als beim X-Robots-Tag. Aber bei beiden Methoden zur Steuerung, wie Suchmaschinen deine Website crawlen und indexieren, hängt die Art der Implementierung von deinem CMS und/oder deinem Servertyp ab.

So benutzt du Meta-Robots-Tags und das X-Robots-Tag in häufig vorkommenden Konfigurationen:

- Nutzung von Robots-Meta-Tags in HTML-Code

- Nutzung von Robots-Meta-Tags bei WordPress

- Nutzung von Robots-Meta-Tags bei Shopify

- Nutzung des X-Robots-Tags auf einem Apache-Server

- Nutzung des X-Robots-Tags auf einem Nginx-Server

Nutzung von Robots-Meta-Tags in HTML-Code

Falls du in der Lage bist, den HTML-Code deiner Seite zu bearbeiten, fügst du deine Robots-Meta-Tags einfach direkt in den <head>-Bereich der Seite ein.

Wenn du beispielsweise Suchmaschinen von der Indexierung der Seite abhalten möchtest, sie aber den Links folgen sollen, verwendest du:

<meta name="robots" content="noindex, follow" />Nutzung von Robots-Meta-Tags bei WordPress

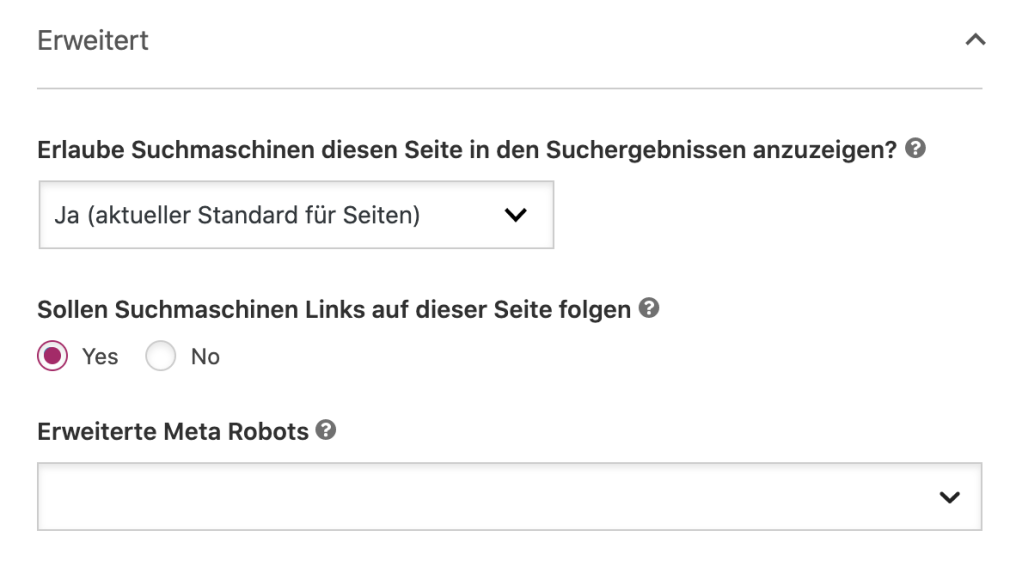

Falls du Yoast SEO nutzt, öffnest du den Tab „Erweitert“ im Block unterhalb des Seiten-Editors.

Du kannst die „Noindex“-Direktive aktivieren, indem du „Erlaube Suchmaschinen diese Seite in den Suchmaschinen anzuzeigen?“ im Dropdown-Feld auf „Nein“ setzt. Ebenso verhinderst du, dass Links verfolgt werden, indem du „Sollen Suchmaschinen Links auf dieser Seite folgen“ auf „Nein“ setzt.

Alle anderen Direktiven musst du im Feld „Erweiterte Meta Robots“ implementieren.

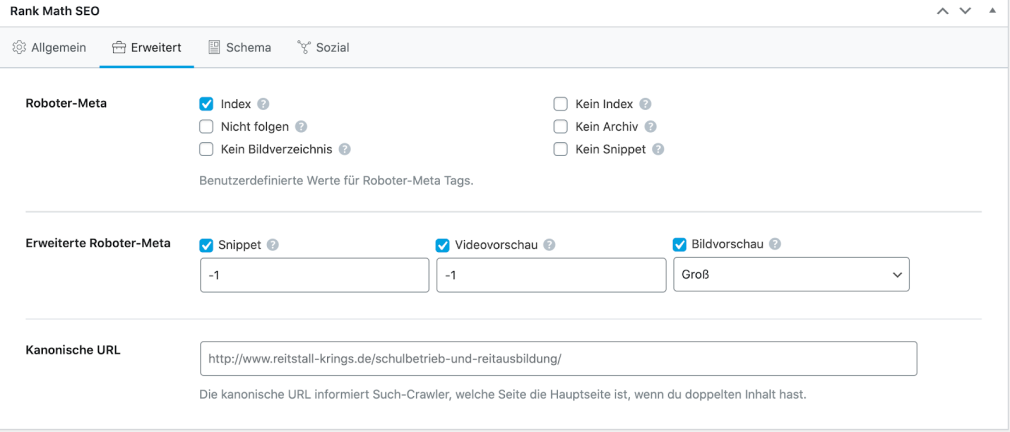

If you're using RankMath, you can select the robots directives that you wish apply straight from the Advanced tag of the meta box: Falls du RankMath nutzt, kannst du die Robots-Direktiven deiner Wahl direkt aus dem “Erweitert“-Tab der Meta-Box setzen.

Nutzung von Robots-Meta-Tags bei Shopify

Um die Robots-Meta-Tags unter Shopify zu implementieren (siehe auch Shopify SEO), musst du den <head>-Bereich in deiner Layout-Datei theme.liquid bearbeiten.

Um Anweisungen für eine bestimmte Seite zu setzen, fügst du den unten gezeigten Code in diese Datei ein:

{% if handle contains 'page-name' %}

<meta name="robots" content="noindex, follow">

{% endif %}Dieser Code gibt Suchmaschinen die Anweisung, /page-name/ nicht zu indexieren, aber allen Links auf dieser Seite zu folgen.

Um diese Anweisung für mehrere unterschiedliche Seiten zu setzen, musst du jeweils separate Einträge vornehmen.

Nutzung des X-Robots-Tags auf einem Apache-Server

Um das X-Robots-Tag auf einem Apache-Server zu verwenden, fügst du folgenden Code in die .htaccess- oder httpd.config-Datei deiner Website ein.

<Files ~ "\.pdf$">

Header set X-Robots-Tag "noindex, follow"

</Files>Das oben gezeigte Beispiel setzt den Dateityp auf .pdf und weist Suchmaschinen an, nicht die Datei selbst zu indexieren, aber allen in ihr enthaltenen Links zu folgen.

Nutzung des X-Robots-Tags auf einem Nginx-Server

Falls dein Server unter Nginx läuft, fügst du Folgendes in die .conf-Datei deiner Website ein:

location ~* \.pdf$ {

add_header X-Robots-Tag "noindex, follow";

}Dadurch wird ein Noindex-Attribut für eine .pdf-Datei angewendet. Außerdem folgen die Suchmaschinen allen Links in der Datei.

Häufig vorkommende Fehler bei Meta-Robots-Angaben

Nicht selten kommt es zu Fehlern, wenn Suchmaschinen Anweisungen erhalten, wie sie eine Seite crawlen und indexieren sollen. Die häufigsten sind:

- Meta-Robots-Direktiven auf einer Seite, die in robots.txt gesperrt ist.

- Einfügen von Robots-Direktiven in die robots.txt-Datei

- Entfernen von Seiten aus Sitemaps mit einer Noindex-Direktive

- Versehentliches Ausschließen von Suchmaschinen vom Crawling einer ganzen Website

Meta-Robots-Direktiven auf einer Seite, die in robots.txt gesperrt ist

Sofern für eine Seite in deiner robots.txt-Datei eine Disallow-Anweisung hinterlegt ist, sind die Bots des Suchmaschinen nicht in der Lage, die Seite zu crawlen und somit Direktiven zu erkennen, die in den Robots-Meta-Tags oder einem X-Robots-Tag stehen.

Stelle sicher, dass alle Seiten mit derartigen Anweisungen für User-Agents gecrawlt werden können.

Falls eine Seite noch nie im Index war, sollte eine Disallow-Regel in der robots.txt ausreichen, um zu verhindern, dass sie in den Suchergebnissen auftaucht. Trotzdem ist ein entsprechendes Meta-Robots-Tag zusätzlich empfehlenswert.

Einfügen von Robots-Direktiven in die robots.txt-Datei

Auch wenn dies offiziell nie von Google unterstützt wurde, war es in der Vergangenheit möglich, eine funktionierende Noindex-Direktive in die robots.txt-Datei einer Website einzufügen.

Dass dies nicht mehr länger der Fall ist, wurde von Google 2019 bestätigt.

Entfernen von Seiten aus Sitemaps mit einer Noindex-Direktive

Wenn du versuchst, eine Unterseite mittels Noindex-Direktive aus dem Index zu entfernen, behalte die Seite in der Sitemap deiner Website, bis dieser Vorgang abgeschlossen ist.

Denn wenn du die Seite noch vor der Deindexierung entfernst, kann es dabei Verzögerungen geben.

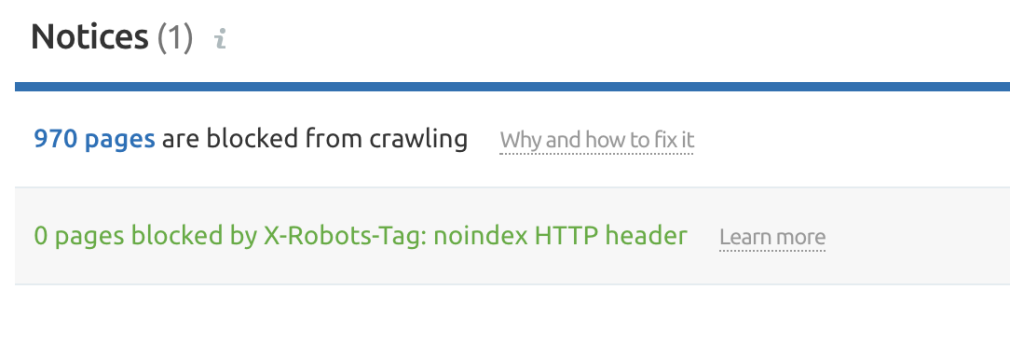

Versehentliches Ausschließen von Suchmaschinen vom Crawling einer ganzen Website

Ein Fall, der leider häufig vorkommt: Robots-Anweisungen werden in einer Staging-Umgebung verwendet. Aus Versehen werden sie beim Umzug der Website auf einen Live-Server nicht entfernt. Die Folgen können verheerend sein.

Überprüfe lieber zweimal, dass alle vorhandenen Robots-Direktiven korrekt gesetzt sind, bevor du eine Website von einer Staging-Plattform auf eine Live-Umgebung umziehst.

Du kannst das Site Audit Tool von Semrush anwenden, bevor du die Migration auf eine Live-Plattform durchführst. So kannst du alle Seiten aufspüren, die entweder durch Meta-Robots-Tags oder das X-Robots-Tag gesperrt sind.

Nimm dir die Zeit, um die Funktionsweise der verschiedenen Direktiven und ihre Anwendungsmöglichkeiten zu begreifen. So kannst du Fehlern in der technischen SEO vorbeugen. Wenn du ausreichend steuern kannst, wie deine Seiten gecrawlt und indexiert werden, kannst du unerwünschte Seiten aus den SERPs heraushalten und Suchmaschinen am Verfolgen unnötiger Links hindern. Außerdem erhältst du unter anderem Kontrolle darüber, wie die Snippets deiner Seite angezeigt werden.

Fang einfach an – und richte deine Robots-Meta-Tags sowie X-Robots-Tags ein, um sicherzustellen, dass deine Website reibungslos mit den Suchmaschinen interagiert!