Der Artikel im Überblick:

- Hier erklären wir dir, wie dir die Google-Qualitätsrichtlinien nach dem Update vom 28. Juli 2022 helfen können, Content für E-A-T und YMYL zu optimieren und deine Rankings zu verbessern.

- E-A-T steht für „Expertise, Authoritativeness, Trustworthiness“ („Expertise, Autorität, Vertrauenswürdigkeit“) und YMYL steht für „Your Money or Your Life“ („Dein Geld oder dein Leben“).

- Google benutzt E-A-T und YMYL, um die Qualität von Webseiten zu bewerten.

Wenn Sie jemals darüber gerätselt haben, wie der Ranking-Algorithmus von Google die Reihenfolge der Suchergebnisse bestimmt, sind Sie damit nicht allein.

Google gibt sich geheimnisvoll und wortkarg, wenn es um die Funktionsweise der Suchmaschine und ihre Updates geht, ganz zu schweigen von den Auswirkungen für SEO und Vermarkter. Viele in der Branche betätigen sich daher als Detektive, um dies herauszufinden und ihre Rankings vor dem Abstieg zu bewahren.

Manchmal aber liefert Google uns allen wie beiläufig einen schönen Informationshappen frei Haus.

Im Jahr 2015 veröffentlichte Google seine Richtlinien zur Bewertung von Suchergebnissen ( Search Quality Evaluator Guidelines), als eine durchgesickerte Version des Dokuments im Web die Runde machte.

Diese Richtlinien enthalten drei goldene Schlüssel zum Verständnis der Art und Weise, wie Google Webseiten sieht und qualitativ hochwertige Inhalte von minderwertigen unterscheidet:

Was ist E-A-T?

E-A-T – Expertise, Autorität, Vertrauenswürdigkeit ("Trustworthiness"), oder Seitenqualität

Was ist Beneficial Purpose?

Beneficial Purpose – nützlicher Zweck

Was ist YMYL?

YMYL – Your Money or Your Life ("Dein Geld oder dein Leben")

Technisch gesehen sind die Richtlinien ein Hilfsmittel für die weltweit rund 14.000 Personen, die im Auftrag von Google die Qualität von Suchergebnissen bewerten und dadurch prüfen, wie gut der Google-Algorithmus seine Arbeit macht. Daher vermittelt das Dokument wertvolle Einblicke in die Maßstäbe, an denen Google schlechte von guten Webseiten unterscheidet.

Mit dem Update im Juli 2022 hat Google erstmals zusätzlich ein Dokument veröffentlicht, in dem übersichtlich erklärt wird, wie die Qualitätsbewertung durch menschliche Prüfer funktioniert und in die Gestaltung der Suchalgorithmen einfließt. Spannende und wichtige Informationen für alle, die mit Websuche und SEO zu tun haben!

Auch bei den Definitionen von E-A-T und YMYL hat sich mit dem letzten Update noch mal einiges verändert. Gleich bleibt aber, was sie im Kern bedeuten und dass sie extrem wichtig für das Ranking bei Google sind.

Im Folgenden erklären wir dir im Überblick, was du darüber wissen musst.

Nützlicher Zweck, E-A-T und YMYL: Wie die Google-Suche Seiten- und Content-Qualität definiert

Googles Qualitätsrichtlinien wurden zweimal aktualisiert: am 20. Juli 2018 und am 16. Mai 2019. Seit der ursprünglichen Veröffentlichung wurden außerdem mehrere Algorithmus-Updates durchgeführt, darunter das Google June Core Update im Jahr 2019.

Dieser Leitfaden berücksichtigt alle Informationen zu den aktuellen Updates, um zu einem aktuellen Verständnis von E-A-T und YMYL zu gelangen.

Behalten wir dabei im Hinterkopf, dass die Qualitätsrichtlinien nur Hinweise auf die Ranking-Faktoren der Google-Suche geben, keine endgültigen Antworten. Wir können sie nur analysieren und daraus Schlüsse ziehen, was das alles konkret bedeutet.

Darin findet sich jedoch mehr als genug, um sicherzustellen, dass unser Content die Kriterien erfüllt.

Nützlicher Zweck: Alle Websites sollten ihn haben

Eine der wichtigsten Änderungen des ersten Updates war die Betonung eines neuen Konzepts namens „nützlicher Zweck“, im Original „beneficial purpose“.

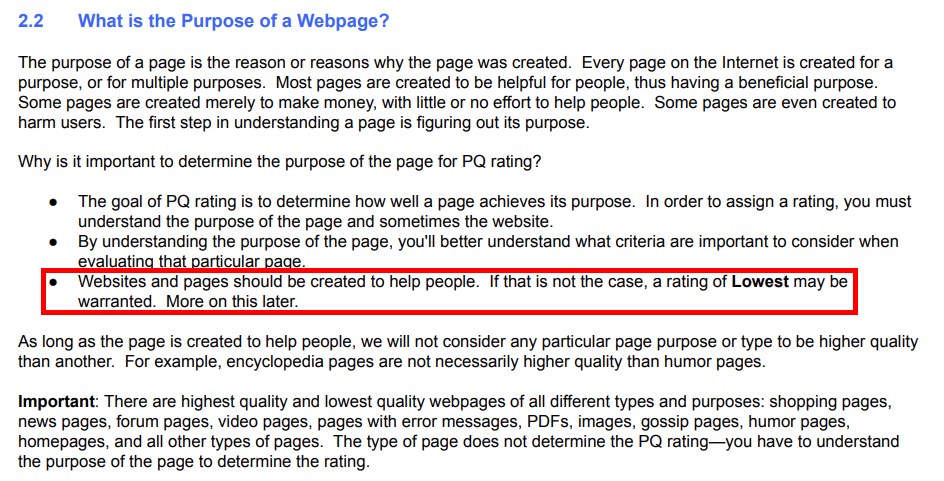

Google verweist früh im aktualisierten Text auf dieses Konzept, nämlich in Abschnitt 2.2: Was ist der Zweck einer Webseite? Hier ist er in der Version von 2022:

2.2 Was ist der Zweck einer Webseite?

Der Zweck einer Seite entspricht dem Grund oder den Gründen, warum sie erstellt wurde. Jede Seite im Internet wird für einen Zweck oder mehrere Zwecke erstellt. Die meisten Seiten werden erstellt, um für Nutzer hilfreich zu sein und somit einen nützlichen Zweck zu erfüllen. Einige Seiten werden nur erstellt, um Geld zu verdienen, ohne den Nutzern zu helfen. Einige Seiten haben sogar den Zweck, Nutzern Schaden zuzufügen. Der erste Schritt zum Verständnis einer Seite besteht darin, ihren Zweck herauszufinden.

Warum ist der Zweck der Seite wichtig für die Bewertung der Seitenqualität?

- Im Rahmen der Qualitätsbewertung ist festzustellen, wie gut eine Seite ihren Zweck erfüllt. Um eine Bewertung zuzuweisen, müssen Sie daher den Zweck der Seite und manchmal der gesamten Website verstehen.

- Wenn Sie den Zweck der Seite verstehen, wissen Sie genauer, welche Kriterien bei der Beurteilung dieser spezifischen Seite zu berücksichtigen sind.

- Websites und Seiten sollten Nutzern helfen. Websites und Seiten, die mit der Absicht erstellt wurden, Schaden zu verursachen, Nutzer zu täuschen oder Geld zu verdienen, ohne zu versuchen, Nutzern zu helfen, erhalten die niedrigste Qualitätsbewertung. Mehr dazu später.

Solange die Seite erstellt wurde, um Nutzern zu helfen, betrachten wir keinen bestimmten Seitenzweck oder -typ als qualitativ hochwertiger relativ zu anderen. Beispielsweise sind Enzyklopädieseiten nicht zwingend von höherer Qualität als Humorseiten.

„Websites und Seiten sollten dem Zweck dienen, Menschen zu helfen.“

Die Qualitätsbewerter sind aufgefordert, sich zuerst klarzumachen, für welchen Zweck eine Seite bestimmt ist (Seite 22). Die Qualitätseinstufung richtet sich dann nach zwei Fragen:

- Wie gut erfüllt die Seite ihren Zweck?

- Ist es ein nützlicher Zweck?

Google nennt einige Beispiele für nützliche Zwecke. Auch eine alberne Humorseite kann beispielsweise durchaus ein hohes Qualitätsrating erhalten, wenn sie ihre Zweck erfüllt, die Leser zu amüsieren.

Dabei sollst du darauf achten und einen SEO Content erstellen, welcher obigen Kriterium nicht widerspricht.

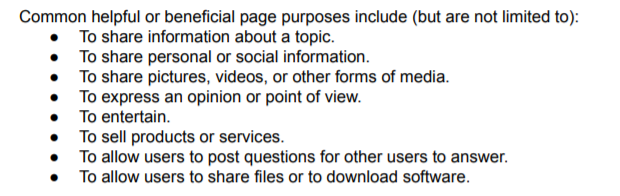

Zu den allgemeinen hilfreichen oder nützlichen Seitenzwecken gehören (ohne Anspruch auf Vollständigkeit):

- Um Informationen zu einem Thema auszutauschen.

- Um persönliche oder soziale Informationen zu teilen.

- Um Bilder, Videos oder andere Medien zu teilen.

- Um Meinungen oder Standpunkte zu äußern.

- Um zu unterhalten.

- Um Produkte oder Dienstleistungen zu verkaufen.

- Um Fragen zu stellen und zu beantworten.

- Um Dateien freizugeben oder Software herunterzuladen.

Daher gelten je nach Zweck andere Anforderungen an die geprüften Websites. Wenn diese nur dem Zweck dienen, Geld zu verdienen, ohne zu versuchen, dem Nutzer zu helfen, riskieren sie eine Einstufung in der Kategorie „schlecht“, weil der nützliche Zweck fehlt.

Bevor du dich erschreckst: Natürlich macht nicht die kommerzielle Absicht eine Seite schlecht, sondern das Fehlen von Inhalten, die für Besucher nützlich sind. Kommerzielle Absichten und Werbeanzeigen an sich sind ausdrücklich kein Grund für eine schlechtere Bewertung.

Das Konzept „nützlicher Zweck“ spielte auch eine wichtige Rolle in Googles Algorithmus-Update von Juni 2018. Insbesondere John Mueller und Danny Sullivan deuteten seinerzeit an, dass Websites, deren Rankings ins Stocken gerieten, „nichts zu reparieren“ hätten und das Update breiter aufgestellt war.

We tell lots of things to do. Improve site speed. Consider secure. Etc. But that's not what this update was about. It's broad. And respectfully, I think telling people there's no particular thing to "fix" is indeed helpful. It means, hopefully, they think more broadly...

— Danny Sullivan (@dannysullivan) August 1, 2018

Wir geben viele Tipps. Die Seitenladezeit verbessern. An die Sicherheit denken. Usw. Aber darum ging es bei diesem Update nicht. Es ist ein breites Update. Und bei allem Respekt, ich glaube schon, dass es nützlich ist, wenn wir sagen, dass es nichts Bestimmtes zu „reparieren“ gibt. Das bedeutet hoffentlich, dass die Menschen anfangen, grundsätzlicher zu denken ...

John Mueller verwies in diesem Zusammenhang auf einen Blogartikel bei Webmaster Central von 2011, der die Wichtigkeit betonte, auf einer Website „die bestmögliche Benutzererfahrung“ zu bieten, um in Google ein hohes Ranking zu erhalten – anstatt sich auf Vermutungen darüber zu fixieren, was der Algorithmus sehen will.

Der nützliche Zweck stellt den Nutzer in den Mittelpunkt, denn jede Seite mit nützlichem Zweck ist darauf ausgerichtet, dass ihre Besucher irgendwie von den bereitgestellten Inhalten profitieren (ohne dabei Schaden anzurichten – siehe unten).

YMYL: Your Money or Your Life („Dein Geld oder dein Leben“)

Inhalte der Sorte Your Money or Your Life (YMYL) umfassen Informationen, die sich erheblich auf die „Gesundheit, finanzielle Stabilität oder Sicherheit von Menschen oder das Wohl der Gesellschaft“ auswirken könnten und deshalb ein hohes Schadenspotenzial haben.

Deshalb gelten für diese Art von Content gelten höhere Anforderungen. Ein „nützlicher Zweck“ allein bringt nicht viel, wenn du mit schlechten Gesundheits- oder Finanztipps das Leben oder den Lebensunterhalt von Menschen gefährdest.

Google nimmt Inhalte mit solchem Schadenspotenzial sehr ernst. YMYL-Inhalte müssen von Experten mit einschlägigem Fachwissen geschrieben werden. Und hier kommt E-A-T ins Spiel.

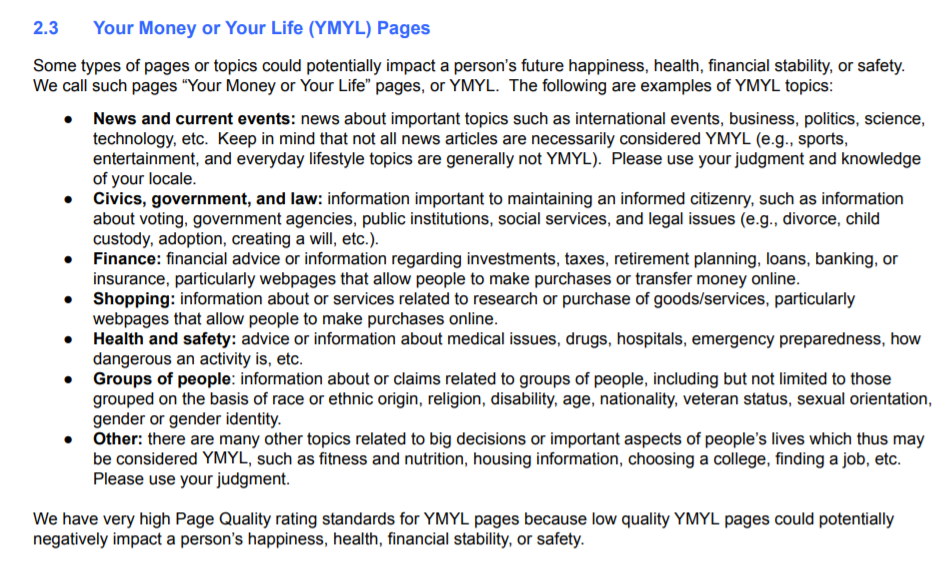

Aber zuerst: Was genau zeichnet YMYL-Inhalte aus? Bis zum Update 2022 enthielten die Richtlinien eine Aufzählung von Website-Kategorien, die Google zu YMYL zählte:

- Nachrichten und aktuelle Ereignisse

- Zivilgesellschaft, Regierung und Recht

- Finanzen

- Shopping

- Gesundheit und Sicherheit

- Personen-/Bevölkerungsgruppen

- Sonstiges

Genaueres dazu zeigt der Screenshot:

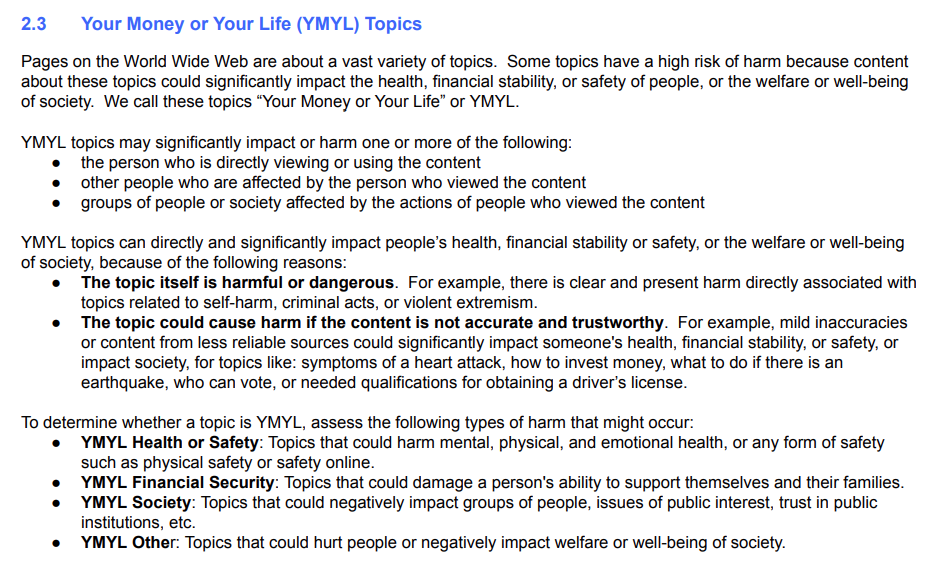

Mit dem Update vom 28. Juli 2022 wurden diese Kategorien entfernt. Stattdessen konzentriert sich die YMYL-Definition nun auf das Schadenspotenzial von Seiten und die Arten von Schäden, die YMYL-Content auslösen kann:

Der erste Abschnitt stellt klar, dass es sich um YMYL handelt, wenn der Content entweder den Besucher der Seite selbst oder durch ihn andere Menschen, Gruppen oder die Gesellschaft schädigen kann.

Der zweite umreißt, auf welche Fälle das am ehesten zutrifft: Seiten mit Anstiftungen oder Anleitungen zu schädigendem Verhalten oder solche mit Falschinformationen, die auch dann schädlich sein können, wenn sie gut gemeint sind.

Der dritte hält die wesentlichen Arten von Schaden fest, nach denen die Qualitätsbewerter Ausschau halten sollen:

- Schäden für Gesundheit und Sicherheit

- Finanzielle Schäden

- Schäden für gesellschaftliche Gruppen oder Institutionen

- Schäden für die Gesellschaft als Ganze

Wer über heikle YMYL-Themen schreibt, braucht aufgrund dieses Schadenspotenzials entsprechende Expertise, Autorität und Vertrauenswürdigkeit, damit sein Content ein gutes Qualitätsrating erhält.

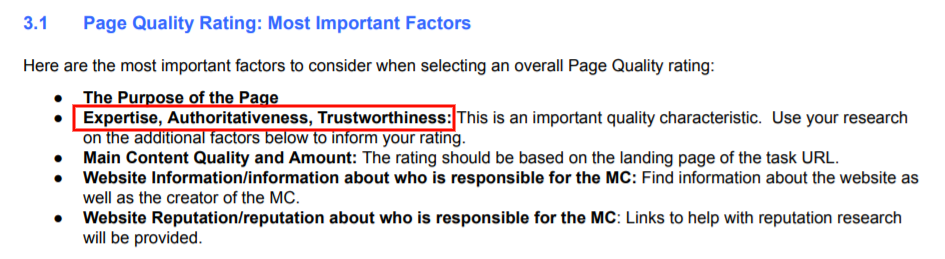

E-A-T: Expertise, Authoritativeness, Trustworthiness („Expertise, Autorität und Vertrauenswürdigkeit“)

Wenn du SEO-Blogs liest, ist dir die Abkürzung E-A-T vielleicht schon mal begegnet. Sie steht für Expertise, Autorität und Vertrauenswürdigkeit. Dies ist ein wichtiger Qualitätsfaktor für Webseiten und insbesondere für YMYL-Seiten. Trust/Relevanz sind auch Bestandteile von Google Core (nicht mit Google Core Web Vitals verwechseln).

Sobald ein Bewerter festgestellt hat, dass eine Seite einen nützlichen Zweck hat, muss er sich ihr E-A-T-Niveau ansehen. Dies ist vor allem bei YMYL-Seiten unverzichtbar. Google weist darauf hin, dass nicht alle Seiten gleichermaßen E-A-T benötigen. Ein Blogger beispielsweise, der nur über sein Leben schreibt und unterhalten will, muss dazu keine besondere Expertise haben.

Die Bestandteile im Einzelnen:

1. Expertise: Dies bezieht sich auf den Autor des Hauptinhalts (im Dokument „MC“ für „main content“) der Seite. Ist er ein Experte für das Thema? Verfügt er über die Referenzen oder Abschlüsse, um dies zu belegen, und sind diese Informationen auf der Website verfügbar?

- Google macht hier eine Ausnahme für „Alltagsexpertise“. Personen mit einschlägiger Lebenserfahrung in bestimmten Themen können unter Umständen als Experten betrachtet werden – es ist keine formelle Ausbildung oder Ausbildung erforderlich.

- In 4.5 heißt es: „Der Maßstab für Expertise hängt vom Thema der Seite ab.“ Eine Person, die beispielsweise ausführliche und hilfreiche Restaurantbewertungen schreibt, verfügt über Alltagserfahrung, wenn sie häufig in Restaurants geht und Essen liebt.

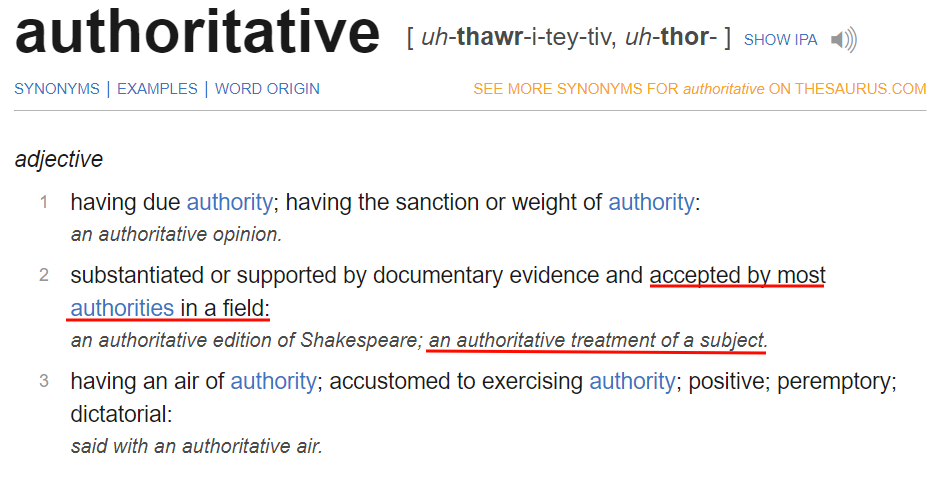

2. Autorität: Dies bezieht sich auf den Autor, den Content selbst und die Website, auf der er erscheint. Die Definition von „authoritativeness“ gibt uns einen nützlichen Hinweis, was dies für Google-Suchergebnisse und Websites bedeutet:

„Authoritativeness“ bedeutet, über allgemein anerkannte Autorität zu verfügen. Man kennt dich, weiß über deinen Hintergrund Bescheid und betrachtet dich als führend in deiner Branche. Du bist als gute Informationsquelle akzeptiert.

3. Vertrauenswürdigkeit: Der E-A-T-Bestandteil „Trustworthiness“ bezieht sich ebenfalls zugleich auf den Urheber des Contents, den Content selbst und die Website.

Wenn du ein vertrauenswürdiger Experte und eine vertrauenswürdige Quelle bist, können Nutzer darauf vertrauen, dass du wahrheitsgemäße und korrekte Informationen lieferst.

Seiten, die E-A-T erfordern: Beispiele

Die Richtlinien nennen beispielhaft einige Themen, die ein hohes Niveau an E-A-T erfordern. Insbesondere müssen sich Seiten mit den folgenden Inhalten auf spezielles Fachwissen und Know-how stützen (Seite 23):

- Gesundheitsratgeber / Medizin

- Nachrichten und journalistische Inhalte

- Informative Seiten über wissenschaftliche Themen

- Finanz-, Rechts- und Steuerberatung

- Ratgeber zu Themen mit hohen Risiken (z. B. Umbauarbeiten, Kindererziehung)

- Seiten über Hobbies, die Expertise erfordern, z. B. Fotografie, Gitarrespiel

Bis auf den letzten Punkt sind alle eindeutig als YMYL-Inhalte einzustufen.

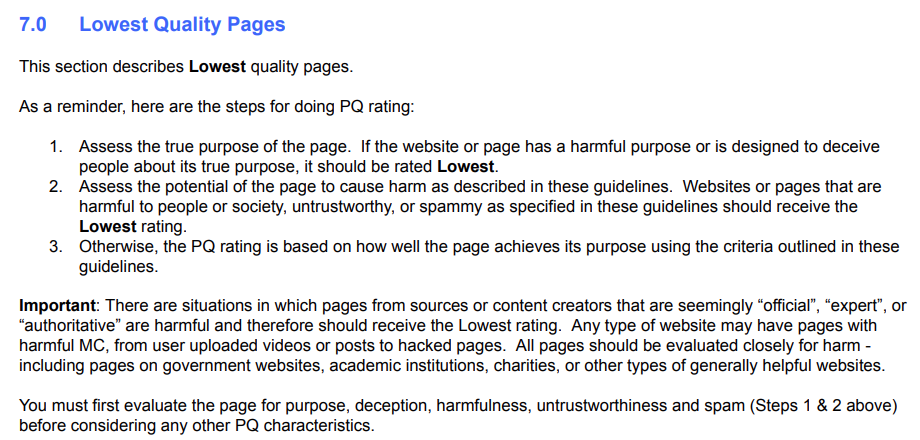

Im Update 2022 wurde den Richtlinien ein neuer Abschnitt 7 hinzugefügt. Dieser beschreibt genau anhand von Beispielen, welche Seiten in die niedrigste Qualitätskategorie gehören. Wer ein seriöses Geschäft betreibt, braucht kaum zu befürchten, hier eingestuft zu werden. Trotzdem hilft der Abschnitt, zu verstehen, was Google auf keinen Fall auf einer Website sehen will.

Die Erläuterung stellt klar, dass auch als seriös eingestufte Quellen und Inhalte von formal qualifizierten Autoren nicht automatisch davor sicher sind, als minderwertig eingestuft zu werden. Auch eine Universitätswebsite zum Beispiel kann eine Unterseite mit minderwertigem Content enthalten. Die Bewerter prüfen trotz Expertise den Inhalt und können ihn als schlecht einstufen, wenn sie ihn für irreführend oder potenziell schädlich halten.

Hochwertiger Content ist fachkundig und benutzerorientiert

Um qualitativ hochwertige Inhalte zu erstellen, die bei Google ein hohes Ranking erhalten, musst du die drei Faktoren beachten, die in den Search Quality Evaluator Guidelines zu finden sind: Nützlicher Zweck, E-A-T und YMYL.

- Jede Seite muss einen nützlichen Zweck für den Nutzer haben und diesen Zweck gut erfüllen. Mache den Zweck deiner Seiten leicht erkennbar und tue dein Bestes, um ihn zu erfüllen. Webseiten dürfen die Nutzer nicht über ihren Zweck täuschen.

- Hinter jeder Seite muss die nötige Expertise stehen. Manche Seiten erfordern aufgrund ihres Themas mehr E-A-T als andere. Manchmal findet sich der Beweis für die nötigen Kenntnisse im Inhalt selbst, vor allem bei Themen, für die eigene Lebenserfahrung als Qualifikation genügt. Dies trifft auf YMYL-Seiten eher nicht zu.

- YMYL-Seiten müssen am meisten E-A-T mitbringen. Diese Seiten können sich direkt auf das Wohl des Lesers, anderer Personen und Gruppen oder der gesamten Gesellschaft auswirken. Achte bei solchen Themen also darauf, dass die nötige Expertise in deine Texte einfließt und dies auch erkennbar ist.

Denke zu guter Letzt daran, dass sich die Standards von Google ständig ändern. Die Erwartungen der Nutzer an die Suche entwickeln sich weiter und Google muss mithalten, um relevant zu bleiben.

Genau wie du.