Was ist Crawl Budget?

Das Crawl-Budget ist die Zeit und die Ressourcen, die Suchmaschinen-Bots für das Crawlen deiner Website und die Indexierung ihrer Seiten aufwenden.

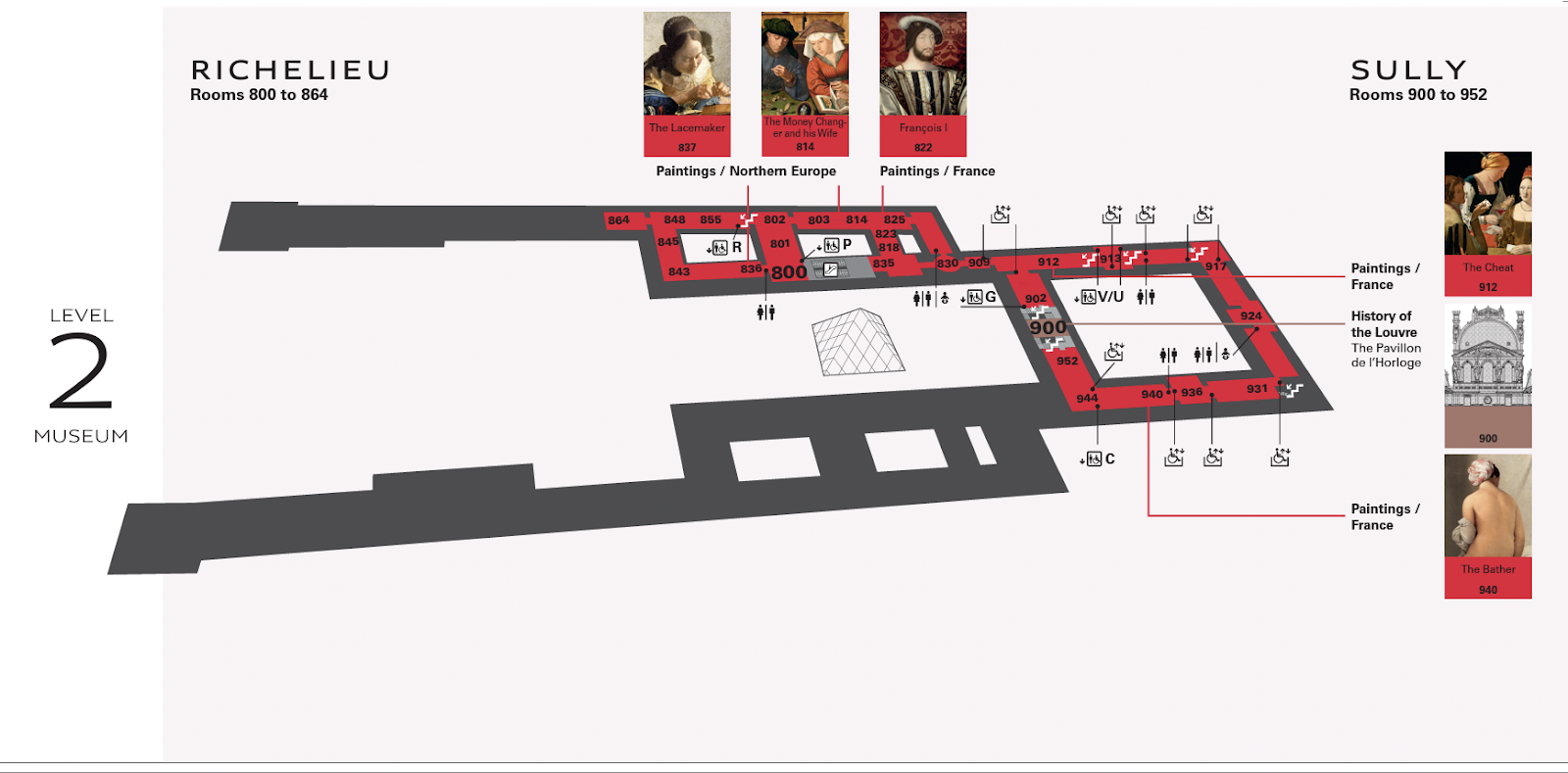

Stell dir das so vor: Du besuchst den Louvre, der Hunderte von Ausstellungsstücken auf mehreren Etagen hat.

Ohne eine Karte könntest du die Kunst verpassen, die du wirklich sehen wolltest.

Um die Karte, die du in den Händen hältst, zu erstellen, müsste jemand durch jeden Raum gehen und markieren, welche Gemälde dort zu finden sind.

In dieser Metapher ist der Louvre Mapmaker wie ein Googlebot, der eine Website crawlt.

Ein Team von Kartenmachern, das ständig im Louvre herumläuft, würde das Erlebnis für die Zuschauer verlangsamen.

Ähnlich wie Bots, die deine Website ständig crawlen, würde sie dadurch langsamer werden.

Die Kartenersteller brauchen also eine bestimmte Zeit, um die Karte zu aktualisieren, genauso wie der Googlebot wissen muss, wie oft er deine Website crawlen soll.

Wirken sich Crawl-Budgets auf SEO aus?

Das Crawl-Budget ist kein Ranking-Faktor für technisches SEO.

Wenn der Googlebot jedoch Crawl-Fehler hat, die ihn daran hindern, deine Inhalte zu lesen und zu indizieren, sind die Chancen, dass deine Seiten auf den Suchmaschinenergebnisseiten(SERPs) auftauchen, gering.

Du willst auch nicht, dass die Googlebots deine Seite ständig crawlen.

Das Überschreiten des zugewiesenen Budgets für das Crawling einer Website kann zu Verlangsamungen oder Fehlern im System führen.

Das kann dazu führen, dass Seiten zu spät oder gar nicht indexiert werden, was zu schlechteren Suchergebnissen führt.

Google verwendet Hunderte von Signalen, um zu entscheiden, wo es deine Seite platzieren soll. Das Crawling bestimmt, ob deine Seite auftaucht - nicht wo - und hat nichts mit der Qualität des Inhalts zu tun.

Wie legt Google das Crawl-Budget fest?

Jede Website hat ein eigenes Crawl-Budget, das durch zwei Hauptelemente gesteuert wird: Crawl-Bedarf und Crawl-Limit.

Es ist wichtig zu verstehen, wie sie funktionieren und was hinter den Kulissen vor sich geht.

Crawl-Nachfrage

Der Crawl-Bedarf gibt an, wie viel Lust Google hat, deine Website zu crawlen.

Zwei Faktoren beeinflussen diese Nachfrage - Beliebtheit und Abgestandenheit.

Beliebtheit

Google bevorzugt Seiten mit mehr Backlinks oder solche, die mehr Besucher anziehen. Wenn also Menschen deine Website besuchen oder auf sie verlinken, erhält der Google-Algorithmus Signale, dass deine Website es wert ist, häufiger gecrawlt zu werden.

Backlinks helfen Google vor allem dabei, herauszufinden, welche Seiten es wert sind, gecrawlt zu werden. Wenn Google merkt, dass über deine Website geredet wird, will es sie genauer durchforsten, um zu sehen, was es mit dem Hype auf sich hat.

Beachte, dass die Anzahl der Backlinks allein nicht ausschlaggebend ist - die Backlinks sollten relevant sein und von maßgeblichen Quellen stammen.

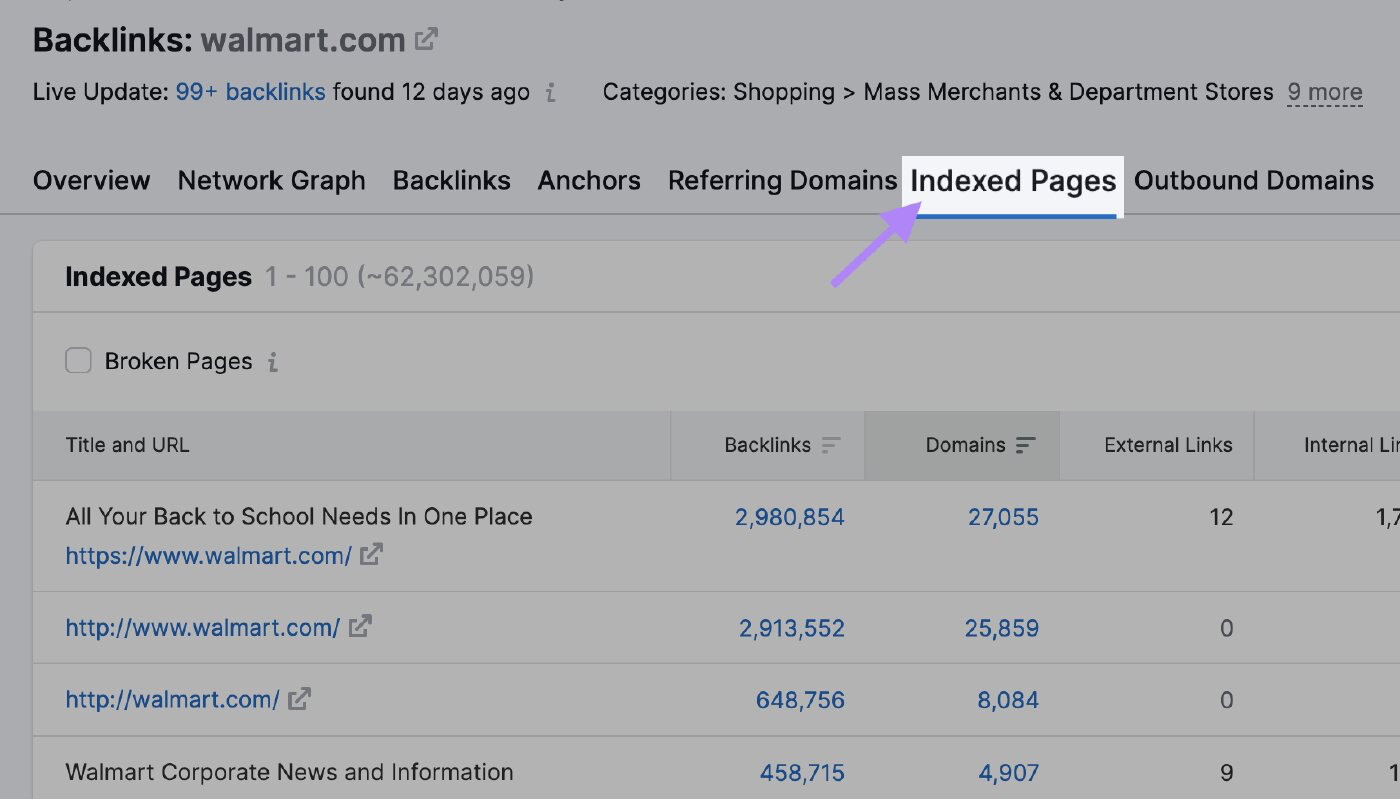

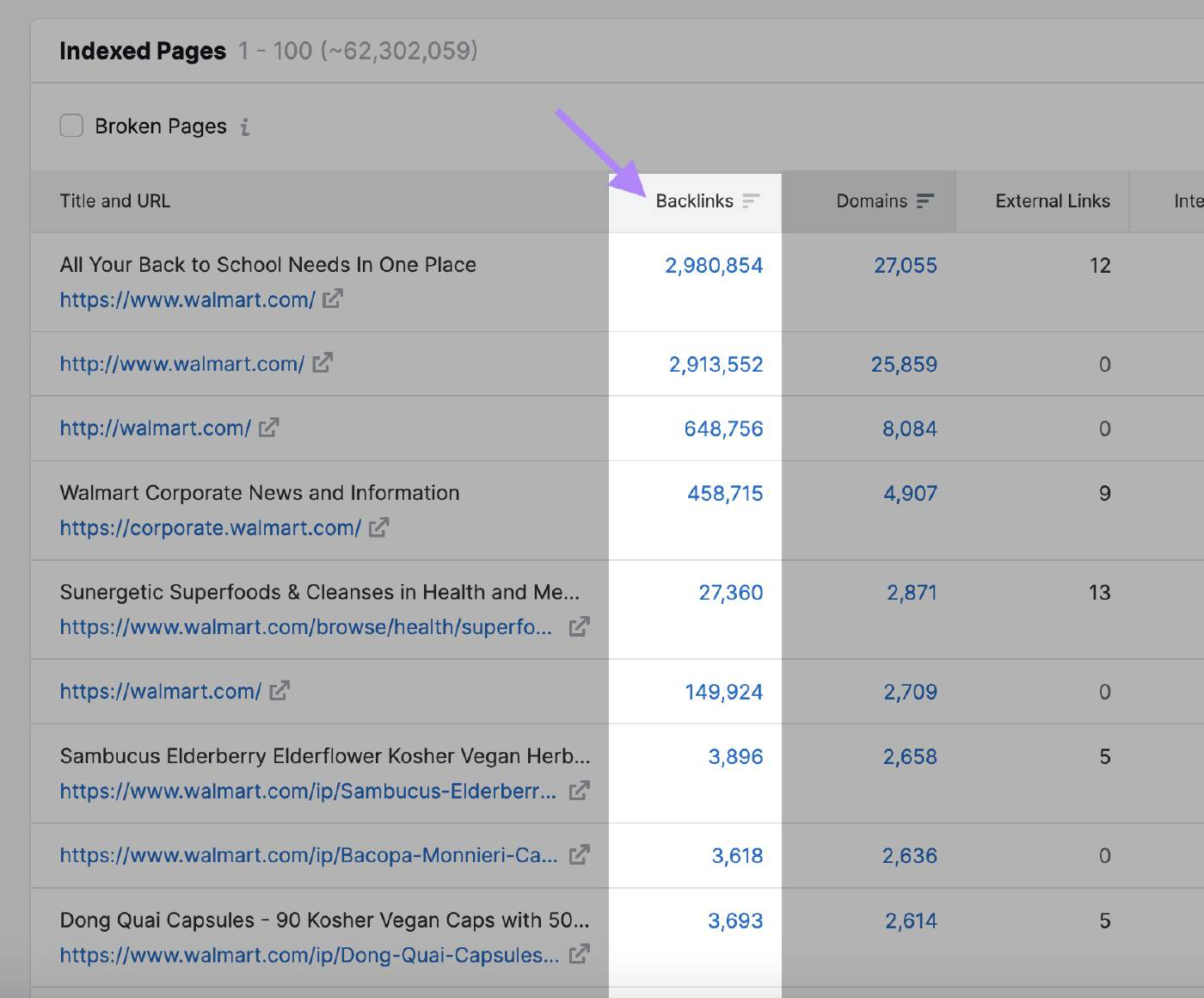

Mit dem Backlink-Analyse-Tool von Semrush kannst du sehen, welche Seiten die meisten Backlinks erhalten und die Aufmerksamkeit von Google auf sich ziehen könnten. Gib die Domain ein und klicke auf den Reiter "Indizierte Seiten".

Hier kannst du die Seiten mit den meisten Backlinks sehen:

Trägheit

Googlebot wird eine Seite nicht crawlen, die seit einiger Zeit nicht mehr aktualisiert wurde.

Google hat nicht verraten, wie oft die Suchmaschine die Website erneut crawlen wird. Wenn der Algorithmus jedoch eine allgemeine Aktualisierung der Website bemerkt, erhöhen die Bots vorübergehend das Crawl-Budget.

Zum Beispiel crawlt der Googlebot Nachrichten-Websites häufig, weil sie mehrmals am Tag neue Inhalte veröffentlichen.

In diesem Fall hat die Website einen hohen Crawl-Bedarf.

Vergleiche dies mit einer Website über die Geschichte berühmter Kunstwerke, die nicht so häufig aktualisiert wird.

Andere Aktionen, die Google signalisieren können, dass es Änderungen gibt, die gecrawlt werden müssen, sind z. B:

- Änderung des Domainnamens: Wenn du den Domainnamen deiner Website änderst, muss der Algorithmus von Google seinen Index aktualisieren, um die neue URL zu berücksichtigen. Es wird die Website crawlen, um die Änderung zu verstehen und die Rankingsignale an die neue Domain weiterzuleiten.

- Änderung der URL-Struktur: Wenn du die URL-Struktur deiner Website änderst, indem du die Verzeichnishierarchie änderst oder Subdomains entfernst oder hinzufügst, müssen die Bots von Google die Seiten neu crawlen, um die neuen URLs korrekt zu indizieren

- Inhaltliche Aktualisierungen: Bedeutende Aktualisierungen des Inhalts deiner Website, wie z. B. das Umschreiben eines großen Teils deiner Seiten, das Hinzufügen neuer Seiten oder das Entfernen veralteter Inhalte, können die Aufmerksamkeit des Algorithmus erregen und ihn dazu veranlassen, deine Website erneut zu crawlen.

- XML-Sitemap einreichen: Wenn du deine XML-Sitemap aktualisierst und sie erneut an die Google Search Console übermittelst, kann Google erfahren, dass es Änderungen gibt, die gecrawlt werden müssen. Das ist besonders nützlich, wenn du sicherstellen willst, dass Google neue oder aktualisierte Seiten zeitnah indexiert.

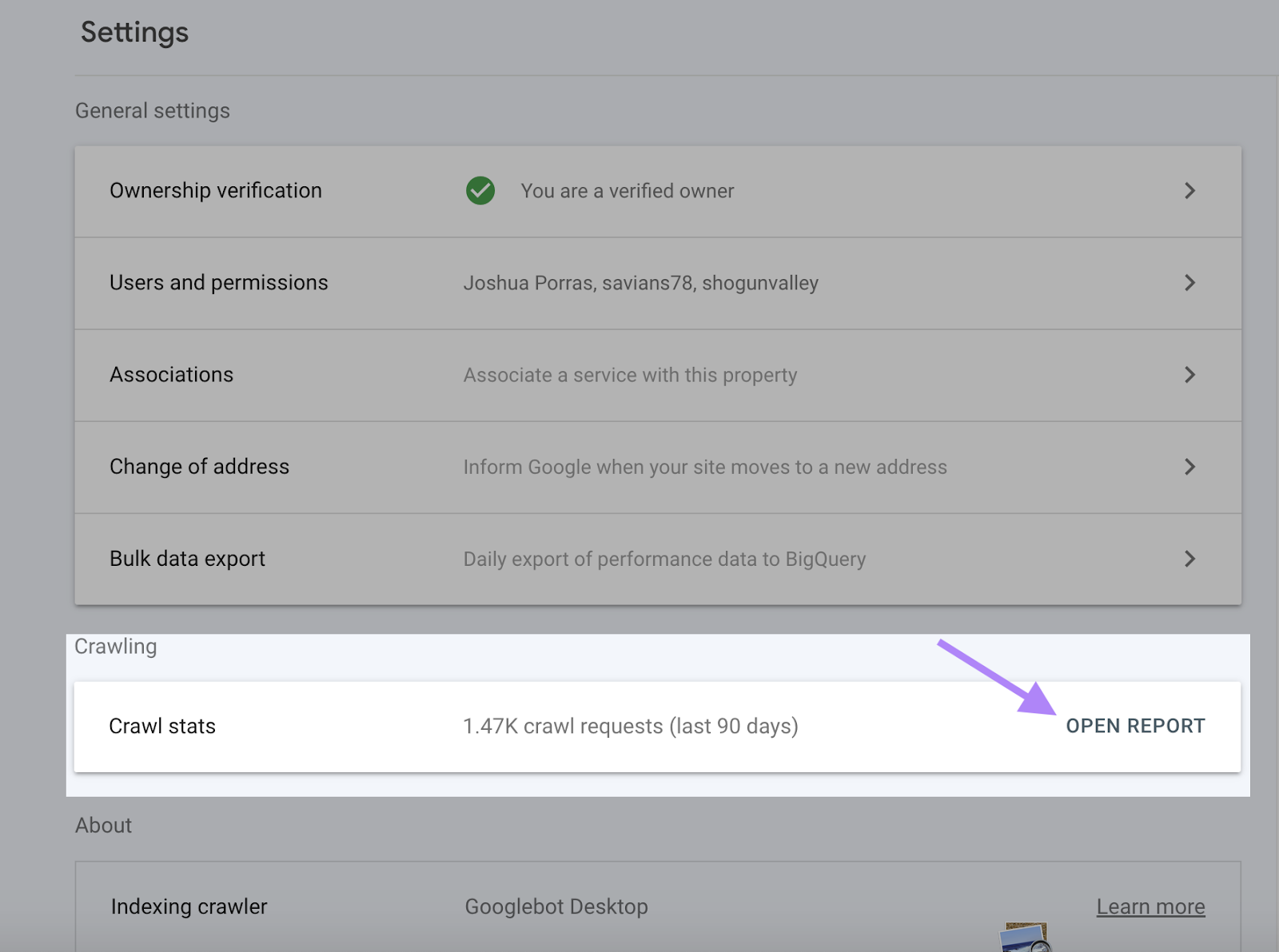

Crawl Rate Limit

Das Crawl-Raten-Limit bestimmt, wie schnell der Bot auf deine Website zugreifen und sie herunterladen kann, um die Inhalte für die Anzeige in den Suchergebnissen vorzubereiten.

So stellt Google sicher, dass sein Crawling deine Server nicht überlastet.

Das Crawl-Limit verhindert, dass der Bot deine Website mit zu vielen Anfragen überlastet, was zu Leistungsproblemen führen kann.

Wenn deine Website schnell reagiert, bekommt Google grünes Licht für die Erhöhung des Limits und kann dann mehr Ressourcen für das Crawlen der Website verwenden.

Ähnlich verhält es sich, wenn Google auf Serverfehler stößt oder deine Website langsamer wird, sinkt das Limit und der Googlebot wird die Website weniger crawlen.

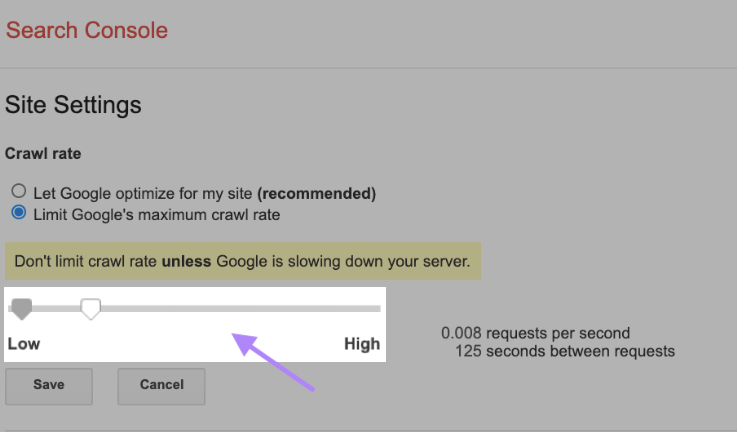

Du kannst das Crawl-Limit auch manuell ändern, aber das solltest du mit Bedacht tun. Google empfiehlt, die Crawl-Rate nicht zu begrenzen, es sei denn, dein Server wird langsamer.

Um deine Crawl-Rate zu ändern, gehe in der Search Console zu den Website-Einstellungen und passe den Balken an. In der Regel dauert es bis zu zwei Tage, bis die Anpassung erfolgt.

[BACKLINK ANALYTICS: [create-campaign destination_url=”https://www.semrush.com/analytics/backlinks/” show_input=”false”header=”Erhalte Einblicke zu Backlink-Profilen” text=”mit dem Backlink Analytics Tool” button_text=”Kostenlos testen”bg_images=”https://static.semrush.com/blog/uploads/media/96/fd/96fd495930d058321d5f78f5554aff88/trial-superbanner-1.png”bg_button=”-success"]

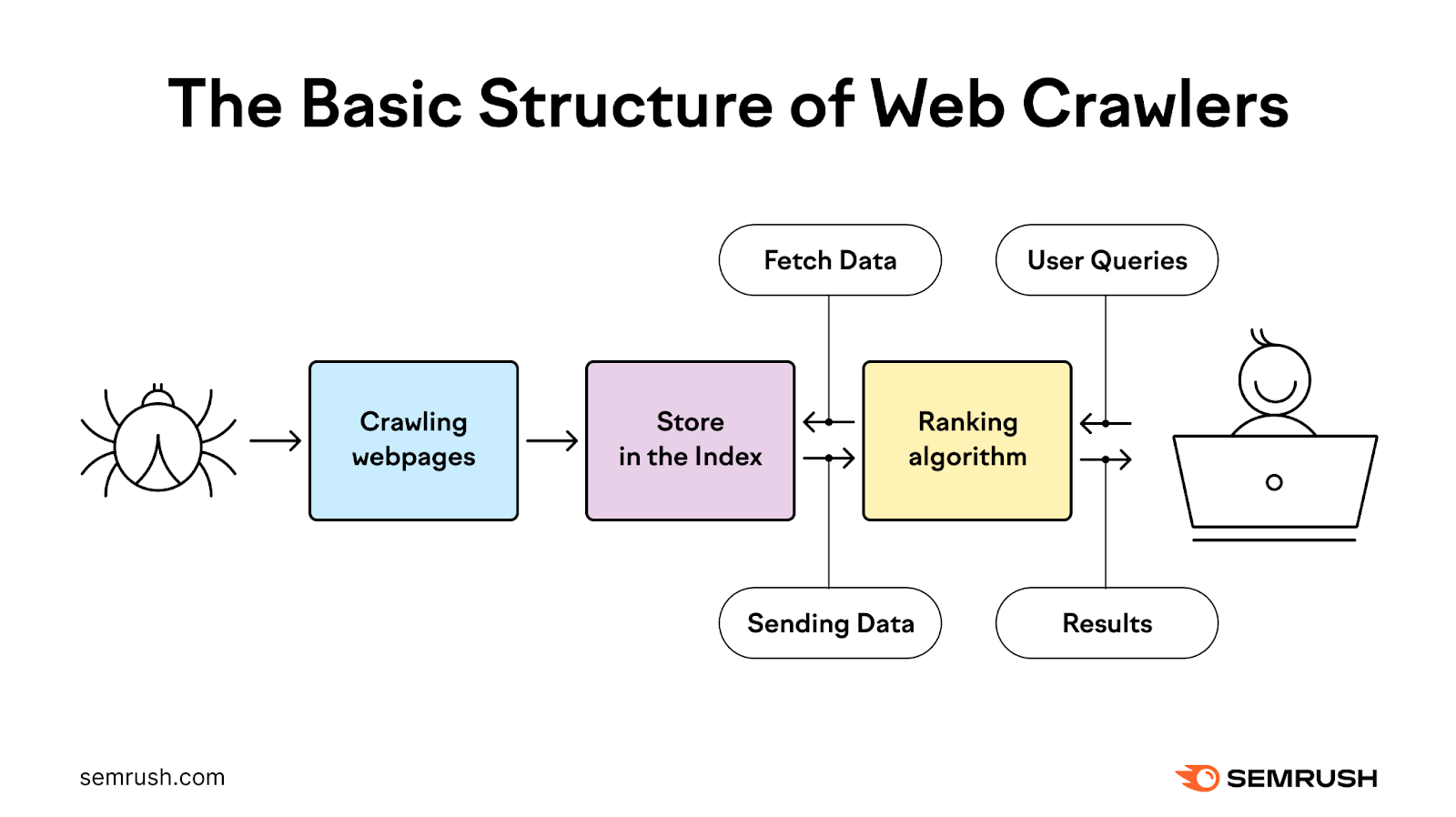

Wie funktioniert der Crawling-Prozess?

Beim Crawling-Prozess werden Bots eingesetzt, um Webseiten zu entdecken, zu crawlen, zu analysieren und zu indexieren, um den Nutzern die relevantesten und hochwertigsten Suchergebnisse zu liefern.

Es beginnt mit einer Liste von Webadressen aus früheren Crawls und XML-Sitemaps, die von Website-Besitzern zur Verfügung gestellt werden. Dann verwendet Google Webcrawler, um diese Adressen zu besuchen, die Informationen zu lesen und den Links auf diesen Seiten zu folgen.

Die Crawler besuchen die Seiten, die Google bereits in der Liste hat, um zu überprüfen, ob sie sich geändert haben, und crawlen auch neue Seiten.

Während dieses Prozesses setzt der Bot Prioritäten, wann und was er crawlen soll, basierend auf dem Crawl-Bedarf und stellt gleichzeitig sicher, dass die Website die Serveranfragen bewältigen kann, die er stellt.

Anschließend verarbeitet es die erfolgreich gecrawlten Seiten und leitet sie zur Indizierung in den Suchergebnissen an Google weiter.

Die meiste Zeit crawlt Google kleinere Websites effizient.

Wenn es um große Websites mit Millionen von URLs geht, muss Google Prioritäten setzen, wann und was gecrawlt werden soll und wie viele Ressourcen es dafür aufwenden soll.

So überprüfst du deine Crawl-Aktivität

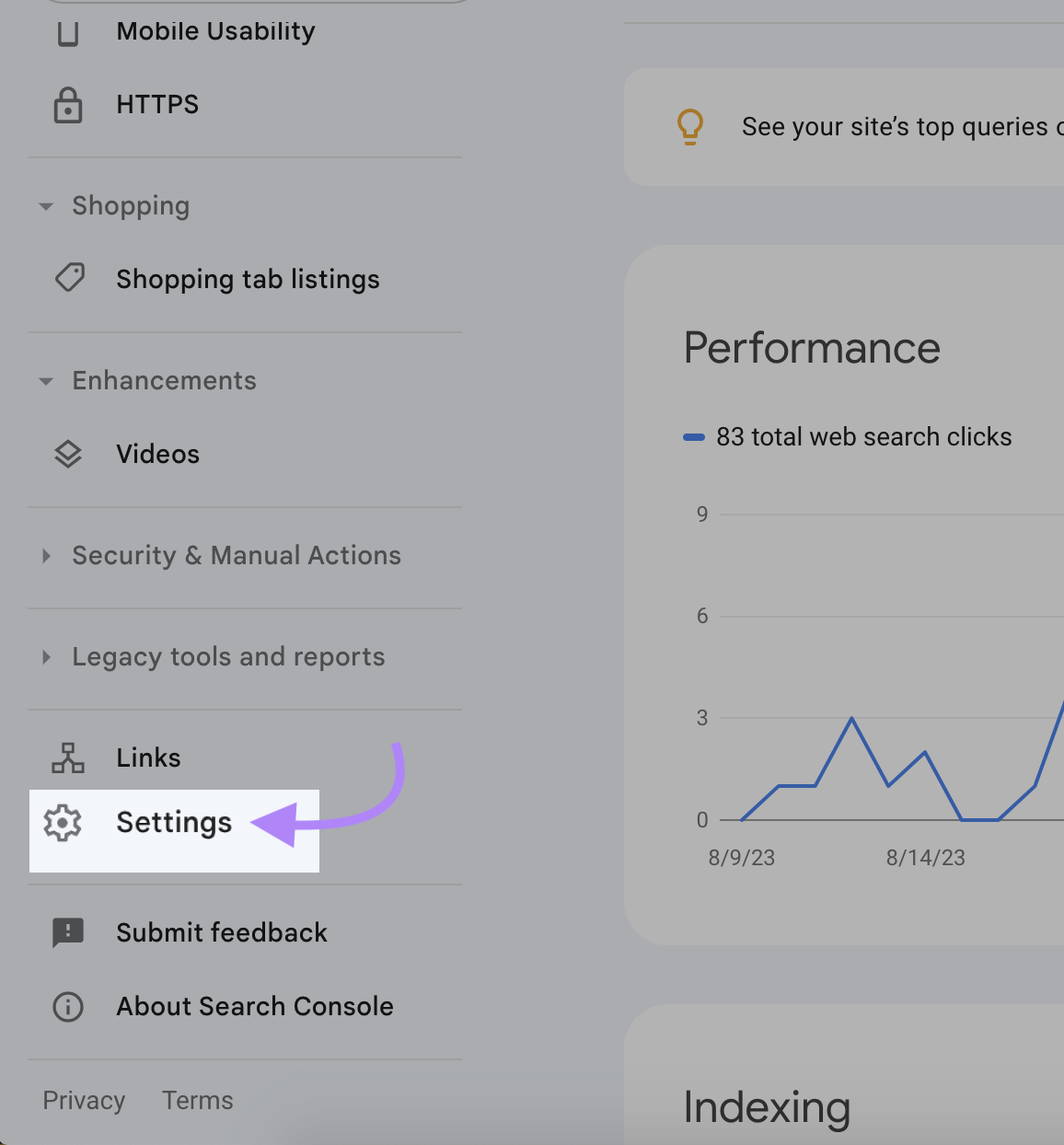

Die Google Search Console liefert im Crawl-Statistikbericht vollständige Informationen über deine Crawl-Aktivitäten, einschließlich Crawl-Fehler und Crawl-Rate.

Mit dem Crawl-Statistikbericht kannst du überprüfen, ob Google auf deine Inhalte zugreifen und sie indexieren kann. Es kann auch Probleme erkennen und beheben, bevor die Sichtbarkeit deiner Website sinkt.

Um auf deinen Crawl-Statistikbericht zuzugreifen, melde dich in der Search Console an und klicke auf "Einstellungen".

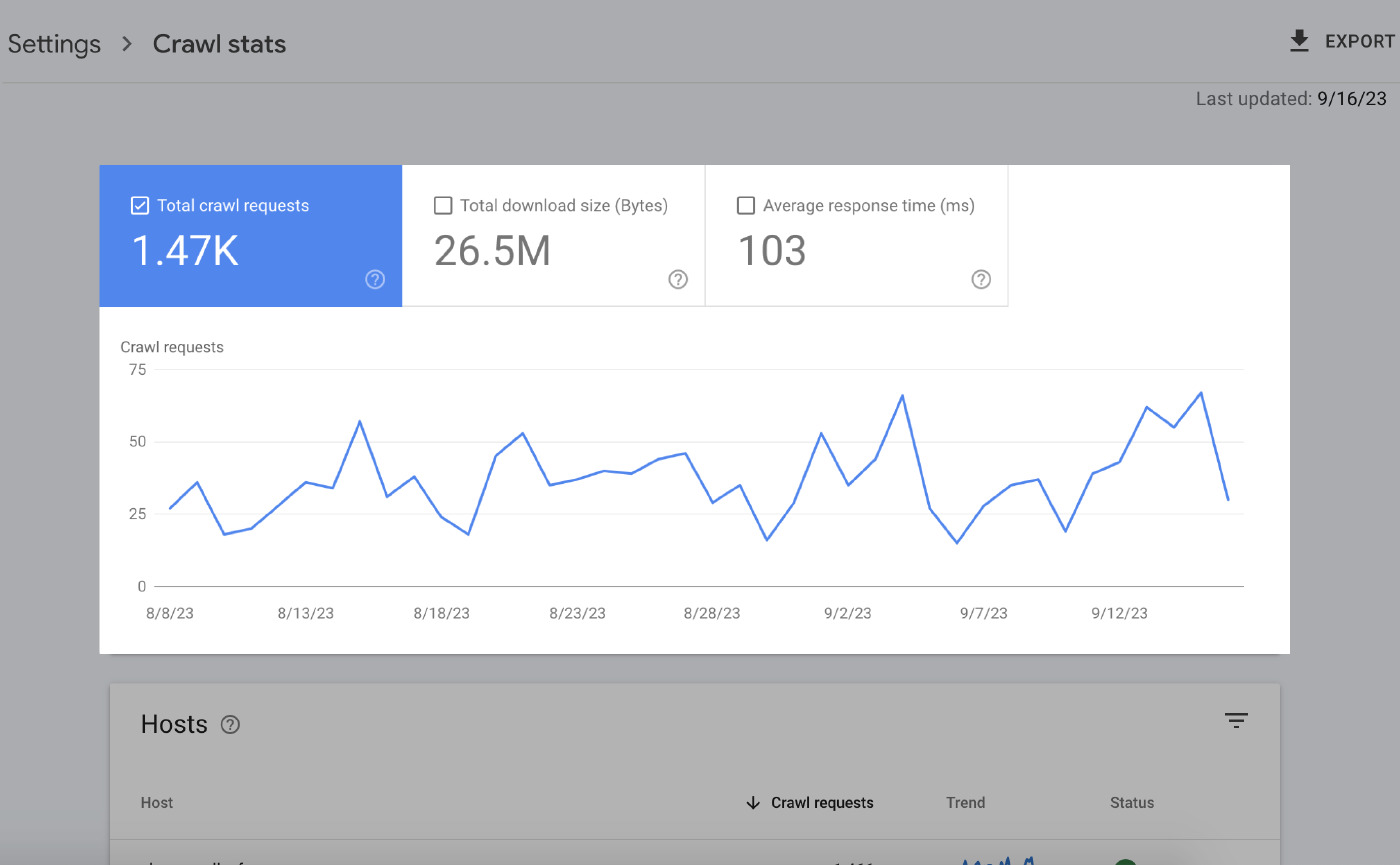

Auf der Seite Zusammenfassung findest du eine Menge Informationen. Die wichtigsten Elemente sind:

Over-Time Charts

Die Überzeitdiagramme zeigen deine Crawl-Daten der letzten 90 Tage.

Das bedeutet Folgendes:

- Crawl-Anfragen insgesamt: Die Anzahl der Crawl-Anfragen, die Google in den letzten 90 Tagen gestellt hat.

- Gesamt-Downloadgröße: Die Gesamtmenge an Daten, die die Crawler von Google beim Zugriff auf deine Website in einem bestimmten Zeitraum heruntergeladen haben.

- Durchschnittliche Antwortzeit: Die Zeit, die der Server deiner Website braucht, um auf eine Anfrage des Browsers eines Nutzers zu antworten.

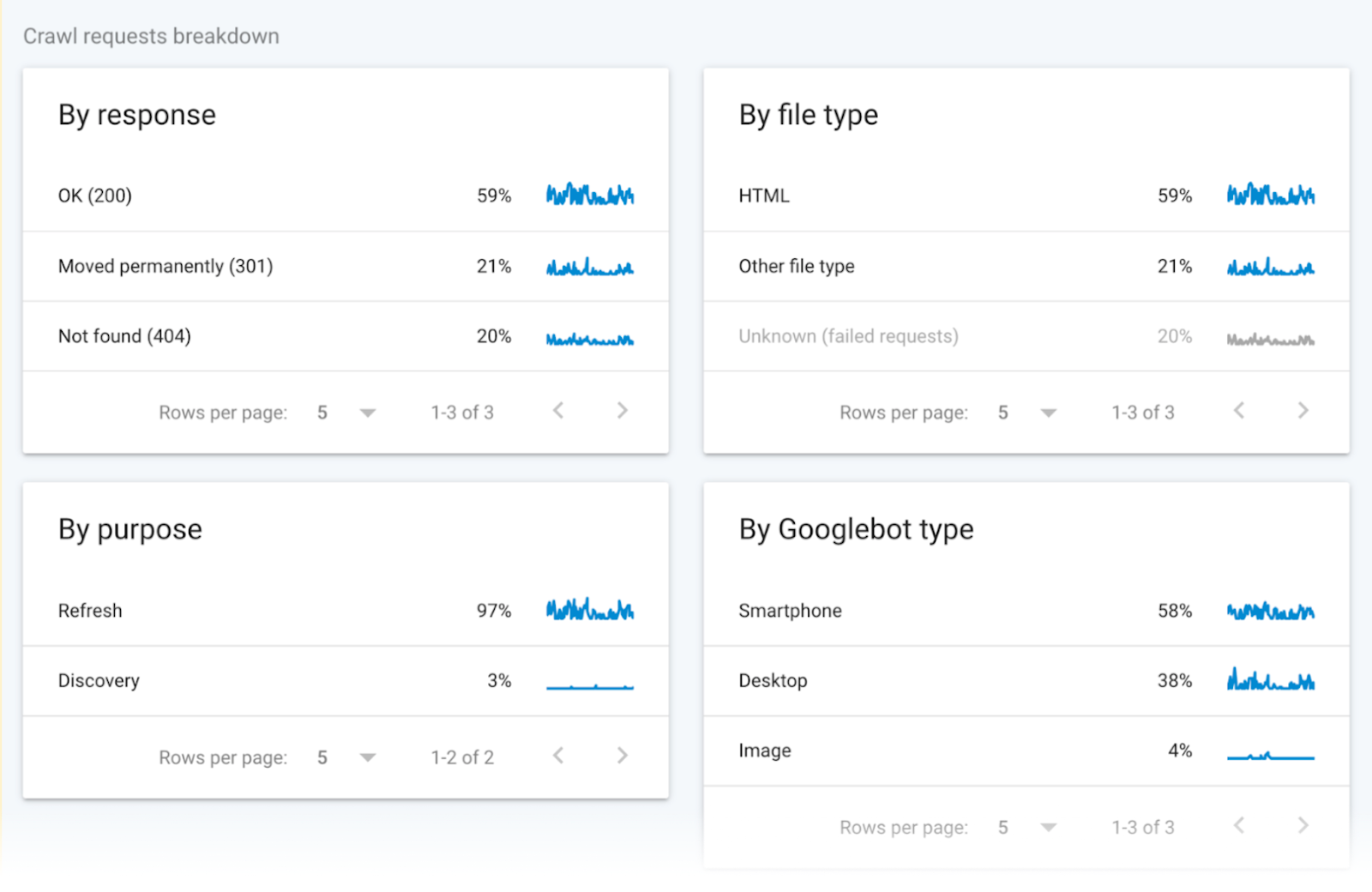

Gruppierte Crawl-Daten

Gruppierte Crawl-Daten liefern Informationen über Crawl-Anfragen.

Die Daten unterteilen diese Anfragen nach dem URL-Dateityp, der Antwort, dem Googlebot-Typ und dem Zweck der Anfrage (Entdeckung einer neuen Seite oder Aktualisierung einer bestehenden Seite).

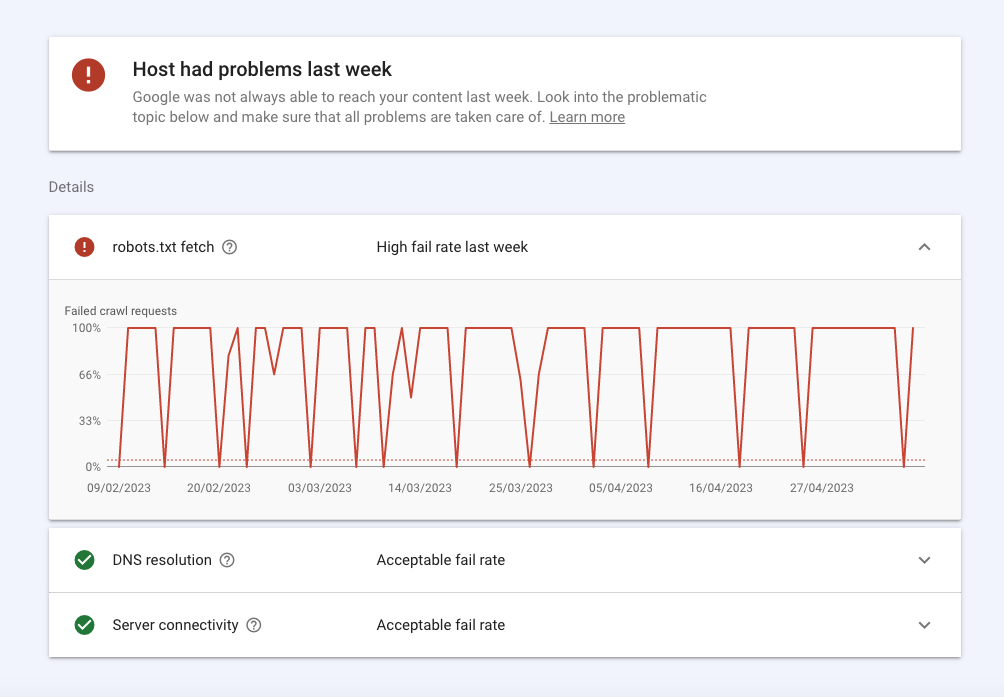

Host-Status

Der Host-Status zeigt die allgemeine Verfügbarkeit deiner Website und ob Google problemlos auf sie zugreifen kann.

Hier ein Überblick:

- Fehler im robots.txt-Abschnitt bedeuten, dass Google deine Website aus technischen Gründen nicht crawlen konnte. Robots.txt fetch zeigt dir die Fehlerquote, die die Bots beim Crawlen deiner robots.txt-Datei hatten. Deine Website braucht zwar keine robots.txt-Datei, aber sie muss die erfolgreiche Antwort 200 oder 404 zurückgeben, wenn sie danach gefragt wird. Wenn Googlebot ein Verbindungsproblem wie einen 503 HTTP-Status hat, hört er auf, deine Seite zu crawlen.

- Die DNS-Auflösung sagt dir, wenn dein DNS-Server deinen Hostnamen nicht erkannt hat oder während des Crawlings nicht geantwortet hat. Wenn hier ein Problem auftritt, wende dich an deinen Registrar, um zu überprüfen, ob deine Website richtig eingerichtet ist und dein Server eine aktive Internetverbindung hat.

- Die Serverkonnektivität sagt dir, wann dein Server nicht reagiert hat oder nicht die vollständige Antwort geliefert hat. Wenn du hier Spitzen oder ständige Verbindungsprobleme feststellst, solltest du mit deinem Anbieter über die Erhöhung der Kapazität oder die Behebung von Verfügbarkeitsproblemen sprechen.

Wie du die Crawlability deiner Website mit Site Audit überprüfst

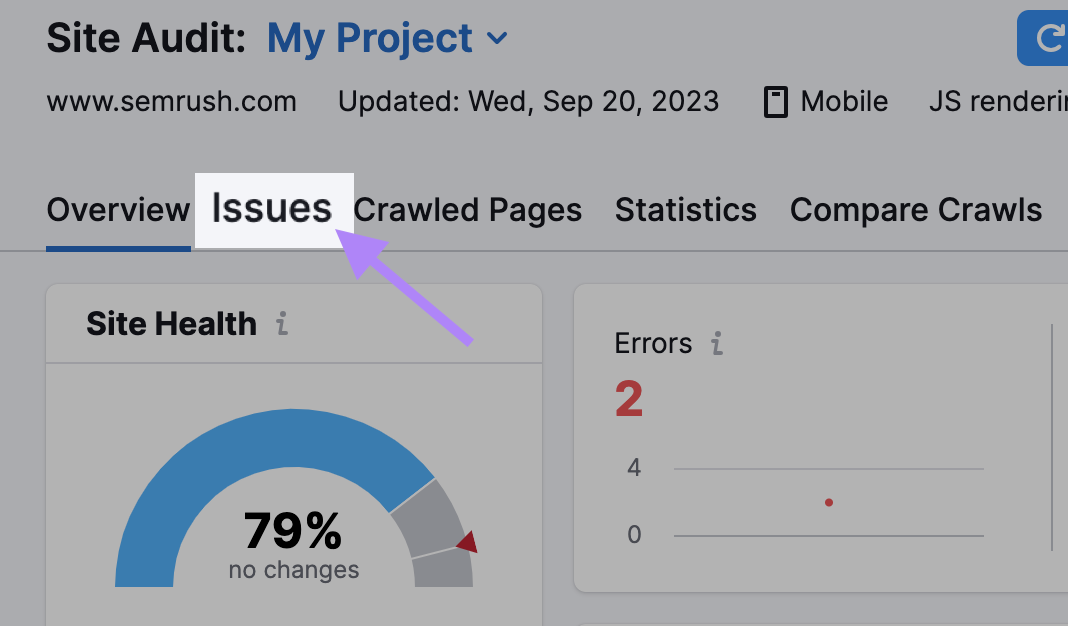

Verwende das Site Audit Tool, um SemrushBots dazu zu bringen, deine Website zu crawlen und ihren Zustand zu überprüfen.

Das Tool zeigt über 140 Problemean - darunter doppelte Inhalte und fehlerhafte Links-, die du erkennen und beheben kannst.

Hier ist, was du tun musst:

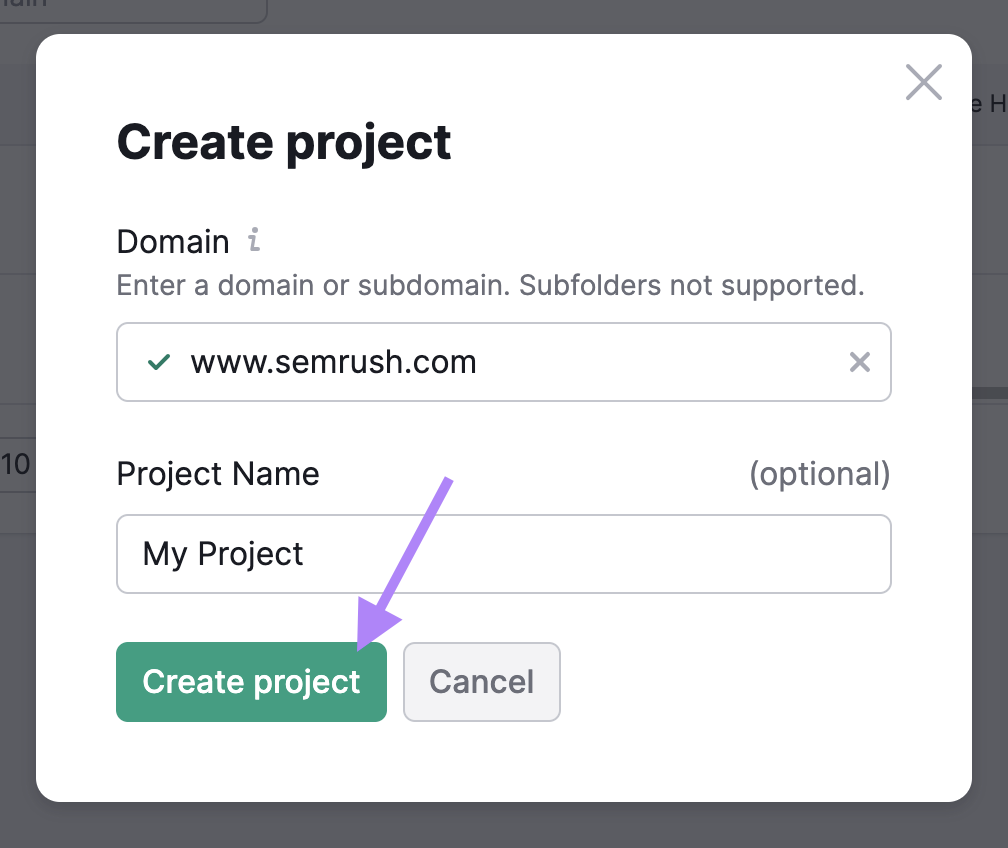

Grundeinstellungen abschließen

Gehe zum Tool Site Audit und erstelle ein neues Projekt, wenn dies dein erstes Audit ist.

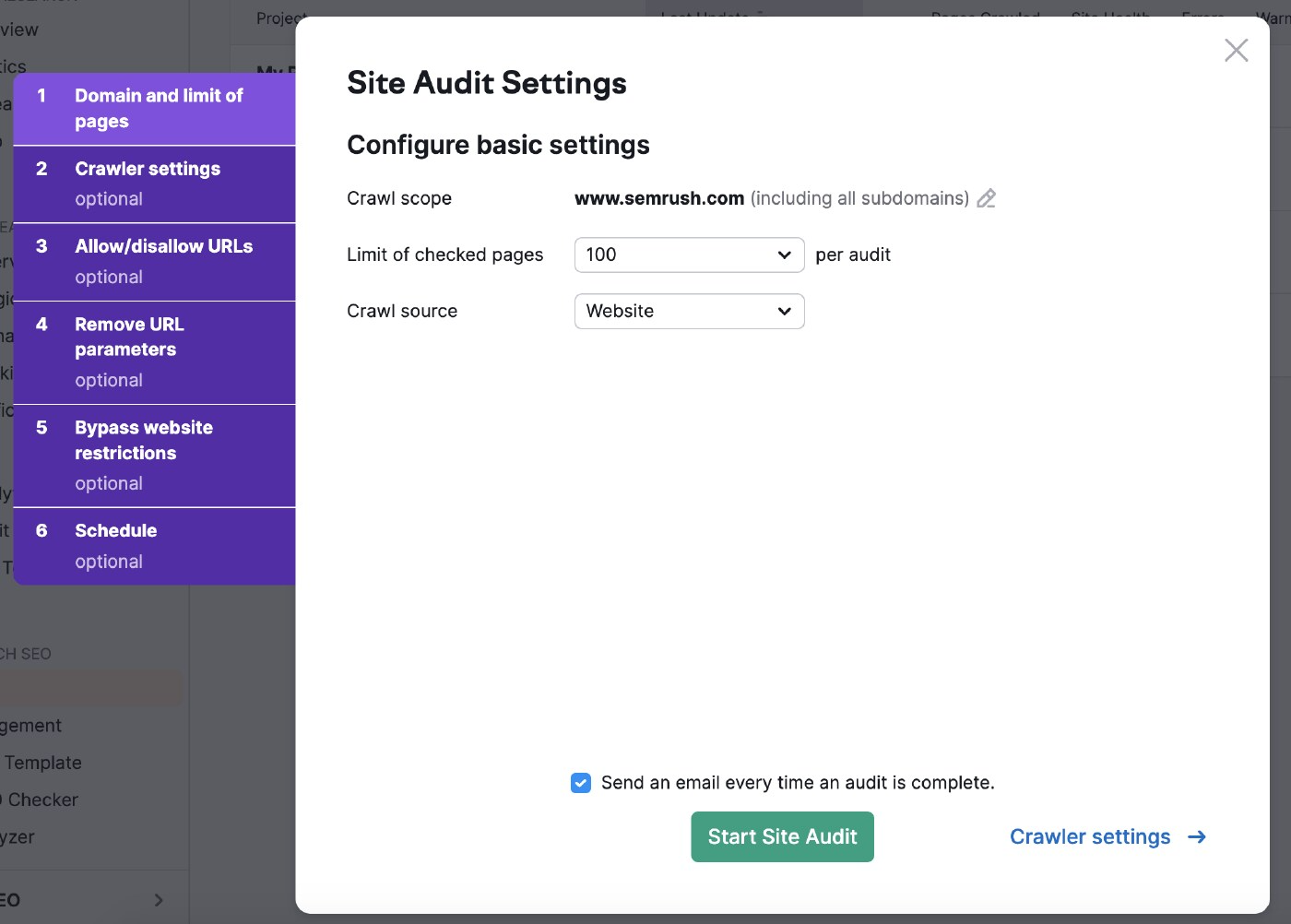

Als Nächstes wählst du die Einstellungen für dein Site Audit aus.

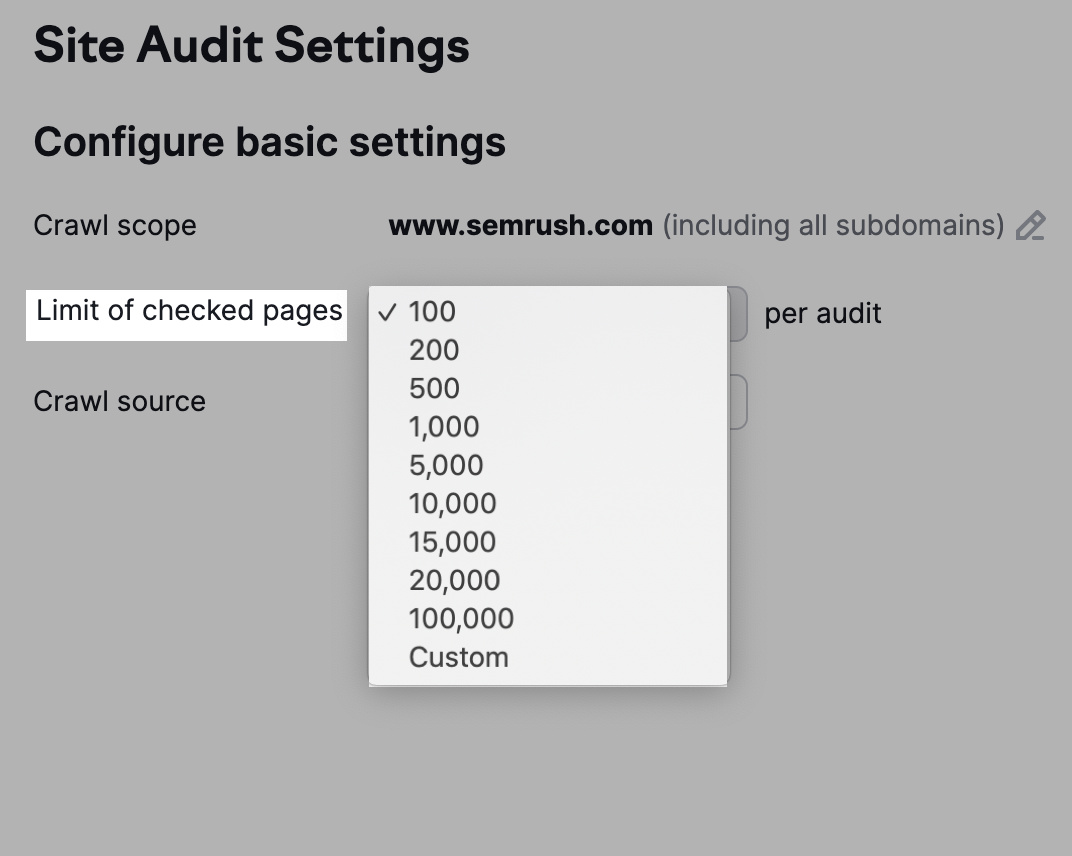

Mit dem Crawl-Bereich kannst du deine Suche eingrenzen.

Du kannst auch die Anzahl der zu prüfenden URLs pro Audit anpassen, je nachdem, wie hoch dein Abonnement ist und wie häufig du die Website überprüfst.

Je mehr Seiten du crawlst, desto mehr Sichtbarkeit bekommst du.

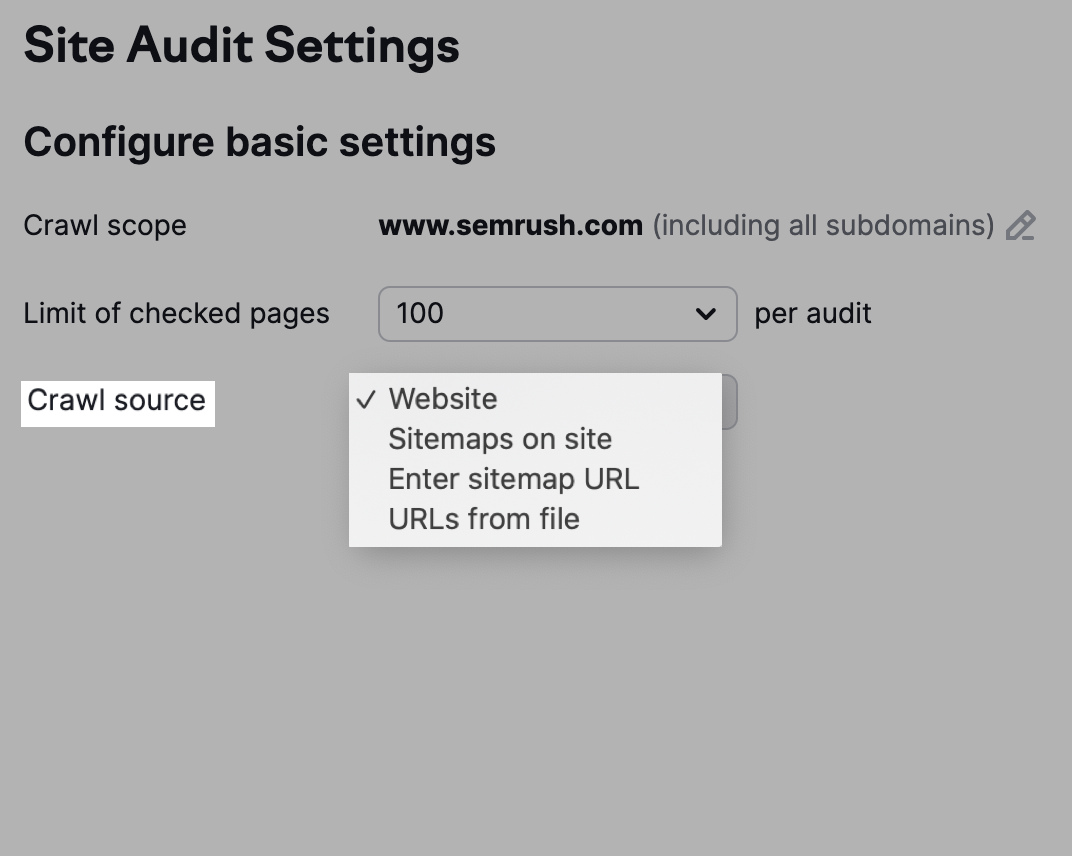

Du hast auch die Möglichkeit, deine Crawl-Quelle zu wählen.

Beachte, dass die Option "Website" die Bots dazu veranlasst, deine Website so zu crawlen, wie Google es tut, während ein Crawl mit der Option "Sitemaps auf der Website" die URLs in der Sitemap der robots.txt-Datei verwendet.

Alternativ kannst du auch auf "URLs aus Datei" klicken, um die Seiten auszuwählen, die die Bots crawlen sollen.

Crawler-Einstellungen anpassen

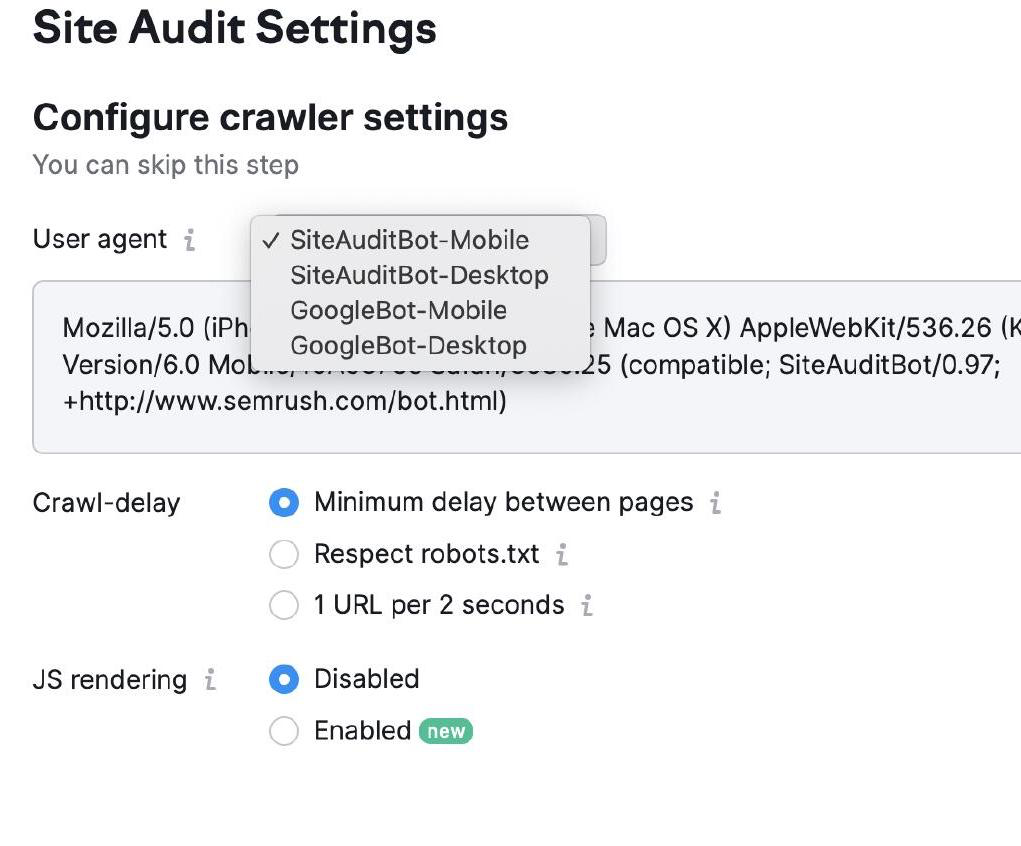

In den Crawler-Einstellungen kannst du die Art des Bots auswählen, der deine Website crawlen soll.

Du kannst zwischen Googlebot und SemrushBot sowie zwischen mobilen und Desktop-Versionen wählen.

Wähle dann deine Crawl-Delay-Einstellungen. Bots crawlen in normaler Geschwindigkeit mit "minimaler Verzögerung" und priorisieren das Nutzererlebnis in den Einstellungen "1 URL pro 2 Sekunden".

Schließlich wählst du "robots.txt respektieren", wenn du die entsprechende Datei hast und eine bestimmte Crawl-Verzögerung brauchst.

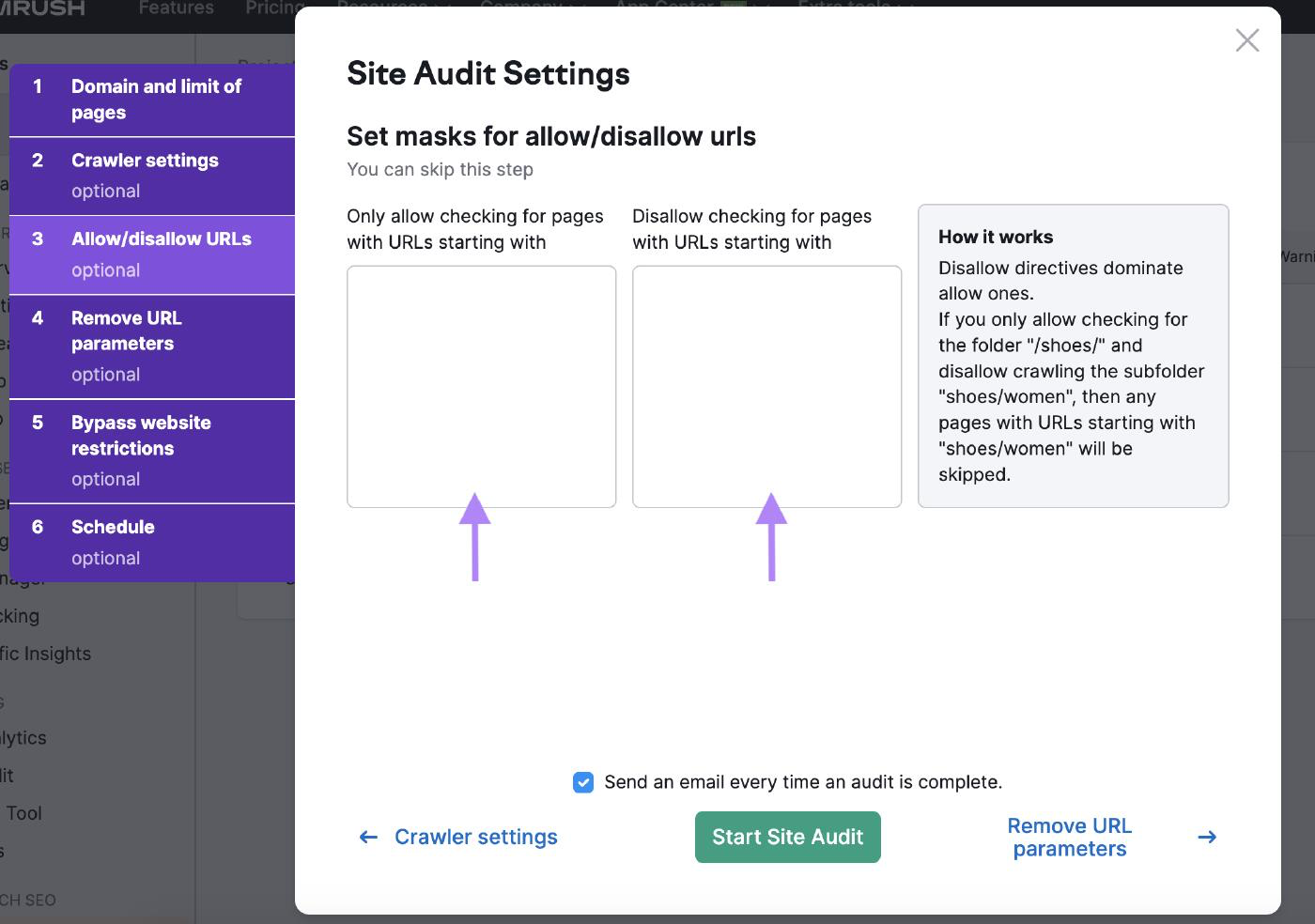

URLs zulassen/verweigern

Passe deine Website-Prüfung mit den Einstellungen für zulässige/unzulässige URLs an, indem du die URLs in die entsprechenden Felder eingibst.

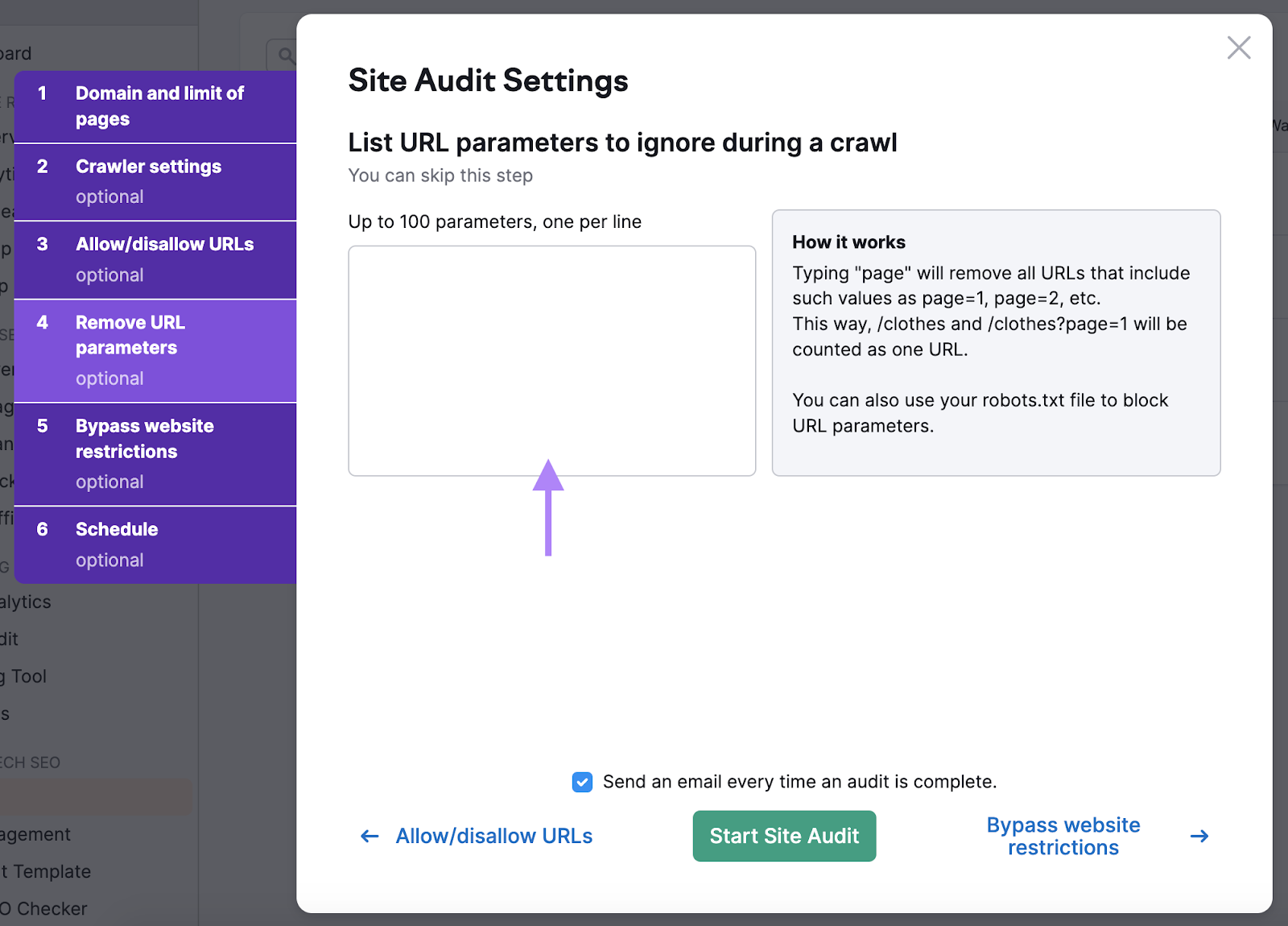

URL-Parameter entfernen

Entfernen von URL-Parameter sorgt dafür, dass die Bots das Crawl-Budget nicht verschwenden, indem sie dieselbe Seite zweimal crawlen.

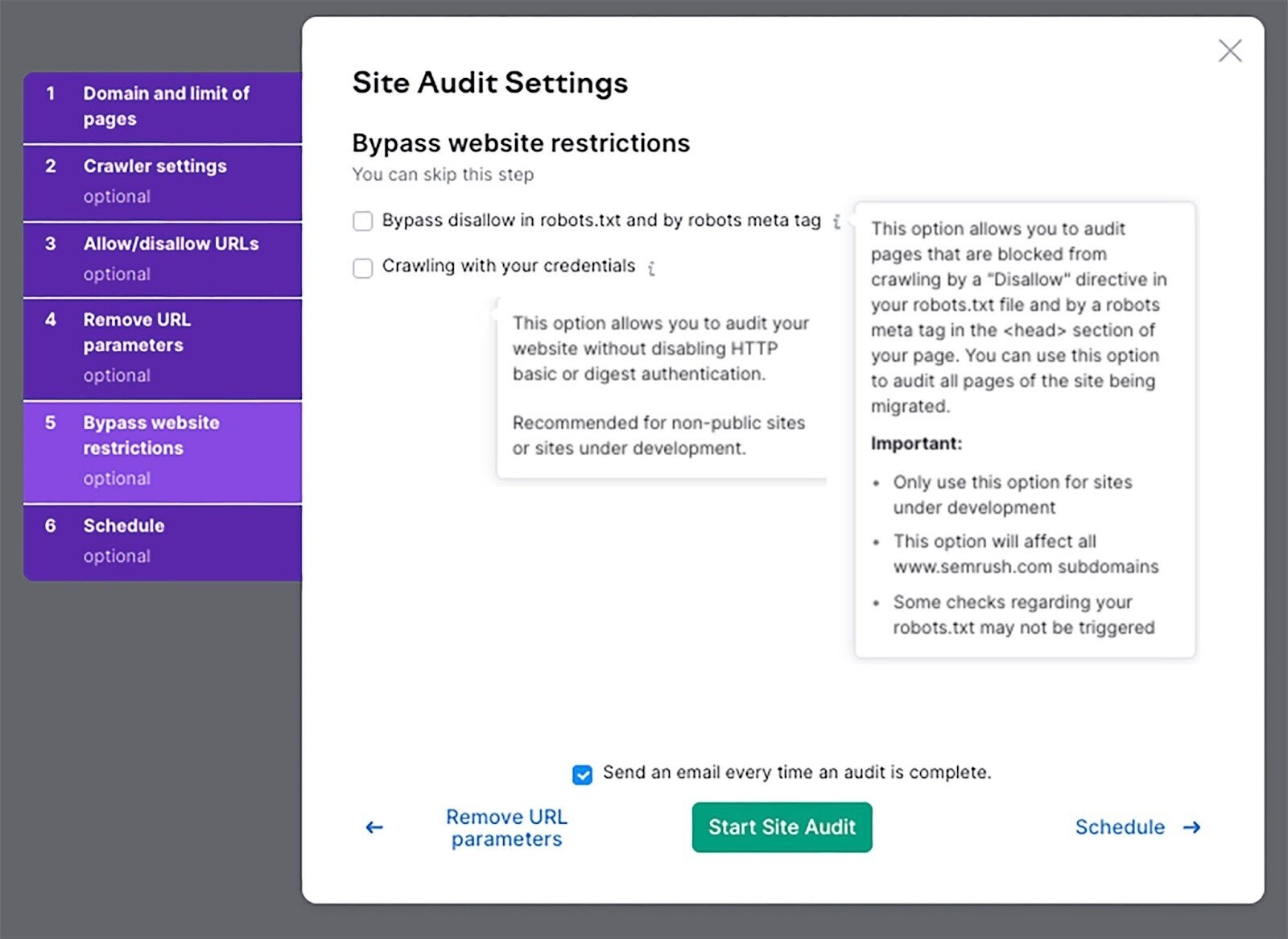

Website-Beschränkungen umgehen

Wenn sich deine Website noch in der Entwicklung befindet, kannst du mit dieser Einstellung eine Prüfung durchführen.

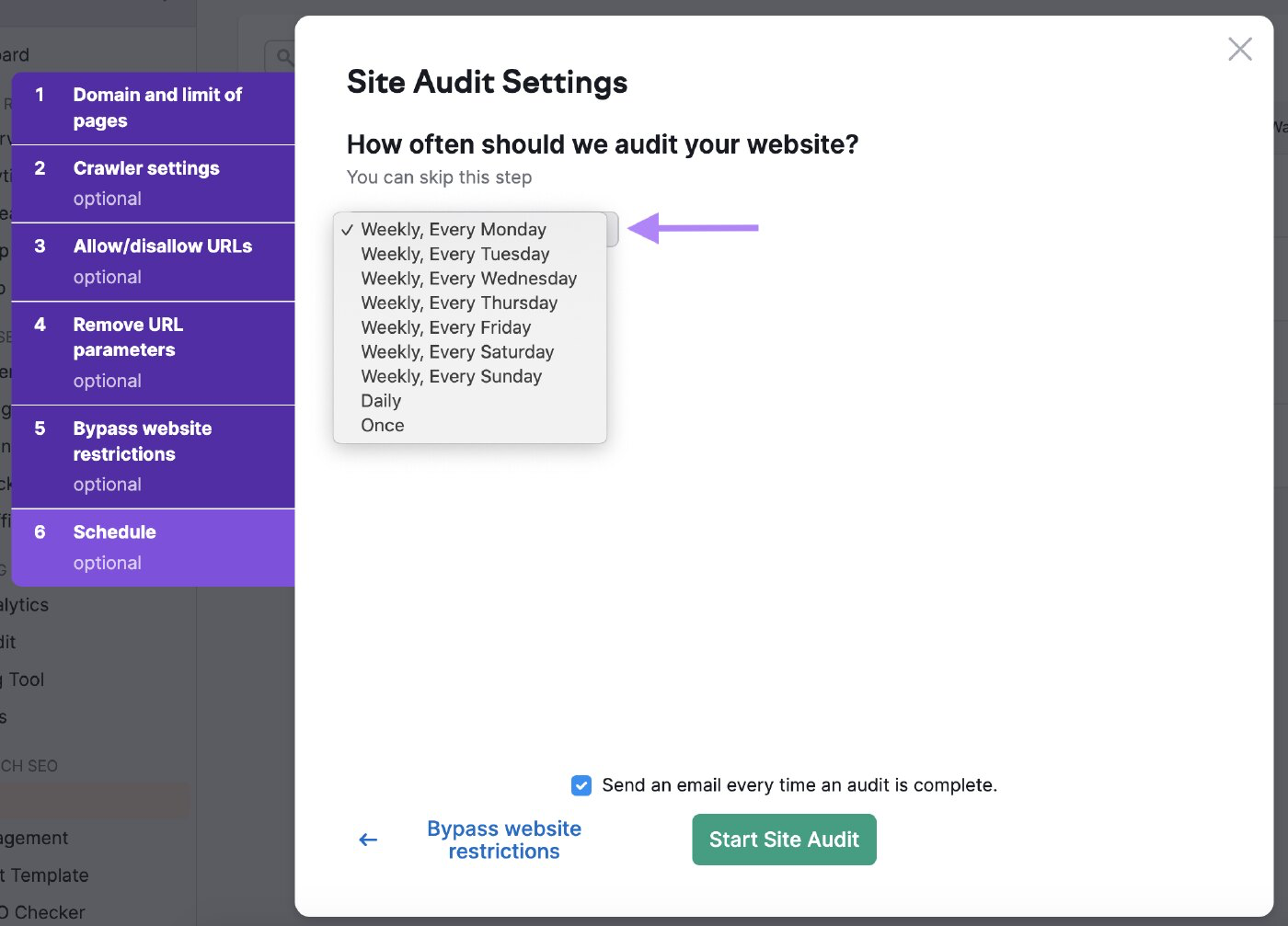

Planen Sie Ihre Audits

Du kannst festlegen, wie oft der Bot deine Website prüfen soll.

Plane sie regelmäßig ein, damit das Tool den Zustand deiner Website regelmäßig überprüft.

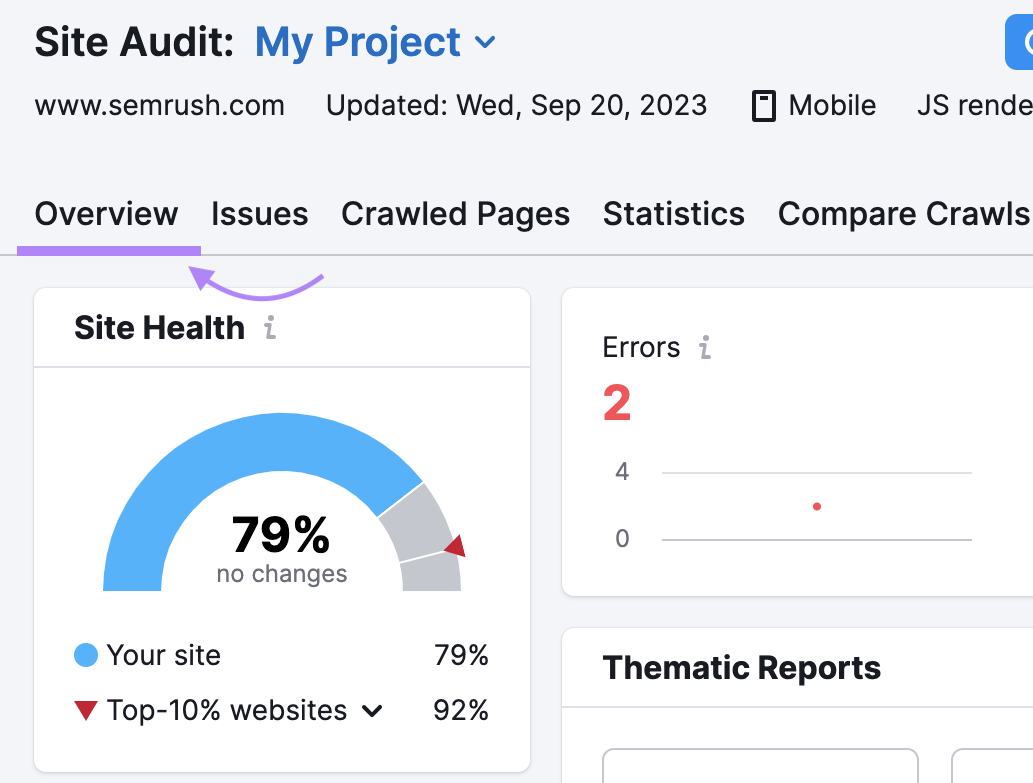

Analysiere die Ergebnisse

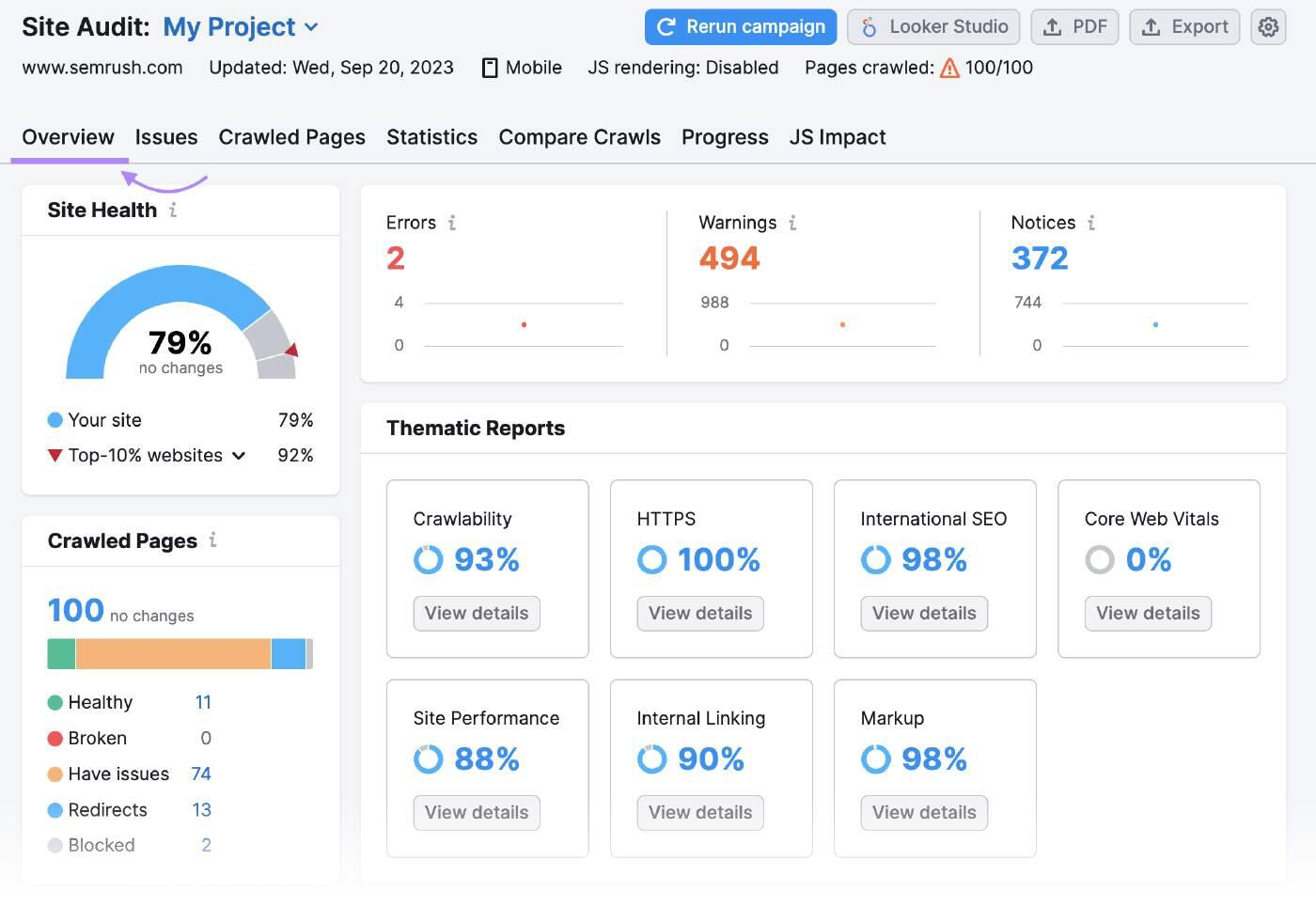

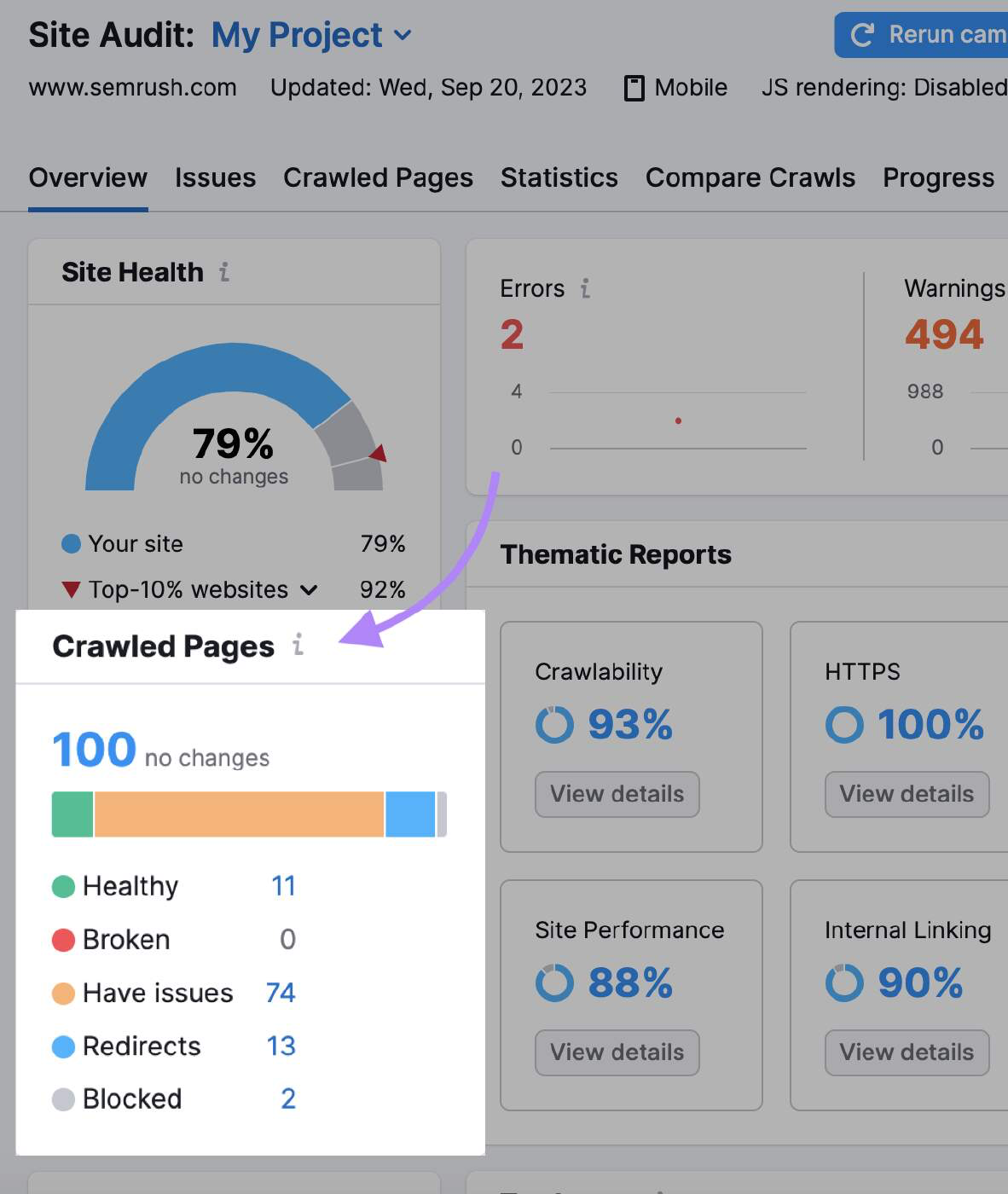

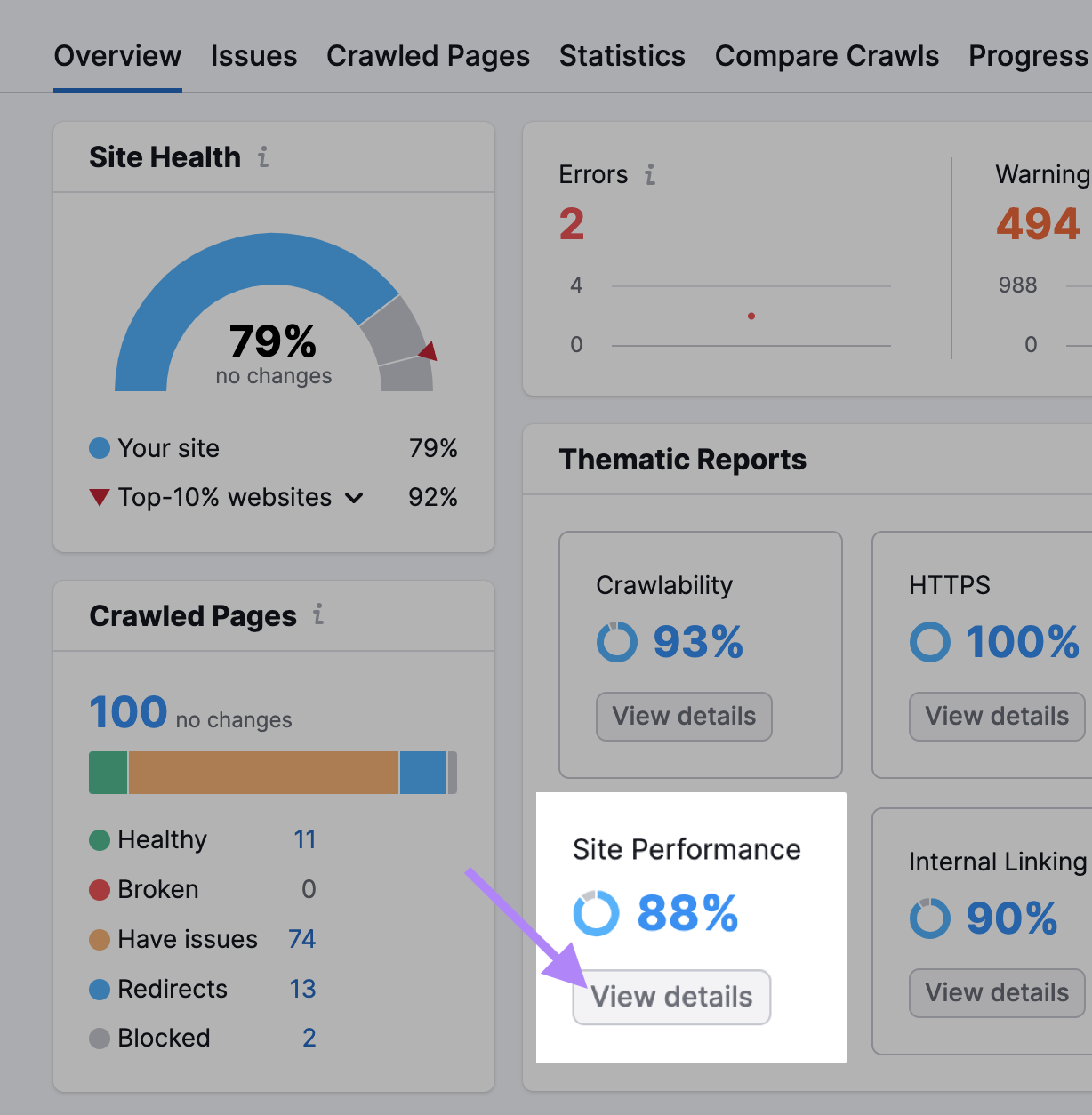

Die Übersicht der Website-Audits fasst alle Daten zusammen, die die Bots während des Crawls gesammelt haben.

"Gecrawlte Seiten" zeigt dir, wie viele Seiten "gesund", "kaputt" und "problematisch" waren.

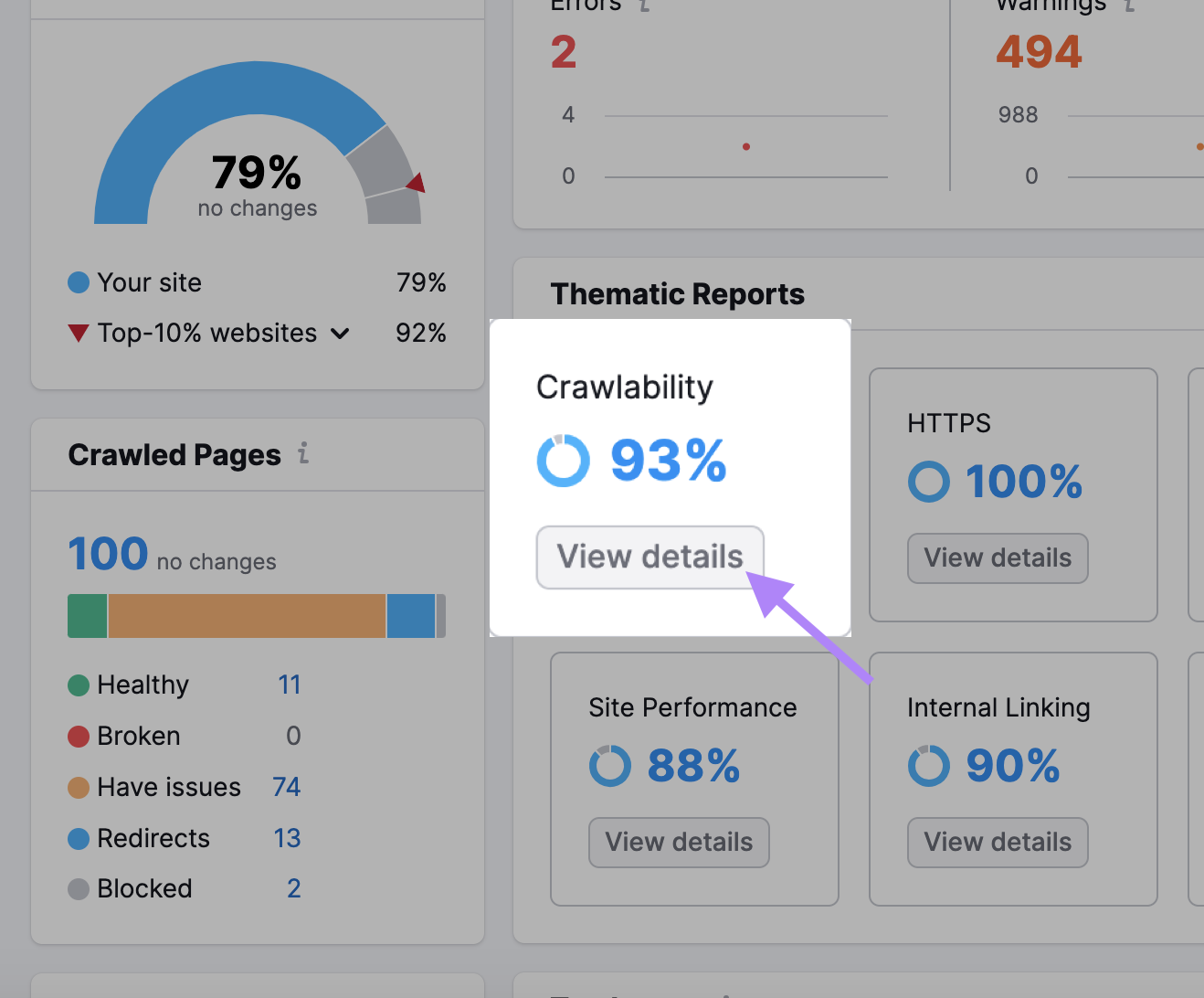

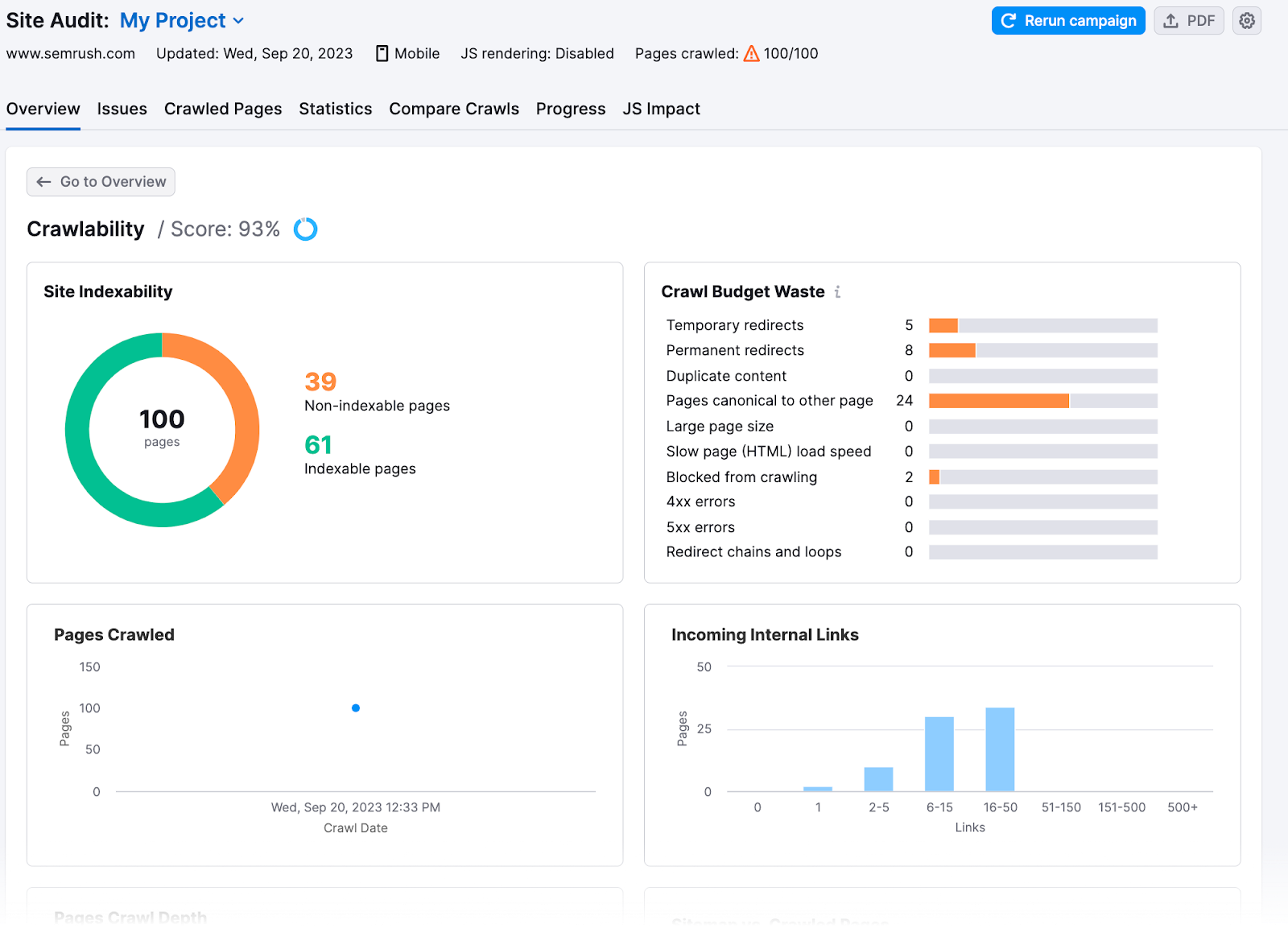

Außerdem erhältst du im Abschnitt "Crawlability" einen tieferen Einblick.

Hier erfährst du, wie viel des Crawl-Budgets für deine Website verschwendet wurde oder ob es Probleme mit dem Crawl-Budget gab.

8 Tipps für die Crawl-Budget-Optimierung

Sobald du die Probleme deiner Website kennst, kannst du sie beheben und die Crawling-Effizienz maximieren. Hier erfährst du, wie du dein Crawl-Budget optimieren kannst:

Überprüfe die Geschwindigkeit deiner Website

Googles Crawling ist durch Bandbreite, Zeit und die Verfügbarkeit von Googlebot-Ressourcen begrenzt. Wenn der Server einer Website schneller auf Anfragen antwortet, kann Google mehr Seiten crawlen.

Erhöhe die Geschwindigkeit deiner Website, um die Benutzerfreundlichkeit(UX) zu verbessern und Google zu helfen, deine Website schneller zu crawlen.

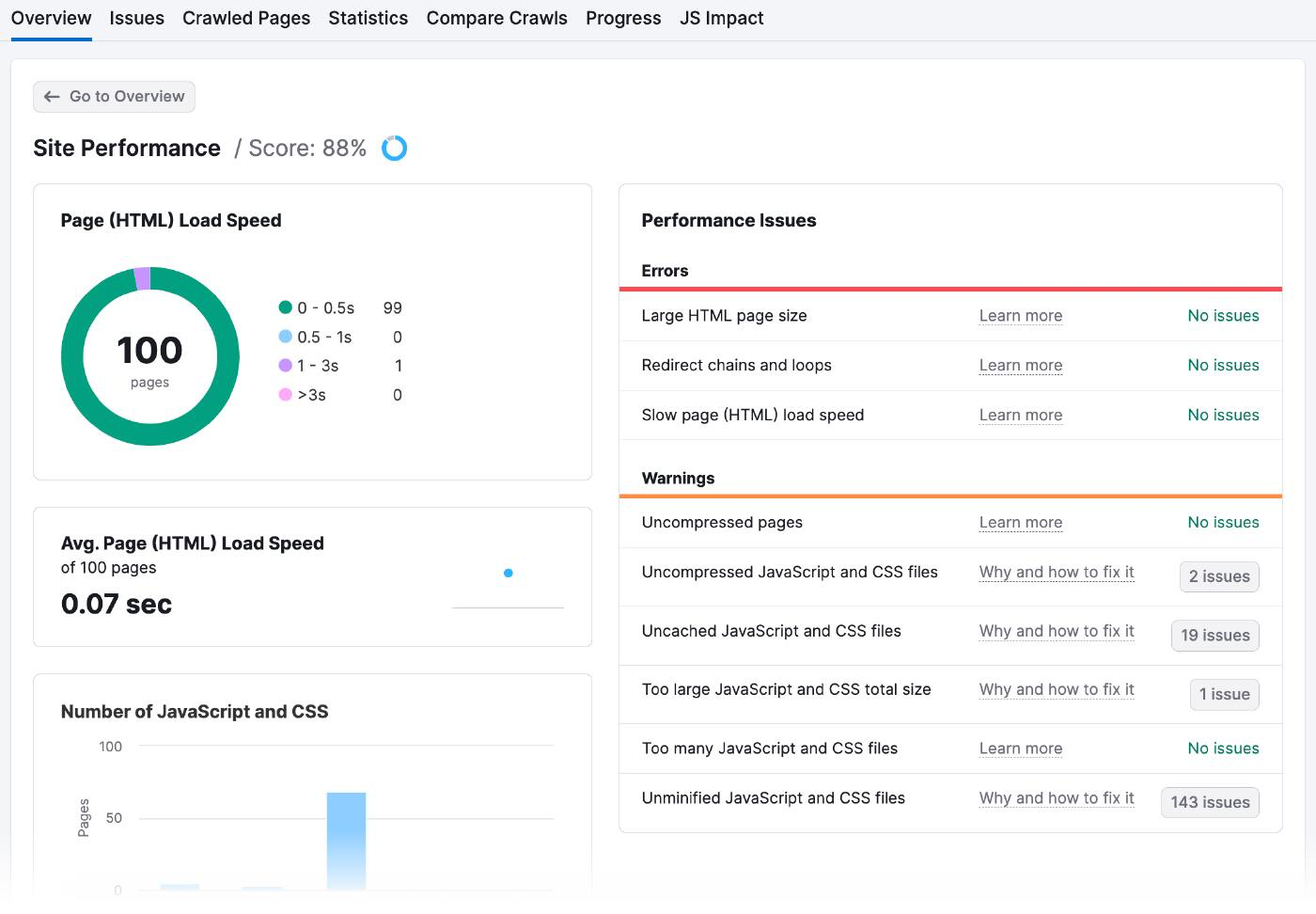

Gehe zu den Site Performance-Ergebnissen deines Site Audits, um die Ladezeiten deiner Seiten und eventuelle Leistungsprobleme zu überprüfen.

So sieht die Seite mit der Standortleistung aus:

Es gibt viele Möglichkeiten, die Seitengeschwindigkeit zu verbessern, zum Beispiel

- Optimiere deine Bilder: Verwende Online-Tools wie Optimizilla, um die Dateigröße zu reduzieren, ohne die Bilder zu verpixeln. Achte auf die richtige Größe der Bilder und wähle den passenden Dateityp (wie JPEG, PNG oder GIF).

- Minimiere deinen Code und deine Skripte: Überprüfe den Code deiner Website, um alles Unnötige oder Überflüssige zu entfernen. Fasse außerdem mehrere Dateien in einer einzigen zusammen und nutze das Browser-Caching, um die Daten auf dem Computer des Nutzers zu speichern, damit sie nicht jedes Mal neu geladen werden müssen.

- Verwendung eines Content Delivery Network (CDN): Ein CDN ist ein Netzwerk von Servern in verschiedenen Teilen der Welt. Wenn jemand versucht, auf deine Website zuzugreifen, schickt das CDN ihm automatisch die Inhalte von dem Server, der ihm am nächsten ist, was bedeutet, dass sie schneller geladen werden. Du musst dich bei einem CDN-Dienst wie Amazon Cloudfront anmelden, die Inhalte deiner Website auf deren Server hochladen und deine Website so konfigurieren, dass sie die URLs des CDNs anstelle deiner eigenen verwendet.

Interne Verlinkung und Seiten-Sitemaps verbessern

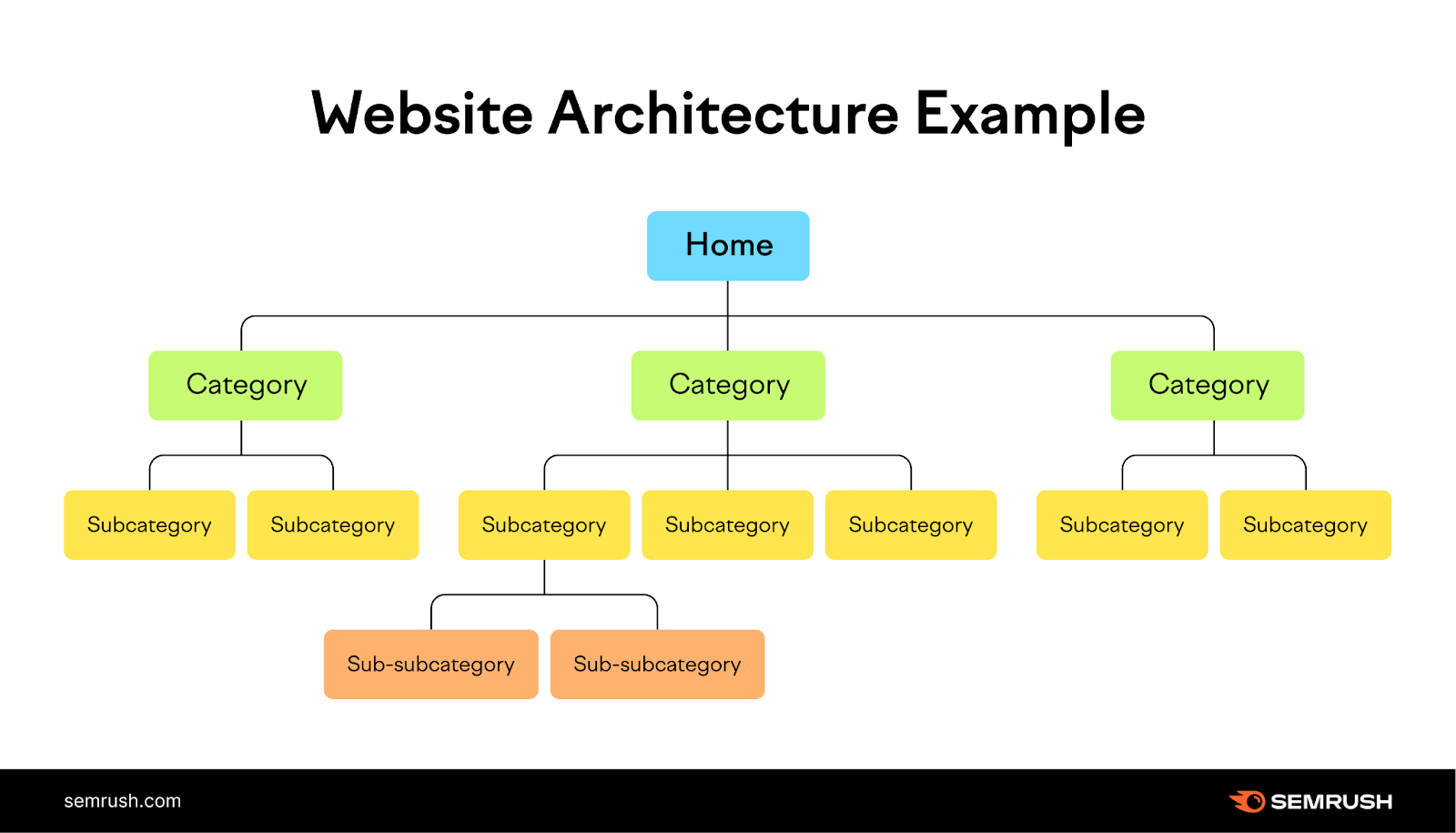

Das Hinzufügen einer logischen internen Linkstruktur und einer Sitemap gibt den Bots die Richtung vor, welche Seiten sie indizieren sollen.

Interne Links sind ein natürlicher Weg für Suchmaschinen-Crawler, neue Seiten zu entdecken und zu bewerten, während Sitemaps ihnen helfen, die Struktur und Hierarchie deiner Inhalte zu verstehen.

Stell dir deine Website wie einen Baum vor, mit der Homepage an der Spitze und den Ästen, die die verschiedenen Kategorien darstellen. Jeder Zweig sollte zu kleineren Blättern (Seiten) führen, die mit ihm zusammenhängen. So entsteht eine klare und logische Struktur für deine Website, in der die Nutzer leicht navigieren können.

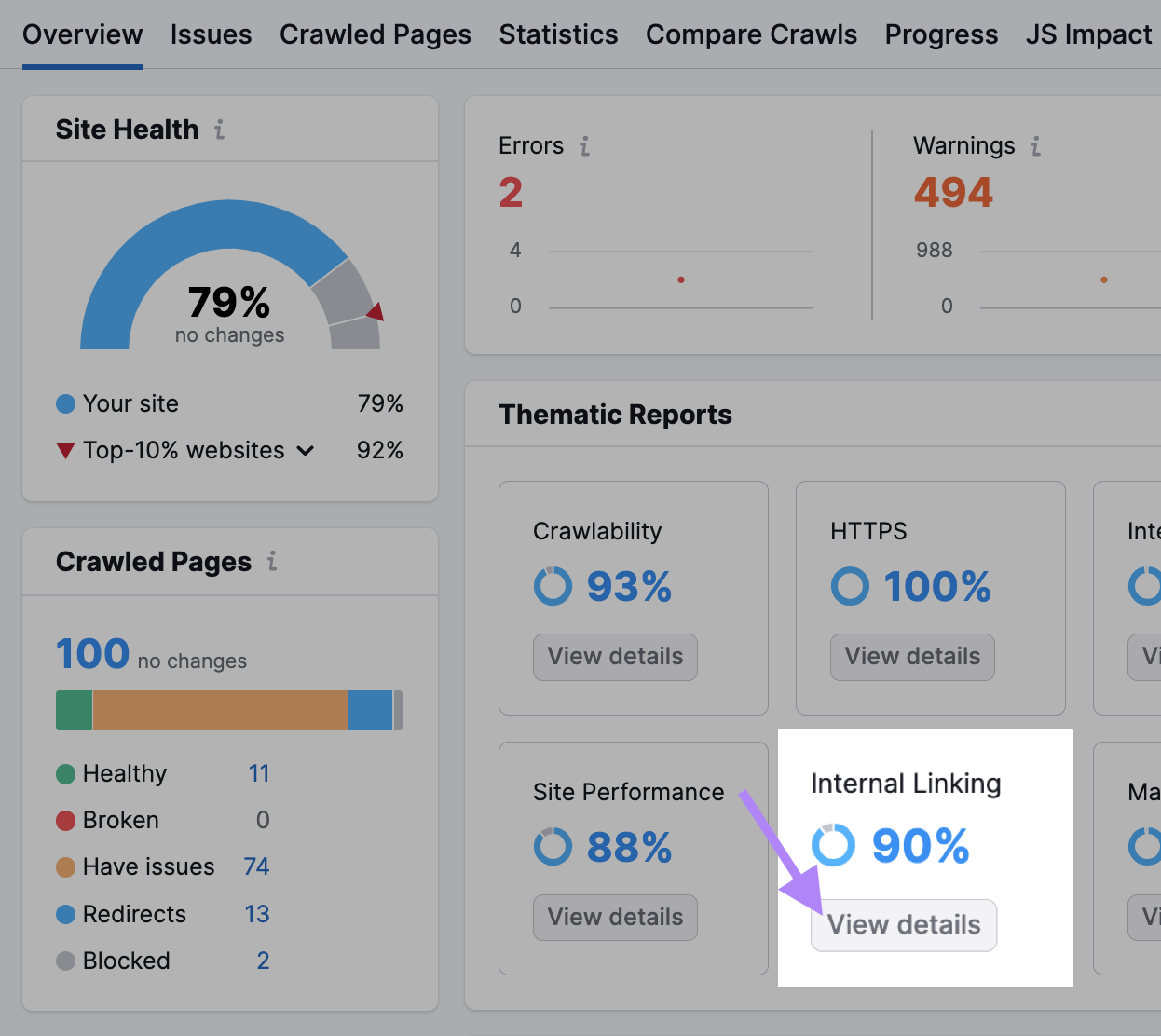

Schau dir den Abschnitt Interne Verlinkung in deinem Site Audit an, um einen Eindruck davon zu bekommen, wie gut du das gemacht hast.

Wenn du diese Daten hast, kannst du deine interne Verlinkungsstruktur folgendermaßen verbessern:

- Die Balken in der Internen Verlinkungsstruktur zeigen dir, welche deiner Seiten stark, mittelmäßig und verbesserungsbedürftig sind. Füge mehr interne Links zu den Seiten in den letzten beiden Kategorien hinzu.

- Erstelle Themencluster, indem du verwandte Seiten unter einem Thema zusammenfasst und sie miteinander verknüpfst. Nehmen wir an, du betreibst einen Blog über eine gesunde Lebensweise. Deine Hauptseite könnte "Gesundes Leben" heißen und deine Themencluster könnten "Ernährung", "Fitness" und "Psychische Gesundheit" sein.

- Google wird höchstwahrscheinlich Seiten mit vielen internen Links crawlen. Diejenigen, die neu sind und nicht genügend interne Links haben, die auf sie verweisen, könnten Probleme bekommen. Wenn du z.B. vor kurzem einen Artikel zum Thema "Marketingvorhersagen für 2024" veröffentlicht hast, verlinke von deinen wichtigsten Seiten darauf, um die Aufmerksamkeit von Google auf dich zu lenken und deinen Traffic zu erhöhen.

URLs ausblenden, die du nicht in den Suchergebnissen haben willst

Markiere Kassenseiten, Anzeigenseiten, Anmeldeseiten und Danksagungsseiten als "noindex", damit sie nicht in den Suchmaschinenergebnissen erscheinen. Wie andere Meta-Tags wird auch das "noindex"-Tag in den Kopf einer Webseite <>eingefügt.

Dieses Tag ist besonders nützlich für doppelte Seiten oder andere Seiten, die du geheim halten willst.

Die Bots werden diese Seiten zwar immer noch crawlen, um das Tag zu sehen, aber sie werden sich das merken und das Crawlen dieser Seiten in Zukunft einschränken.

Um Suchmaschinen mitzuteilen, dass sie eine bestimmte Seite nicht indizieren sollen, verwende die Robots-Meta-Tags mit dem Attribut "noindex".

Platziere den folgenden Tag in den <head> deiner Seite:

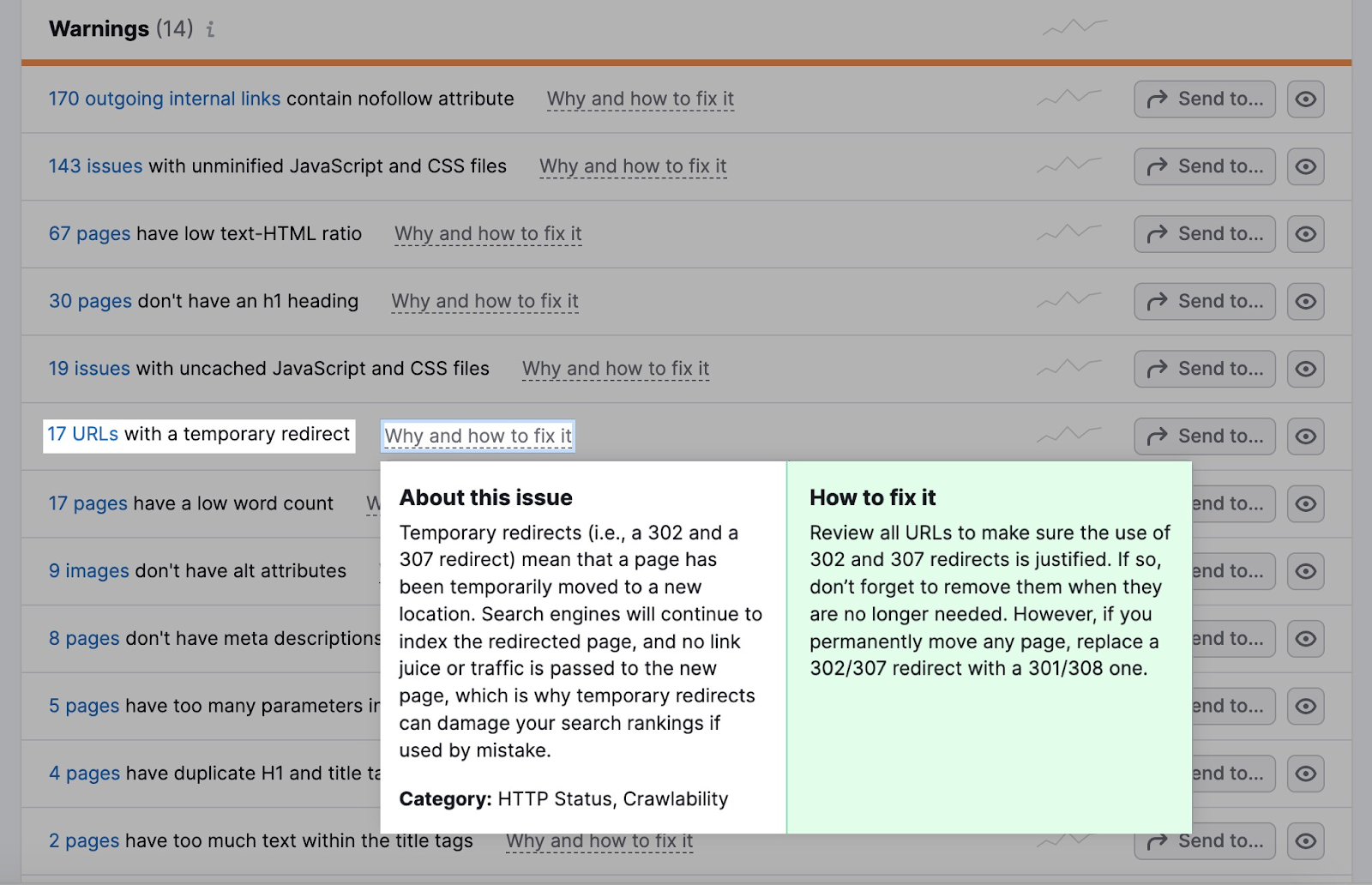

<meta name="robots" content="noindex">Umleitungen reduzieren

Redirects leiten Bots automatisch von einer Webseite zu einer anderen. Wenn der Bot eine Seite besucht, die verschoben oder gelöscht wurde, leitet ihn die Umleitung zum neuen Standort der Seite oder zu einer Seite, die erklärt, warum die ursprüngliche Seite nicht mehr verfügbar ist.

Weiterleitungen benötigen mehr Ressourcen vom Bot, da er mehr Seiten als nötig besucht.

Gehe auf die Registerkarte " Probleme" in deinem Site Audit.

Im Abschnitt Warnungen erfährst du, wie viele URLs eine temporäre Umleitung haben.

Die meisten Browser folgen maximal fünf Weiterleitungsketten in einem Crawl.

Wenn du Weiterleitungen verwendest, achte darauf, dass sie logisch sind.

Nehmen wir an, eine Sport-Website hat einen Artikel über ein Fußballspiel aus dem letzten Jahr mit der URL "example.com/football-game-2022".

Das diesjährige Spiel hat jedoch eine andere URL: "example.com/football-game-2023".

Um Verwirrung zu vermeiden, kann die Website eine Umleitung einrichten, so dass jeder, der versucht, auf "beispiel.com/fussballspiel-2022" zuzugreifen, automatisch auf "beispiel.com/fussballspiel-2023" umgeleitet wird.

Diese Umleitung wäre logisch.

Andererseits könnte die Website mehrere unnötige Weiterleitungen haben, wie z.B. die Weiterleitung von "beispiel.com/fussballspiel-2022" zu "beispiel.com/fussballspiel-recaps" und dann zu "beispiel.com/fussballspiel-2023".

Dadurch würde eine Weiterleitungskette entstehen, die Ressourcen verschwendet und die Crawl-Effizienz der Website beeinträchtigen kann.

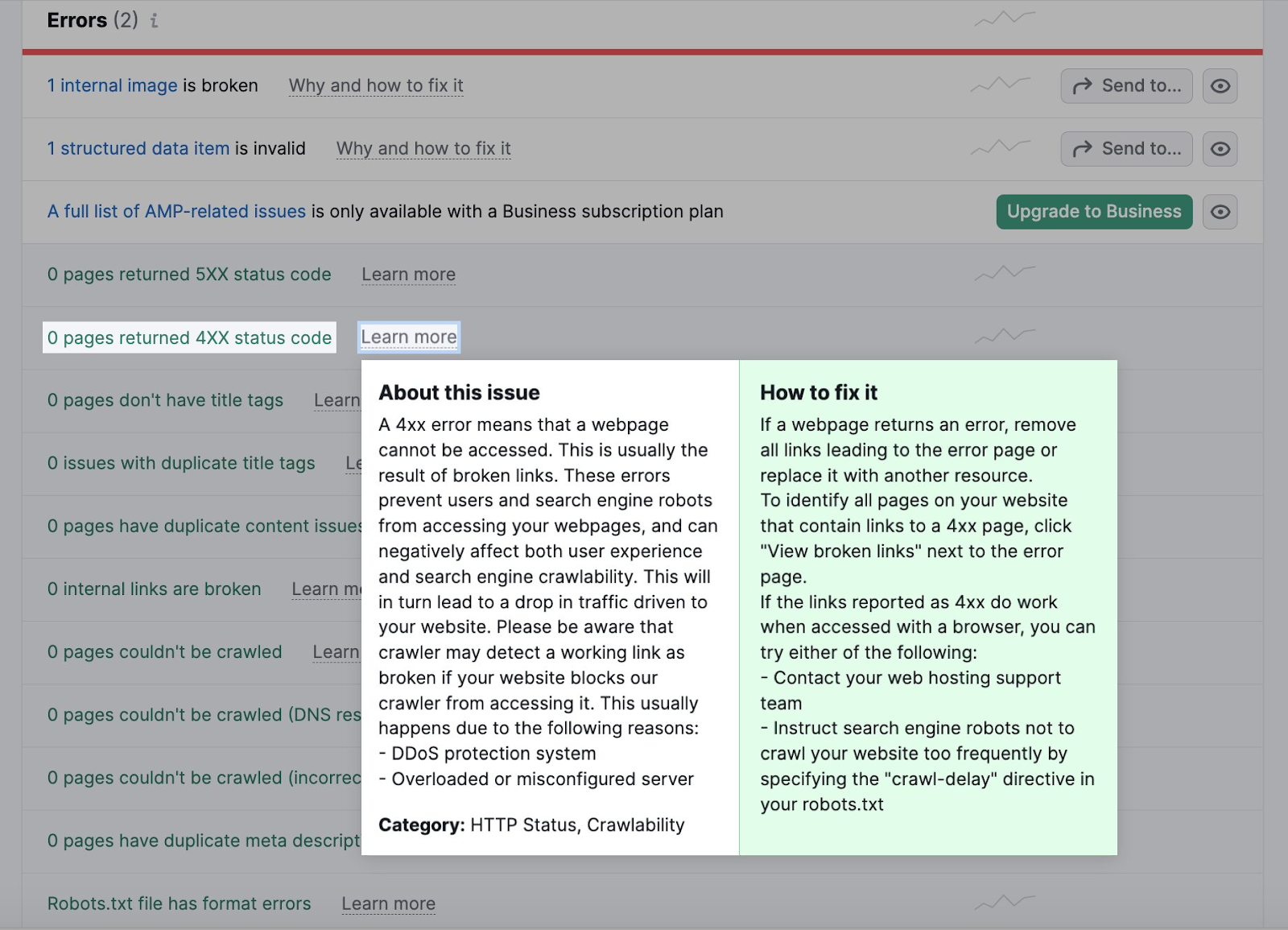

Defekte Links reparieren

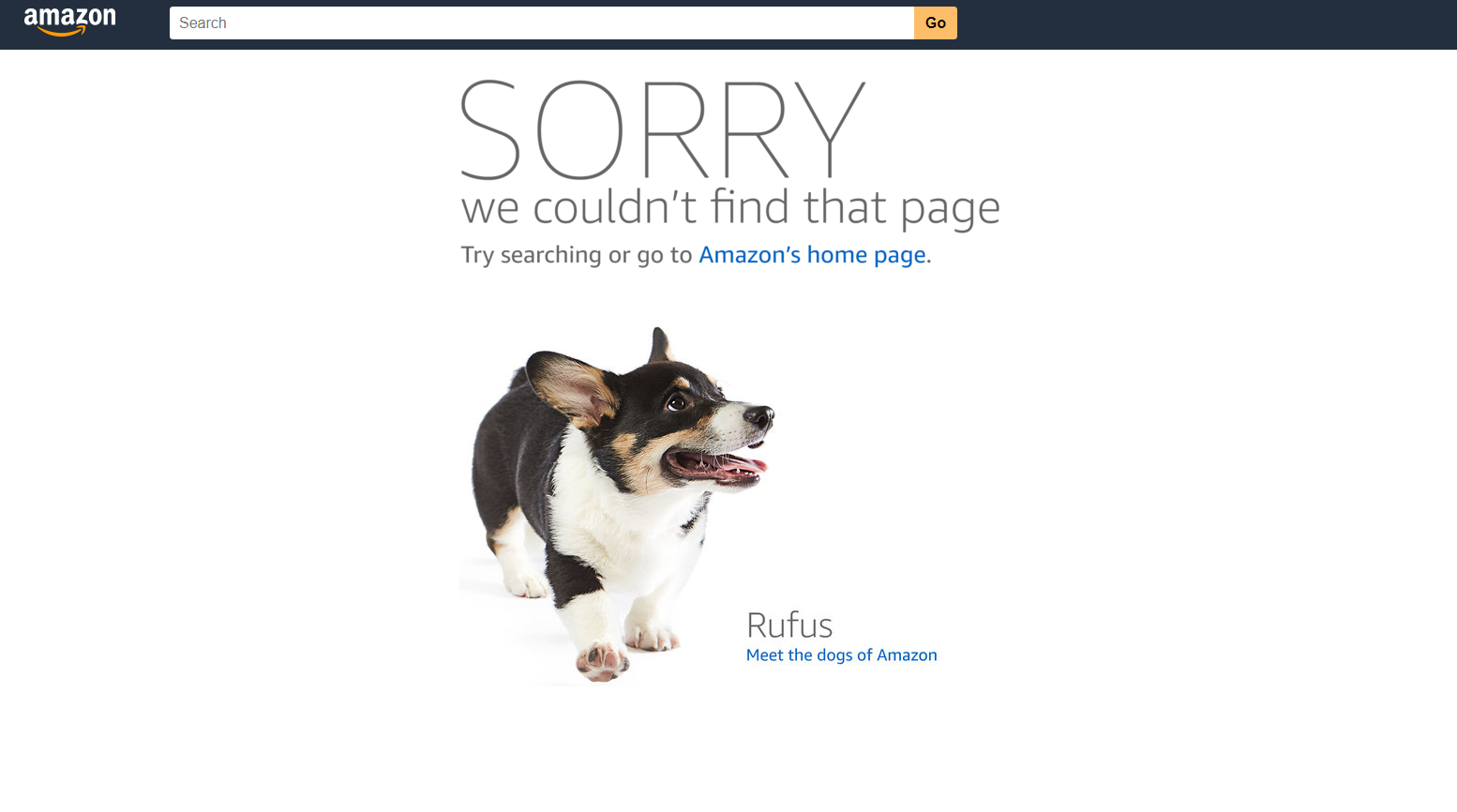

Kaputte Links sind Seiten, auf die die Bots nicht zugreifen können. Sie schaden deiner Crawlability und dem Nutzererlebnis.

Wenn Bots nicht auf eine Seite zugreifen können, können sie sie nicht crawlen und indexieren. Zu viele dieser Fehler verlangsamen den Crawling-Prozess und fressen dein Crawl-Budget auf.

Ein 404-Fehler bei Amazon sieht zum Beispiel so aus.

Du kannst defekte Links als 4xx-Fehler auf der Registerkarte " Probleme" deines Site Audits identifizieren.

Klicke auf die Anzahl der Seiten, um nach defekten Seiten zu suchen. Ersetze dann alle Links, die zu der defekten Seite führen, durch eine andere Seite.

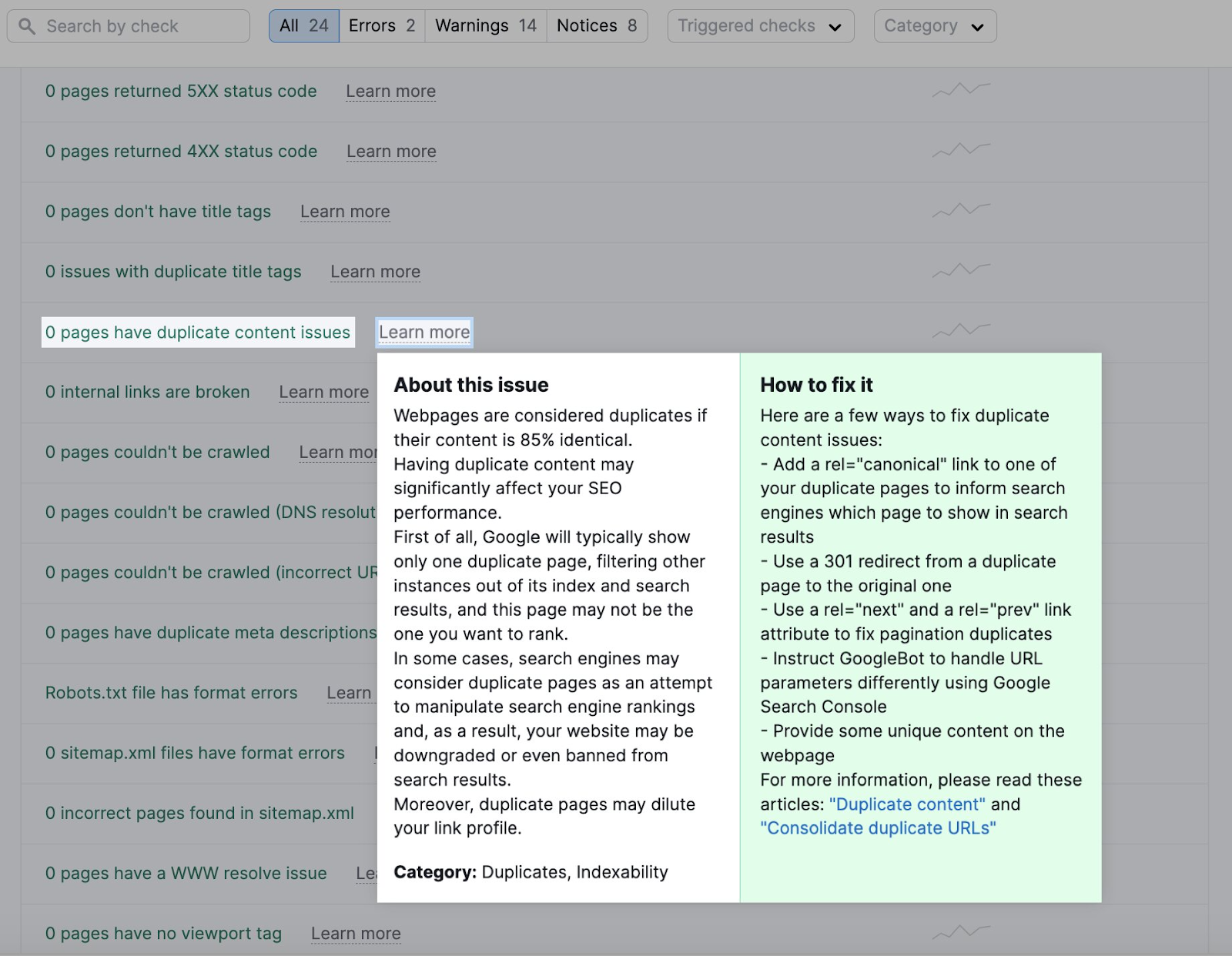

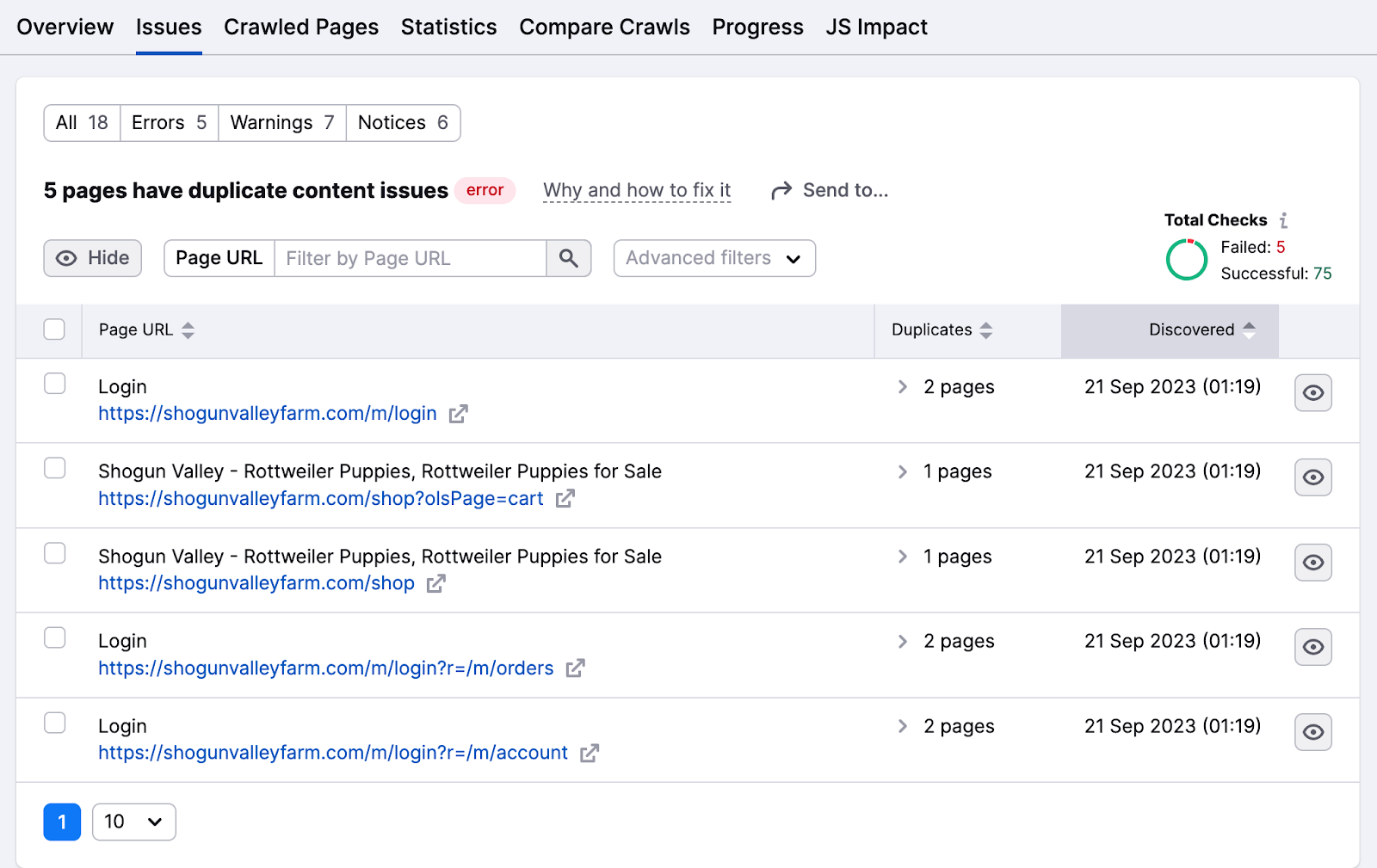

Eliminiere doppelte Inhalte

Bots betrachten Webseiten als Duplikate, wenn der Inhalt zu 85% identisch ist. Reduziere doppelte Inhalte, um zu verhindern, dass Bots verwirrt werden und dieselbe Seite mehrfach crawlen, wodurch Zeit und Ressourcen verschwendet werden.

Doppelte Inhalte wirken sich auch auf die Indexierung aus, da Suchmaschinen sie als Manipulationstaktik betrachten können.

Die Registerkarte " Probleme" hebt Probleme mit doppelten Inhalten hervor.

Klicke auf die Seitennummer, um die Liste der Seiten mit diesen Problemen zu überprüfen.

Es gibt einige Möglichkeiten, Probleme mit doppelten Inhalten zu beheben:

- Mache den Inhalt einzigartig, indem du ihn in ein Themencluster einordnest oder ihm ein Fokus-Schlüsselwort zuweist

- Füge das kanonische Tag "rel=canonical" in den HTML-Code einer dieser Seiten ein, um Google mitzuteilen, welche Seite in den Suchergebnissen auftauchen soll

- Füge eine 301-Weiterleitung von der doppelten Seite zur Originalseite hinzu (nicht die beste Idee, um Weiterleitungen zu reduzieren)

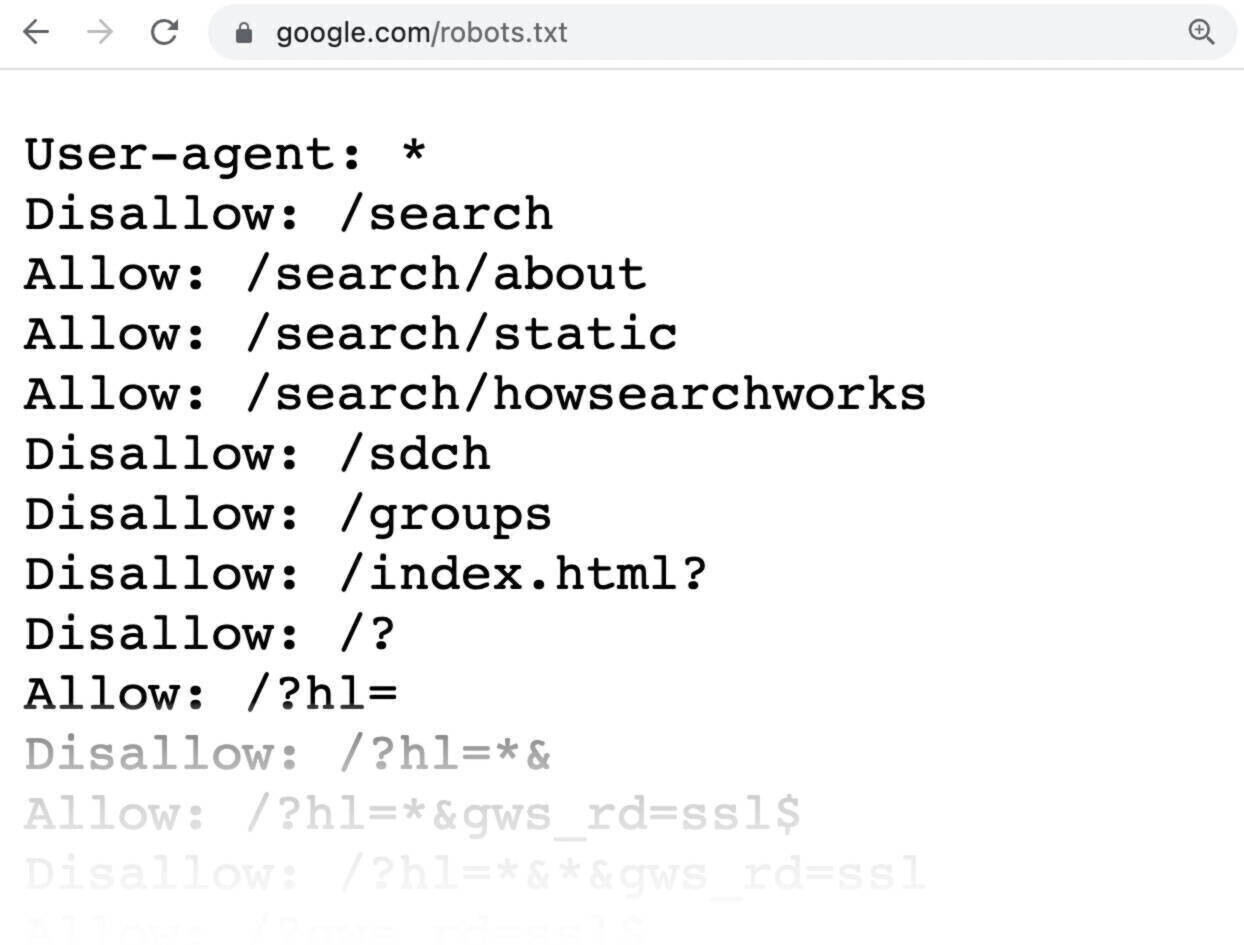

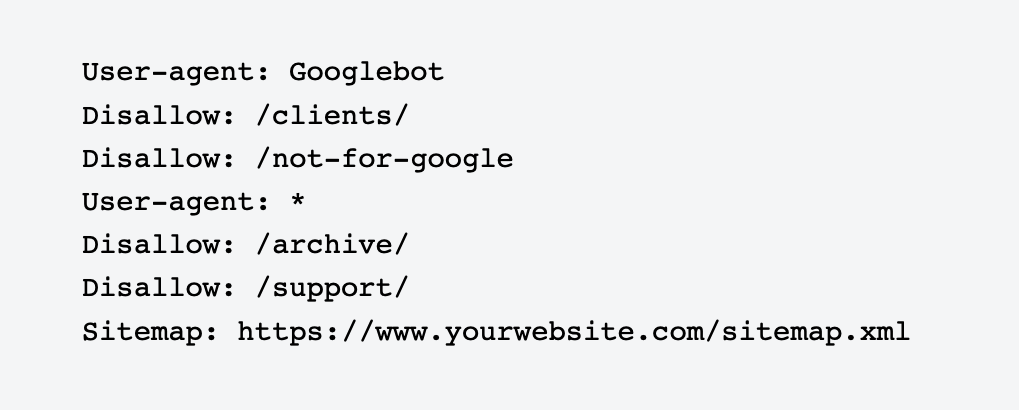

Robots.txt verwenden

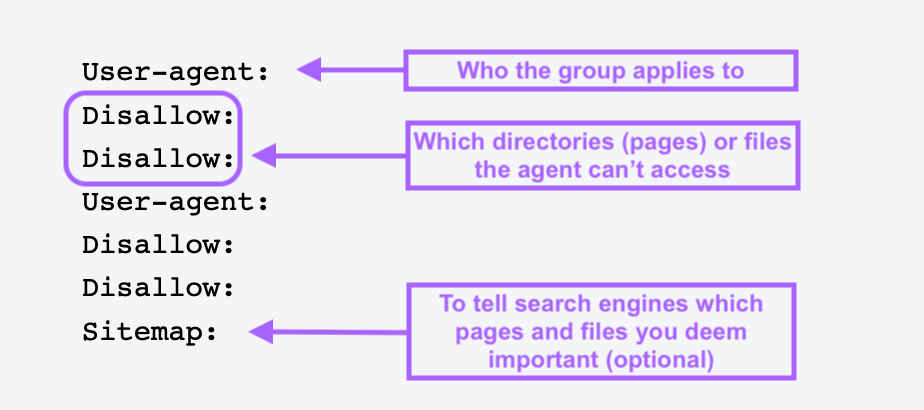

Eine robots.txt-Datei ist eine Textdatei, die du im Stammverzeichnis deiner Website platzierst, um Suchmaschinen-Bots mitzuteilen, welche Seiten oder Abschnitte der Website sie nicht crawlen oder indexieren sollen.

Robots.txt-Dateien helfen dir, unwichtige oder private Seiten wie Anmeldeseiten zu blockieren. Du willst nicht, dass Bots diese Seiten indizieren und ihre Ressourcen verschwenden, also ist es am besten, wenn du den Bots sagst, was sie tun müssen.

Hier siehst du, wie eine einfache robots.txt-Datei aussieht:

Alle Seiten nach Disallow gib die Seiten an, die du nicht indiziert haben möchtest.

Um eine robots.txt-Datei zu erstellen, verwende ein robots.txt-Generator-Tool. Du kannst sie auch selbst herstellen.

Öffne zunächst ein .txt-Dokument mit einem beliebigen Texteditor oder Webbrowser und nenne das Dokument robots.txt.

Dann fügst du Direktiven hinzu, das sind mehrere Zeilen mit Anweisungen.

Wenn du eine robots.txt-Datei hast, speichere sie und lade sie auf deine Website hoch. Der Upload-Prozess hängt von deinem Webhosting und der Dateistruktur der Website ab.

Wende dich an deinen Hosting-Provider oder suche online nach Hilfe, wie du das machen kannst. Suche z.B. nach "robots.txt-Datei in Shopify hochladen", um genaue Anweisungen zu erhalten.

Verwaiste Seiten vermeiden

Verwaiste Seiten haben keine internen oder externen Links, die auf sie verweisen. Diese Seiten können für Crawler schwer zu finden sein, deshalb ist es wichtig, sie von anderen Bereichen deiner Website aus zu verlinken.

Sobald du die Liste gefunden hast, verlinke diese Seiten von anderen hochrangigen Domains auf deiner Website.

Du kannst auch verwandte Blogbeiträge, Produktseiten und Kategorieseiten verlinken, damit die Crawler sie leichter finden können.

Maximiere dein Crawl-Budget mit Semrush

Während Google kleine Websites in der Regel problemlos crawlen kann, sollten größere und komplexere Websites einen proaktiven Ansatz wählen, um ihre Suchleistung zu steuern.

Das bedeutet, dass wir verschiedene technische Aspekte einer Website regelmäßig überwachen und optimieren, um sicherzustellen, dass sie zugänglich, gut strukturiert und gut sichtbar bleibt.

Unabhängig von der Größe deines Unternehmens kannst du mit dem Site Audit Tool von Semrush den Zustand deiner Website beurteilen, die Crawlability optimieren und Fehler beheben, bevor sie Schaden anrichten. Auf diese Weise bleibt deine Seite ein starker Akteur in den SERPs.