Was fällt dir als Erstes ein, wenn du an das Ranking einer Website denkst? Content? Oder vielleicht Backlink?

Beides sind entscheidende Faktoren für die Positionierung einer Website in den Suchergebnissen. Aber sie sind nicht die einzigen Rankingfaktoren.

Auch zwei weniger bekannte Faktoren spielen eine wichtige Rolle in der Suchmaschinenoptimierung – Crawlbarkeit und Indexierbarkeit. Viele Website-Betreiber haben jedoch noch nie oder nur etwas von ihnen gehört, obwohl sie wichtiger Bestandteil der technischen SEO sind.

Doch selbst kleine Probleme mit der Crawlbarkeit oder Indexierbarkeit können dazu führen, dass deine Website ihre Rankings verliert. Und das unabhängig davon, wie stark deine Inhalte sind und wie viele Backlinks du hast. Wenn Google deine Seite nicht indexiert und dementsprechend im Index aufnimmt, dann ist deine Website unsichtbar. Du wirst in den Suchergebnissen nicht auftauchen und gleichzeitig keinen Traffic erzielen.

Was ist ein Webcrawler (Bot)?

Um diese Begriffe zu verstehen, werfen wir zunächst einen Blick darauf, wie Suchmaschinen Seiten erkennen und indexieren. Um mehr über neue (oder aktualisierte) Seiten zu erfahren, verwenden sie sogenannte Webcrawler, auch Bots genannt. Deren Aufgabe ist es, Links im Web mit zu verfolgen, um neue Inhalte zu finden wie Webseiten (zu crawlen) und zu indexieren.

Wie Google erklärt:

Die Crawler besuchen die Webseiten und folgen den darauf veröffentlichten Links – ähnlich wie du beim Surfen im Internet. Sie springen von Link zu Link und senden die dahinter liegenden Informationen an die Google-Server.

Der ehemalige Google-Mitarbeiter Matt Cutts hat den Prozess in einem interessanten Video ausführlich erläutert. Du kannst es dir hier ansehen:

Kurz gefasst beziehen sich beide Begriffe darauf, wie weit eine Website es Suchmaschinen ermöglicht, auf ihre Inhalte zuzugreifen und sie zu indexieren, also ihrem Index hinzuzufügen.

Was ist Crawlbarkeit?

Die Crawlbarkeit einer Website ist das Ausmaß, in dem sie es Suchmaschinen ermöglicht, auf ihre Inhalte zuzugreifen und sie auszulesen, also zu crawlen. Die Google Suchmaschine entdeckt Webseiten mithilfe des Google Bots. Wenn deine Webseite nicht crawlbar ist, wird Google diese auch nicht finden und es kommt nicht zur Indexierung deiner Webseite.

Wieso ist Crawlbarkeit wichtig?

Defekte Links oder Sackgassen können zu Crawling-Problemen führen – das heißt, die Suchmaschine kann nicht auf bestimmte Inhalte der Website zugreifen. Wenn eine Website keine Probleme mit der Crawlbarkeit aufweist, können Webcrawler problemlos auf den gesamten Inhalt einer Website zugreifen, indem sie Links zwischen den einzelnen Seiten folgen. Nicht gecrawlte Seiten können auch nicht im Web indexiert werden.

Was ist Indexierbarkeit?

Die Indexierbarkeit einer Website ist das Ausmaß, in dem sie es Suchmaschinen ermöglicht, ihre Inhalte zu analysieren sowie zu prüfen und dem Suchindex hinzuzufügen.

Auch wenn Google eine Website crawlen konnte, hat die Suchmaschine vielleicht Schwierigkeiten, alle Seiten zu indexieren, was meist auf Probleme mit der Indexierbarkeit zurückzuführen ist. Hierbei gibt es verschiedene Probleme, die der Grund für eine Verhinderung der Indexierung sein können. Mögliche Probleme und auch die Lösungen werde ich dir im Laufe des Artikels zeigen.

Wieso ist Indexierbarkeit wichtig?

Jede Seite muss von Google nicht nur gecrawlt, sondern auch indexiert, also im "Google Index" registriert sein. Ohne die Registrierung, gilt die Seite zwar als gecrawlt, doch nicht indexiert, also nicht registriert. Ist eine Seite nicht indexiert, wird diese auch nicht in den Suchergebnissen angezeigt und Nutzer können die URL nicht finden. Indexierbarkeit ist somit ein Zeichen dafür, dass die Seite zumindest die allerersten Prüfungen von Google durchlaufen ist.

Warum indexiert und findet Google meine Seite nicht?

Das Google deine Seite nicht findet liegt daran, dass Google die Seite nicht richtig crawlen kann und deswegen wird diese nicht indexiert. Heißt deine Webseite ist nicht im Index. Oder deine URL ist schlicht weg zu alt Es kann aber auch daran liegen, dass Google nicht alle Unterseiten deiner Webseite findet. Um dieses Problem zu lösen kann ma seine Webseite bei Google eintragen und vom Bot crawlen lassen oder die Speerung einzelner Seiten über robots.txt beheben.

Google hat meine Webseite weder gecrawled noch indexiert. Wie ist die Ursache?

Ursachen, warum Google deine Webseite nicht crawlt und indexiert kann folgende Ursachen haben:

- Verlinkungen fehlen: Das Dokument bzw. die URL ist nicht ausreichend verlinkt, sowohl intern als auch extern

- Crawl: Die URL deiner Website ist neu und wurde noch nicht von Google gecrawled

- Index: Du hast vermutlich die Indexierung unterdrückt trotzdessen, das Google deine Webseite gecrawled hat.

- Robots.txt: Deine Webseite wurde gecrawled aber du hast die Indexierung blockiert.

- Duplicate Content: Wenn du doppelter Inhalte auf deiner Webseite hast, wird deine Webseite aus dem Idex ausgeschlossen.

- Kanonisierung: Der Inhalt auf deiner Webseite ist vorhanden aber falsch kanonisiert

- Keine Indexierung trotz Crawl: Deine Webseite wurde gecrawled aber nicht indexiert, da deine URL zu alt ist.

Warum erscheint meine Webseite in den Suchergebnissen trotz Speerung durch robots.txt?

Trotz Sperrung mit robots.txt, kann es passieren, das die gespeerte Webseite in den Suchergebnissen angezeigt wird. Der Crawler beachtet die Anweisung aus der robots.txt und crawlt den gespeerten Inhalt nicht. Dementsprechend hat die Suchmaschine keine Informationen über den Inhalt der Webseite. Mit robots.txt ist dennoch keine Garantie gewährleistet für das nicht erscheinen der Webseite in den Suchergebnissen.

Welche Faktoren beeinflussen Crawlbarkeit und Indexierbarkeit einer Webseite?

1. Seitenstruktur

Die Informationsarchitektur der Website spielt eine entscheidende Rolle für die Crawlbarkeit.

Ein Webcrawler durchsucht das Web, indem er Links folgt, ähnlich wie du es tust, wenn du durchs Internet surfst. Wenn deine Website nun Seiten enthält, auf die keinerlei Links verweisen, werden diese von Webcrawlern womöglich nicht gefunden.

Natürlich könnten sie diese Seiten immer noch über externe Links finden, wenn solche vorhanden sind. Insgesamt kann eine schwache Linkstruktur jedoch Probleme mit der Crawlbarkeit verursachen.

2. Weiterleitungsschleifen

Defekte Weiterleitungen oder Weiterleitungsschleifen führen den Crawler nicht weiter, was ebenfalls ein Crawlbarkeit-Problem darstellt.

3. Serverfehler

Ähnlich können fehlerhafte Server-Redirects und viele andere Serverprobleme verhindern, dass Webcrawler auf alle deine Inhalte zugreifen können.

4. Nicht unterstützte Skripte und andere technische Faktoren

Crawling-Probleme können auch aufgrund der Technologie auftreten, die du für die Website verwendest. Da Crawler beispielsweise Formularen nicht folgen können, bedeutet das Verbergen von Inhalten hinter einem Formular ebenfalls Probleme mit der Crawlbarkeit.

Auch verschiedene Skripte wie JavaScript oder Ajax können Inhalte für Webcrawler unzugänglich machen.

5. Zugang für Webcrawler blockieren

Zu guter Letzt kannst du Webcrawler auch absichtlich daran hindern, Seiten deiner Website zu indexieren.

Das geht mit der robots.txt Datei. Diese kannst du unter https://www.deineWebsite.de/robots.txt finden.

Falls hier etwas steht wie: User-agent: Googlebot Disallow: /

oder: User-agent: * Disallow: /

dann bedeutet dass, dass der Googlebot deine Website nicht crawlen kann.

Ebenso kann deine Seite privat gehalten und nicht indexiert werden, wenn du ein meta tag hinzufügst:

<meta name="robots" content="noindex">

Statt "robots" kann auch "googlebot" benutzt werden. Durch "noindex" wird die Seite nicht indexiert.

Für den Wunsch eine Seite bei Google nicht zu crawlen bzw. zu indexieren, kann es gute Gründe geben.

Vielleicht arbeitest du an einer Seite, die noch nicht so weit ist, dass du sie der Öffentlichkeit präsentieren willst. Um den Zugriff zu verhindern, solltest du ihn auch für die Suchmaschinen blockieren.

Es geschieht jedoch leicht, dass man versehentlich andere Seiten gleich mit blockiert. Ein kleiner Fehler im Code kann ganze Abschnitte der Website unzugänglich machen. Also aufgepasst!

Wie verbessere ich Crawlbarkeit und Indexierbarkeit meiner Website?

Oben sind bereits einige der Faktoren aufgelistet, die zu Problemen mit der Crawlbarkeit oder Indexierbarkeit auf deiner Website führen können. Im ersten Schritt solltest du sicherstellen, dass keines dieser Probleme bei dir gegeben ist und sich deine Webseite entsprechend crawlen lässt.

Darüber hinaus kannst du folgende Maßnahmen ergreifen, um sicherzustellen, dass Webcrawler problemlos auf deine Seiten zugreifen und sie indexieren können.

1. Reiche eine Sitemap bei Google ein

Eine XML-Sitemap ist eine kleine Datei, die sich im Stammverzeichnis deiner Domain befindet und direkte Links zu jeder Seite deiner Website enthält. Diese Datei kannst du per Google Search Console direkt bei der Suchmaschine einreichen.

Die Sitemap informiert Google über deine Inhalte und macht die Suchmaschine auch auf Aktualisierungen aufmerksam, die du daran vorgenommen hast, um auch zukünftig die Indexierung und das Crawling zu beschleunigen.

2. Stärke die interne Verlinkung

Ich habe schon erwähnt, wie sich die interne Verlinkung auf die Crawlbarkeit auswirkt. Stelle also sicher, dass der gesamte Inhalt deiner Website gut miteinander verknüpft ist, damit der Google-Crawler alle Inhalte findet. Eventuell kann es auch sinnvoll sein, von einer stärkeren Seite der Website intern zu verlinken, um die bisher noch nicht indexierte Seite wertvoller zu machen.

3. Aktualisiere deinen Content regelmäßig

Content ist der wichtigste Bestandteil deiner Website. Über deinen Content erhältst du Besucher, kannst ihnen dein Unternehmen vorstellen und sie als Kunden gewinnen.

Aber mit Content kannst du auch die Crawlbarkeit deiner Website verbessern. Websites, deren Inhalte kontinuierlich aktualisiert werden, erhalten häufiger Besuch von Crawlern. Sie werden also schneller gecrawlt und in den Index aufgenommen.

4. Vermeide doppelte Inhalte

Seiten mit demselben oder sehr ähnlichem Inhalt können zu Rankingverlusten führen.

Doppelte Inhalte können aber auch die Häufigkeit verringern, mit der Crawler deine Website besuchen.

Überprüfe und behebe daher alle Probleme mit doppelten Inhalten auf deiner Website, um Crawling und Indexierung möglich zu machen.

5. Beschleunige die Ladezeit deiner Webseite

Webcrawler haben meist nur eine begrenzte Zeit für das Crawlen und Indexieren einer Website zur Verfügung. Dies wird als Crawl-Budget bezeichnet. Wenn es aufgebraucht ist, verabschieden sie sich und hören mit der Erfassung auf.

Je schneller deine Seiten geladen werden, desto mehr von deinen Inhalten kann ein Crawler besuchen, bevor die Zeit knapp wird.

Tools zur Verwaltung der Crawlbarkeit und Indexierung

Wenn all das anspruchsvoll klingt, keine Sorge. Es gibt Tools, die dir bei der Behebung von Problemen mit der Crawlbarkeit und der Aufnahme der URL in den Index tatkräftig helfen.

Log File Analyzer

Der Log File Analyzer zeigt dir, wie Googlebots für Desktop und Mobile deine Website crawlen, ob dabei Fehler auftreten, die du beheben musst, und ob du Crawl-Budget sparen kannst. Du musst nur die Datei access.log deiner Website hochladen und das Tool seine Arbeit erledigen lassen.

Diese Datei ist ein Zugriffsprotokoll, also eine Liste aller Anfragen, die Personen oder Bots an deine Website gesendet haben. Durch die Analyse einer Protokolldatei kannst du das Verhalten von Crawl-Bots verfolgen und besser verstehen.

Hier findest du unsere Anleitung für den Zugriff auf deine Protokolldatei.

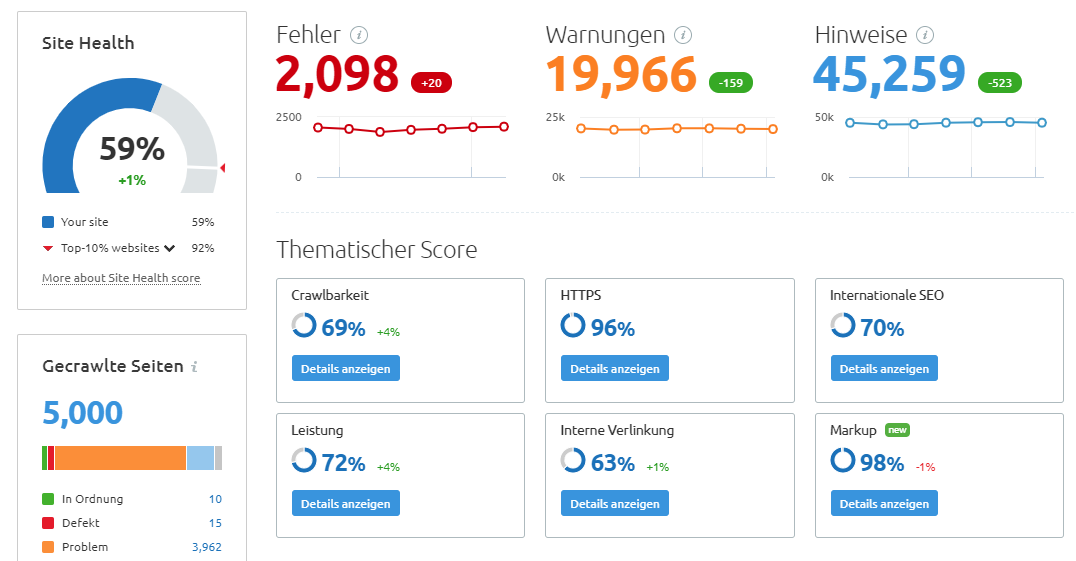

Site Audit

Site Audit ist ein Tool aus der SEMrush-Suite, das die technical SEO deiner Website überprüft. Es scannt auf ein breites Spektrum von Fehlern und Problemen hin, einschließlich solcher, die sich auf die Crawlbarkeit und Indexierbarkeit einer Website auswirken.

Google-Tools

Mit der Google Search Console kannst du deine Website in Google überwachen und pflegen, deine Sitemap einreichen und die Abdeckung deiner Website durch die Webcrawler anzeigen. Hier kannst du auch die Indexierung deiner Domain prüfen und beantragen, um bei Suchanfragen von Nutzern gefunden zu werden. Die Indexierung kann allerdings von ein paar Tagen bis zu einigen Wochen dauern, deshalb ist hierbei etwas Geduld gefragt.

Google PageSpeed Insights überprüft die Ladezeit deiner Website und generiert einen Bericht mit vielen Detailinformationen. In unserem Blogartikel findest du Tipps, um deinen PageSpeed Insights Score zu verbessern.

Fazit

Die meisten Webmaster wissen, dass sie hochwertigen und relevanten Content und Backlinks brauchen, um ein vertrauenswürdiges Bild abzugeben und bei Google Sichtbarkeit zu erhalten.

Viele beachten jedoch nicht, dass alle Bemühungen nicht fruchten, wenn Crawler ihre Website nicht auslesen und indexieren können.

Beschränke dich daher nicht darauf, optimierte Seiten für relevante Keywords zu erstellen und Links aufzubauen, sondern achte auch kontinuierlich darauf, dass Webcrawler auf deine gesamte Website zugreifen und der Suchmaschine zurückmelden können, was sie gefunden haben.