URL-Parameter und ihre Auswirkung auf die SEO

URL-Parameter sind ein integraler Bestandteil von URL-Strukturen. Während sie in den Händen erfahrener SEO-Experten ein nützliches Werkzeug sind, stellen Query-Strings oft ein Problem für deine Website Rankings dar. Dies sind miteinander verkettete Abfragen, die als Teil einer Webseiten-URL übergeben werden.

In diesem Leitfaden erfährst du, welche SEO-Probleme am häufigsten durch URL-Parameter auftreten, und worauf du achten solltest, um sie zu vermeiden.

Was sind URL-Parameter?

URL-Parameter, auch als Query-Strings oder "URL-Abfrageparameter" bezeichnet, werden in URLs eingefügt, um Website-Inhalte für den Nutzer zu filtern und zu organisieren. Manchmal dienen sie auch zum Tracking des Nutzerverhaltens.

Kurz gefasst sind URL-Parameter eine Möglichkeit, per Klick über die URL Informationen zu übermitteln.

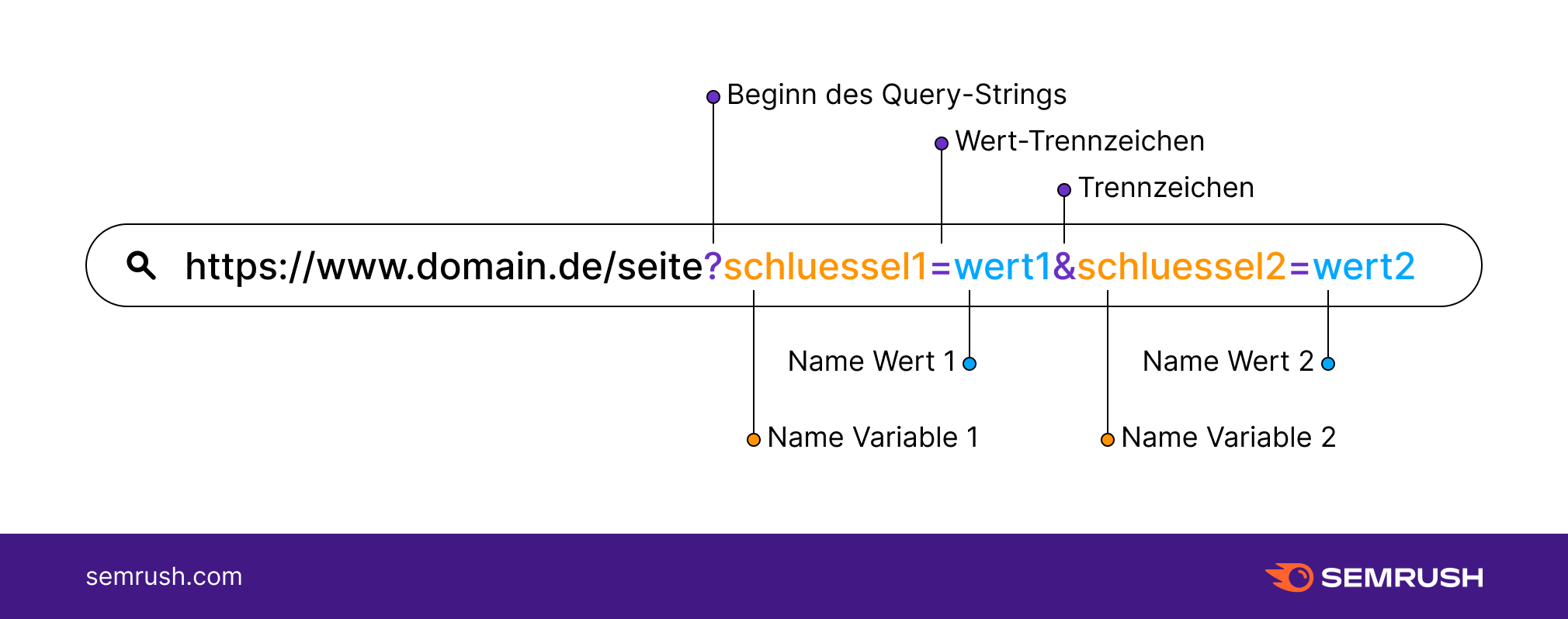

Um einen URL-Parameter zu identifizieren, sieh dir den Teil einer URL an, der hinter einem Fragezeichen (?) steht. URL-Parameter bestehen aus einem Schlüssel und einem Wert, die durch ein Gleichheitszeichen (=) getrennt sind. Mehrere Parameter werden wiederum jeweils durch ein kaufmännisches Und (&) getrennt.

Ein URL-String mit Parametern sieht so aus:

https//www.domain.de/seite?schluessel1=wert1&schluessel2=wert2

Schluessel1: Name der ersten Variable

Schluessel2: Name der zweiten Variable

Wert1: Wert der ersten Variable

Wert2: Wert der zweiten Variable

?: Query-String beginnt

=: Wert-Trennzeichen

&: Parameter-Trennzeichen

So benutzt du URL Parameter - Erklärung und Beispiele

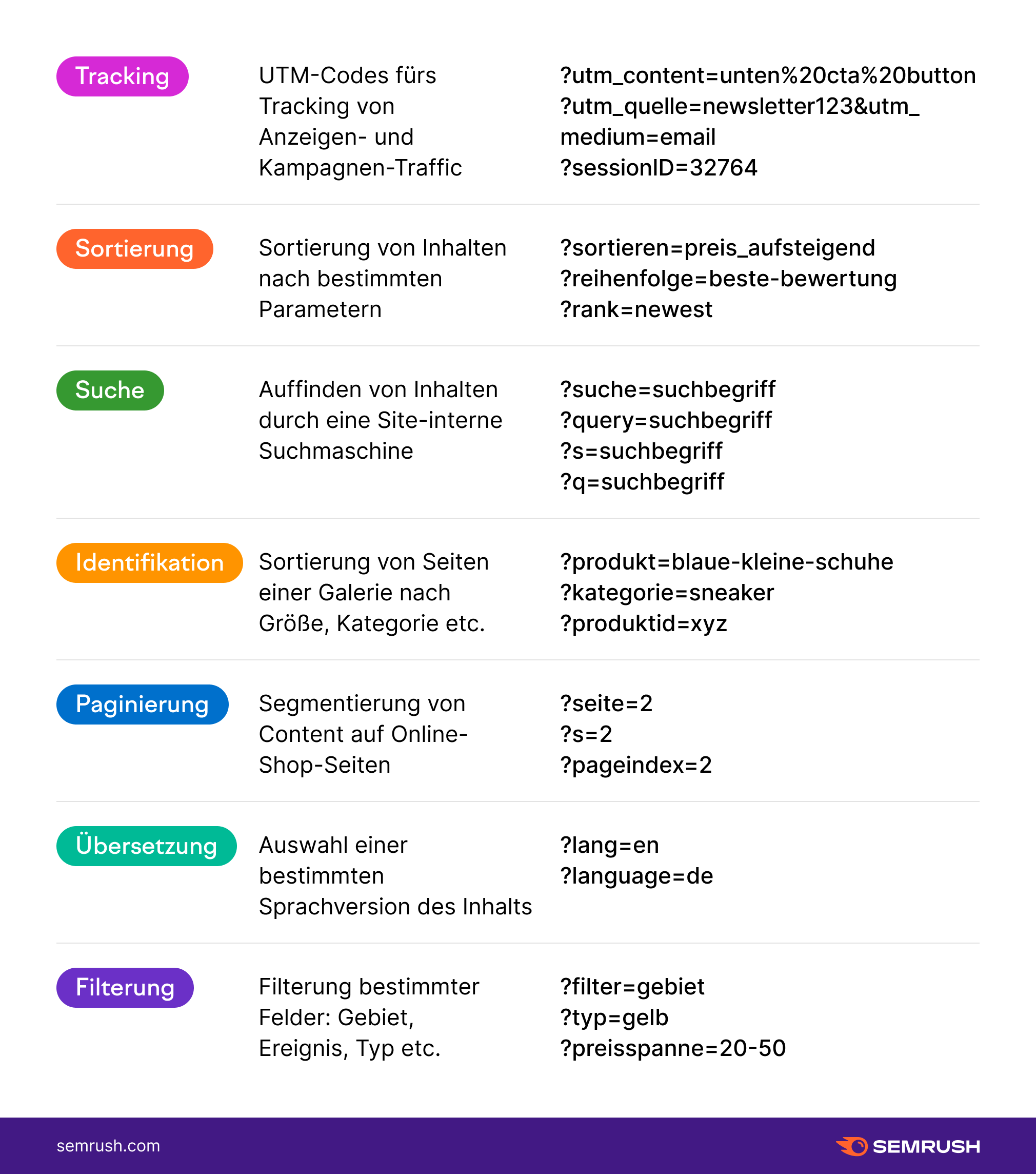

URL-Parameter werden häufig dazu genutzt, den Besuchern eine Sortierung der Produkte in einem Online-Shop zu ermöglichen. Mit Informationsabfragen durch Query-Strings können sie eine Seite mit bestimmten Filtern sortieren oder auch nur eine bestimmte Anzahl von Elementen pro Seite anzeigen.

Tracking-Parameter in Form von Query-Strings sind ebenfalls üblich. Sie werden häufig im digitalen Marketing verwendet, um zu beobachten, woher der Traffic einer Seite kommt. So finden Marketing-Fachleute heraus, ob sich ihre letzte Investition in soziale Netzwerke, Werbekampagnen oder Newsletter gelohnt hat.

Wie funktionieren URL-Parameter?

Laut Google Developers lassen sich zwei Arten von URL-Parametern unterscheiden:

1. Parameter zum Anpassen von Inhalten (aktiv): Parameter, die den auf der Seite angezeigten Inhalt ändern

- z.B. um einen Benutzer direkt zu einem bestimmten Produkt namens "xyz" zu leiten:

https://domain.de?produktid=xyz

2. Tracking-Parameter (passiv) für erweitertes Tracking: Parameter, die Informationen über den Klick weitergeben – etwa aus welchem Netzwerk er stammt, von welcher Kampagne oder Anzeigengruppe usw. –, aber den Inhalt der Seite nicht ändern.

Diese Informationen werden in einem Tracking-Template festgehalten. Es sind wertvolle Daten, um die Wirkung deiner Marketing-Investitionen zu messen.

- z.B. um den Traffic aus deinem Newsletter zu verfolgen:

https://www.domain.de/?utm_source=newsletter&utm_medium=email

- z.B. um mit benutzerdefinierten URLs Kampagnendaten zu sammeln:

https://www.domain.de/?utm_source=twitter&utm_medium=tweet&utm_campaign=sommeraktion

Es sieht einfach aus, aber es gibt eine richtige und eine falsche Methode, URL-Parameter zu benutzen. Sehen wir uns einige Beispiele an, bevor wir näher darauf eingehen.

Beispiele für URLs mit Query-Strings

Einige häufige Verwendungen für URL-Parameter sind:

Wann werden URL-Parameter zum SEO-Problem?

Die meisten SEO-Tipps zu URL-Strukturen besagen, nach Möglichkeit einen Bogen um URL-Parameter zu machen. Denn so nützlich sie auch sein mögen, sie bremsen Webcrawler aus, da sie einen guten Teil des Crawl-Budgets verbrauchen. Dabei können das Crawlbarkeit und Indexierbarkeit dadurch negativ beeinträchtigt werden.

Schlecht strukturierte passive URL-Parameter, die den Inhalt der Seite nicht ändern (z.B. Sitzungs-IDs, UTM-Codes und Partner-IDs), können massenhaft URLs mit Inhalten entstehen lassen, die nicht unique sind.

Dies sind die häufigsten SEO-Probleme, die durch URL-Parameter verursacht werden:

1. Doppelte Inhalte: Da Suchmaschinen jede URL als unabhängige Seite behandeln, können mehrere Versionen derselben Seite, die durch einen URL-Parameter generiert wurden, als duplizierter Inhalt erscheinen. Eine mit URL-Parametern neu geordnete Seite ist der Originalseite oft sehr ähnlich. Manche Parameter spielen sogar genau denselben Inhalt aus wie das Original.

2. Verluste im Crawling-Budget: Einfache URL-Strukturen gehören zu den Grundlagen der SEO. Komplexe URLs mit mehreren Parametern lassen viele verschiedene URLs mit identischen oder ähnlichen Inhalten entstehen. Laut Google Developers können Crawler in solchen Fällen entscheiden, keine Bandbreite für die Indexierung des gesamten Seiteninhalts zu verschwenden, die Seite als minderwertig einzustufen und zur nächsten übergehen.

3. Keyword-Kannibalismus: Gefilterte Versionen der ursprünglichen URL zielen auf dieselbe Keyword-Gruppe ab. Dies führt dazu, dass verschiedene Seiten um die gleichen Rankings konkurrieren. Dies kann Crawler zu dem Schluss führen, dass die gefilterten Seiten keinen echten Mehrwert für die Nutzer bieten.

4. Verwässerte Ranking-Signale: Wenn unterschiedliche parametrisierte URLs für denselben Inhalt vorhanden sind, können Links und Social Shares auf jede URL-Version der Seite verweisen. Dies kann Crawler weiter verwirren, für die nicht klar ist, welche der konkurrierenden Seiten für die Suchanfrage ranken soll.

5. Schlechte URL-Lesbarkeit: Im Idealfall sind URLs einfach und verständlich. Eine lange Aneinanderreihung von Codes und Zahlen ist eher ungünstig. Eine parametrisierte URL ist für Nutzer praktisch unlesbar. Bei der Anzeige in den Suchergebnissen, in einem Newsletter oder in sozialen Netzwerken sieht sie spammig und nicht vertrauenswürdig aus. Das senkt die Wahrscheinlichkeit, dass Nutzer auf den Link klicken und die Seite teilen.

Wie du URL-Parameter für gute SEO-Ergebnisse optimierst

Die Mehrzahl der oben genannten SEO-Probleme geht auf eine Hauptursache zurück: das wahllose Crawlen und Indexieren einer Vielzahl von parametrisierten URLs. Aber zum Glück sind Webmaster nicht machtlos gegen die Entstehung unzähliger neuer URLs durch Parameter.

SEO-Probleme treten auf, wenn URLs mit Parametern doppelte, nicht einzigartige Inhalte anzeigen, d.h. solche, die durch passive URL-Parameter generiert werden. Diese Links – und nur diese – sollten nicht indexiert werden.

Achte auf dein Crawl-Budget

Dein Crawl-Budget ist die Anzahl der Seiten, die Bots auf deiner Website crawlen, bevor sie zur nächsten weiterziehen. Jede Website hat ein anderes Crawl-Budget, und es empfiehlt sich darauf zu achten, dass deines nicht verschwendet wird.

Genau das geschieht aber, wenn deine Website viele crawlbare URLs mit geringem Wert aufweist – z.B. parametrisierte URLs, wie sie durch eine Facetten-Navigation entstehen.

Konsistente interne Verlinkung

Wenn deine Website viele parameterbasierte URLs verwendet, gilt es den Crawlern zu signalisieren, welche Seiten nicht indexiert werden sollen, und konsequent auf die statische, nicht parametrisierte Seite zu verlinken.

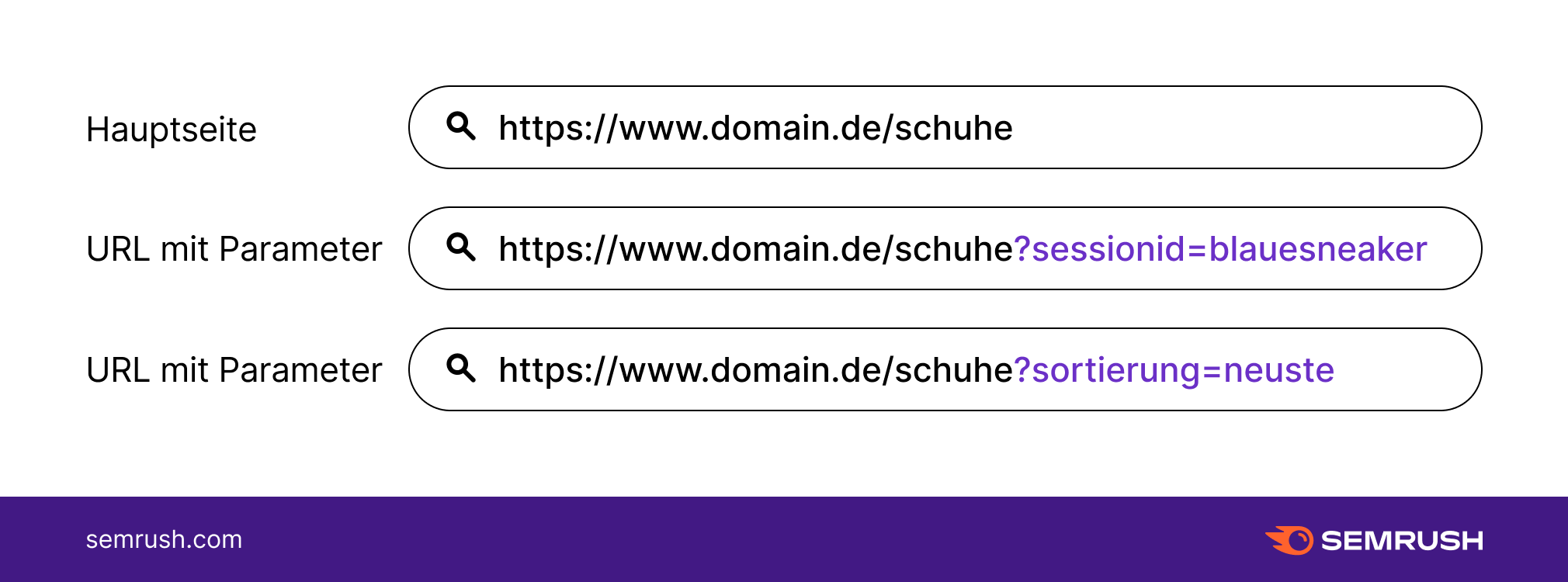

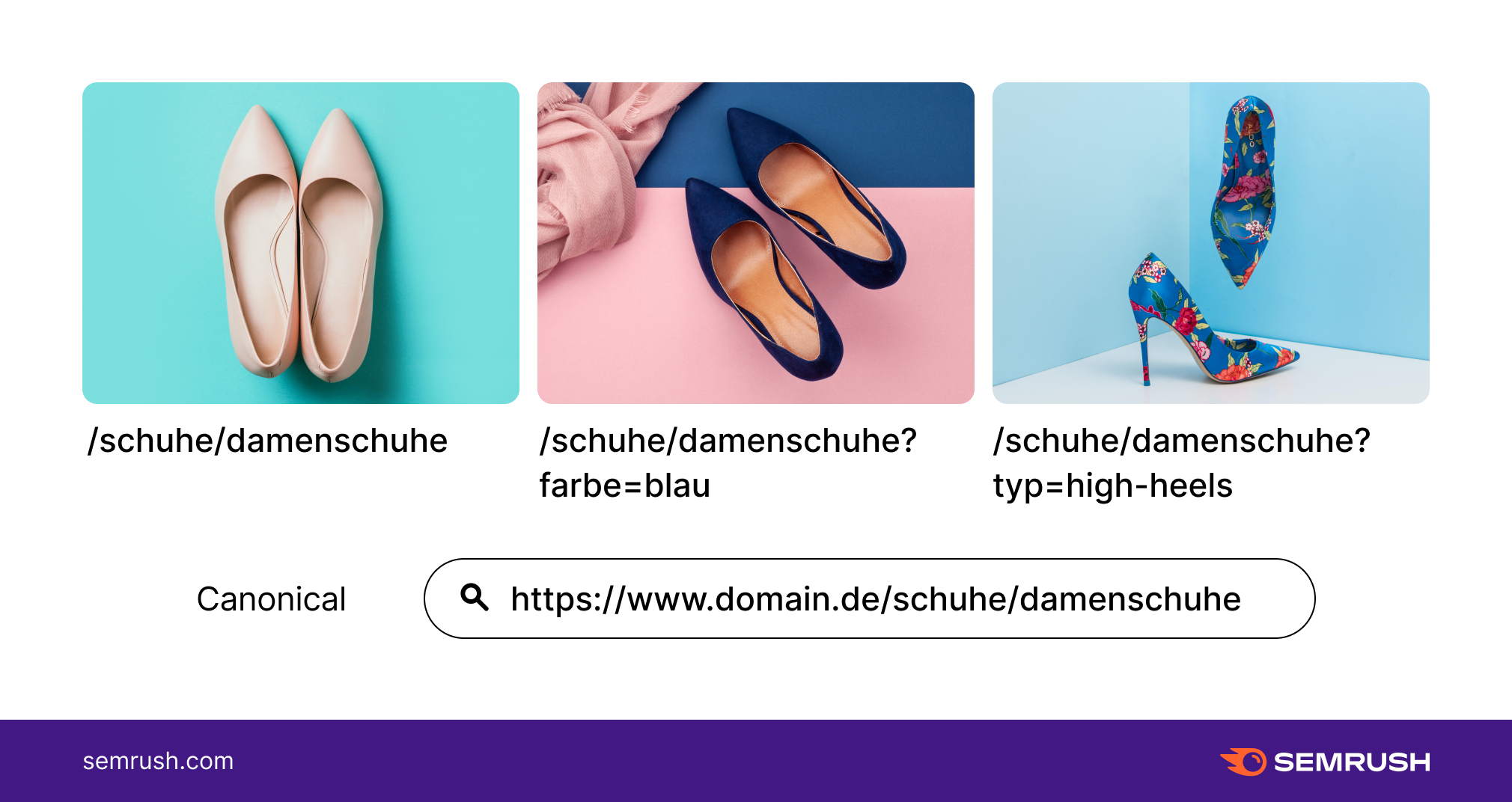

Hier sind beispielsweise einige parametrisierte URLs aus einem Online-Schuhgeschäft im Vergleich zur statischen Version:

Achte in solchen Fällen darauf, konsequent nur auf die statische Seite zu verlinken und niemals auf die Versionen mit Parametern. So vermeidest du widersprüchliche Signale an Suchmaschinen, welche Version der Seite indexiert werden soll.

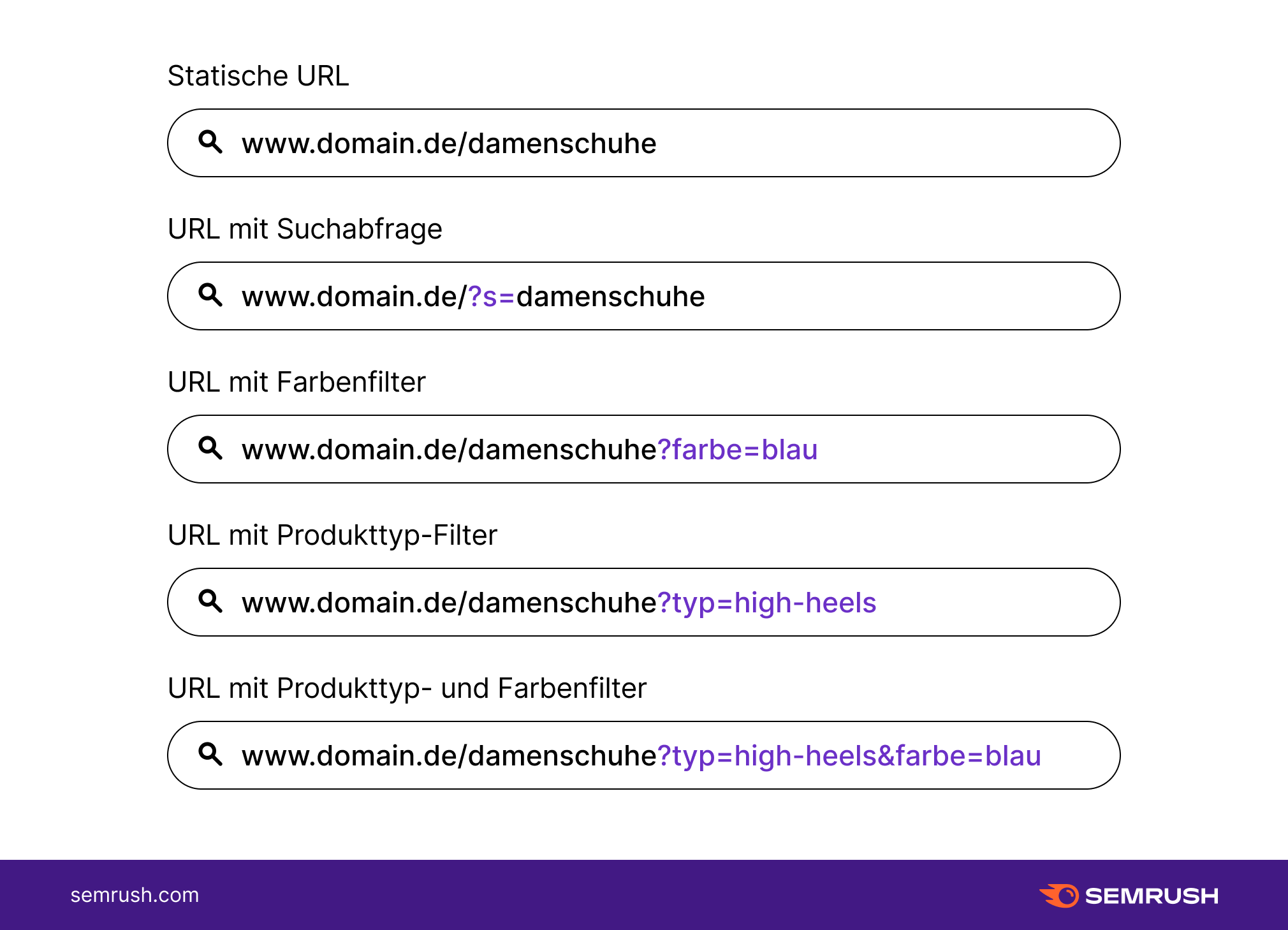

Eine Version der URL kanonisieren

Wenn du dich entschieden hast, welche statische Seite indexiert werden soll, denke auch daran, sie zu kanonisieren. Richte Canonical-Tags für die parametrisierten URLs ein, die auf die bevorzugte URL verweisen.

Wenn du zum Beispiel Parameter nutzt, die Besuchern die Navigation in deinem Online-Shop für Schuhe erleichtern, sollten alle URL-Variationen das Canonical-Tag enthalten, das die Haupt-Landing-Page als kanonische Seite kennzeichnet. Also zum Beispiel:

- /schuhe/damenschuhe/

- /schuhe/damenschuhe?farbe=blau

- /schuhe/damenschuhe?typ=high-heels

In diesem Fall verweisen die drei obigen URLs auf die nicht parametrisierte Landing-Page für Damenschuhe zurück. Dadurch wird den Crawlern signalisiert, dass nur die Landing-Page indexiert werden soll und nicht die parametrisierten URLs.

Crawler über Disallow blockieren

URL-Parameter für Sortierung und Filterung können unzählige URLs mit nicht einzigartigem Inhalt entstehen lassen. Mit der Anweisung "disallow" kannst du Crawler daran hindern, auf diese Teile deiner Website zuzugreifen.

Um Crawler wie den Googlebot von deinem parametrisierten Duplicate Content fernzuhalten, kannst du mit deiner Robots.txt-Datei kontrollieren, worauf sie auf deiner Website zugreifen können. Die Bots lesen diese Datei vor dem Crawlen einer Website und befolgen die darin enthaltenen Anweisungen (im Wesentlichen). Dies ist eine gute Möglichkeit, deine Website mit parametrisierten URLs suchmaschinenfreundlich zu optimieren.

Folgender Eintrag in deiner Robots.txt-Datei schließt alle URLs von der Indexierung aus, die ein Fragezeichen enthalten:

Disallow:/*?*

Dieses Disallow-Tag verhindert das Crawling aller Seiten mit URL-Parametern durch Suchmaschinen. Wenn du es nutzen willst, stelle sicher, dass kein anderer Teil deiner URL-Struktur Parameter verwendet, da diese sonst ebenfalls blockiert werden.

Vielleicht musst du selbst einen Crawl durchführen, um alle URLs zu finden, die ein Fragezeichen (?) enthalten.

URL-Parameter als statische URLs umschreiben

Dies berührt die breitere Diskussion über dynamische versus statische URLs. Das Umschreiben dynamischer Seiten in statische verbessert die URL-Struktur deiner Website.

Nimm dir dabei auch die Zeit, die Seiten an ihre entsprechenden neuen statischen Adressen weiterzuleiten – insbesondere, wenn die parametrisierten URLs bereits indexiert sind.

Google Developers empfiehlt außerdem:

- unnötige Parameter zu entfernen, aber dynamisch aussehende URLs beizubehalten,

- statische Inhalte zu erstellen, die dem ursprünglichen dynamischen Inhalt äquivalent sind und

- die Rewrites von dynamisch auf statisch auf diejenigen Fälle zu begrenzen, in denen du dadurch unnötige Parameter entfernen kannst.

Das URL-Parameter-Tool von Semrush nutzen

Der Umgang mit URL-Parametern ist eine komplexe Aufgabe, bei der du vielleicht etwas Hilfe benötigst. Mit dem Semrush Site Audit kannst du dir viel Kopfschmerzen ersparen, indem du frühzeitig alle URL-Parameter identifizierst, die nicht gecrawlt werden sollen.

In den Einstellungen des Site Audits findest du einen speziellen Schritt " URL-Parameter entfernen". Hier kannst du alle Parameter-URLs auflisten, die während eines Crawls ignoriert werden sollen (UTMs, Seite, Sprache usw.).

Dies ist nützlich, da nicht alle parametrisierten URLs gecrawlt und indexiert, aber auch nicht alle ausgeschlossen werden müssen. Parameter, die sich auf Inhalte auswirken, verursachen meist keine SEO-Probleme, sodass ihre Indexierung einen Mehrwert für deine Website darstellt.

Wenn du bereits ein Projekt in Semrush eingerichtet hast, kannst du deine Einstellungen für URL-Parameter jederzeit ändern, indem du auf das Zahnradsymbol klickst.

URL-Parameter in deiner SEO-Strategie berücksichtigen

Parametrisierte URLs erleichtern es, Inhalte zu filtern oder Besucher zu tracken. Daher können sie sehr hilfreich sein. Um SEO-Probleme bei ihrer Nutzung zu vermeiden, lasse Webcrawler wissen, wann URLs mit Parametern indexiert werden sollen und wann nicht, und gib ihnen ein klares Signal, welche Version jeder Seite am wertvollsten ist.

Nimm dir die Zeit, um in Ruhe zu entscheiden, welche parametrisierten URLs indexiert werden sollen. Wenn du die Tipps in diesem Leitfaden umsetzt, können Crawler mit der Zeit immer besser auf deiner Website navigieren und den Wert der einzelnen Seiten einschätzen.