Wenn Sie Ihre Website mit Site Audit prüfen, senden wir einen Crawler dorthin, um die Seiten zu untersuchen, die Sie in der Konfiguration des Tools angegeben haben.

Beim Crawlen können jedoch Probleme auftreten, zum Beispiel:

- Der Crawler crawlt die Website zu schnell und bringt sie dadurch vorübergehend zum Absturz oder macht sie für die Nutzer langsamer.

- Der Crawler crawlt die Website zu schnell und die Seiten werden nicht korrekt geladen. Dann zeigt Semrush „falsche positive“ Ergebnisse an oder meldet Probleme in den Ergebnissen Ihre Audits, die nicht aufgetreten wären, wenn der Audit langsamer crawlen würde und die Website nicht abgestürzt wäre.

- Der Crawler benötigt zu lange, um die Website zu crawlen, und Sie warten zu lange auf Ihre Ergebnisse.

Site Audit beschleunigen

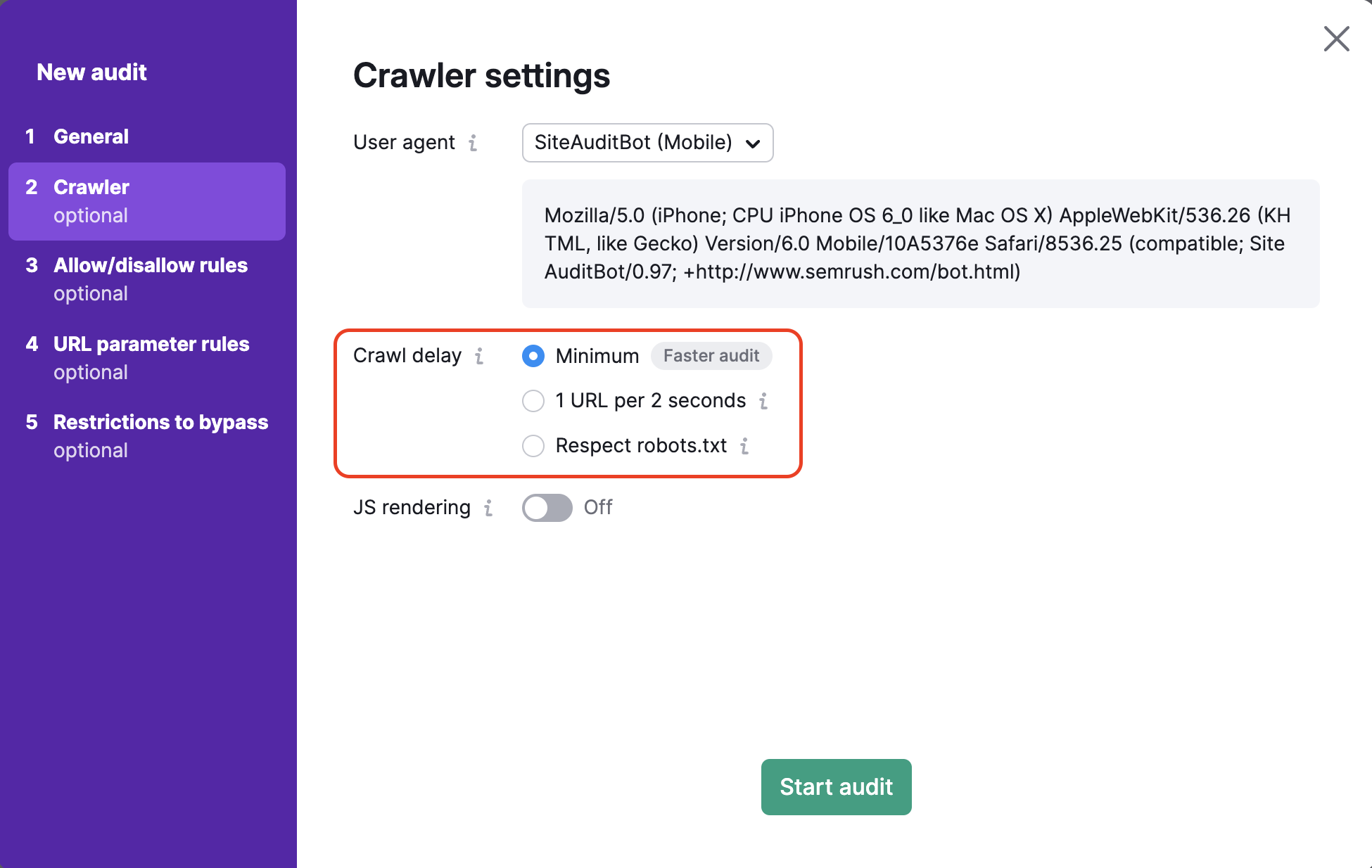

Wenn Ihr Site Audit zu langsam crawlt, können Sie die Geschwindigkeit im Schritt Crawler-Einstellungen im Konfigurationsfenster erhöhen.

Um Ihr Site Audit zu beschleunigen, wählen Sie „Minimal“ aus. Dann wird die Website so schnell wie möglich gecrawlt.

Diese Aktion sorgt dafür, dass unser Bot jegliche Anweisungen zum Crawl-delay in der robots.txt der Website ignoriert und mit der schnellstmöglichen Geschwindigkeit crawlt.

Wenn Sie mit der Geschwindigkeit Ihres Crawls immer noch nicht zufrieden sind, können Sie in einem weiteren Schritt dafür sorgen, dass Ihre Seiten schneller geladen werden. Wenn Seiten langsam laden, verlangsamt sich auch das Crawling.

Beachten Sie: Wenn ein Bot Ihre Website mit sehr hoher Geschwindigkeit crawlt, kann dies dazu führen, dass Nutzer auf der Website langsamere Ladezeiten erleben.

In bestimmten Fällen wäre es also ratsam, Ihr Crawling eher zu verlangsamen, anstatt es zu beschleunigen.

Site Audit langsamer machen

Wenn Ihr Site Audit zu schnell crawlt, kann eine Website vorübergehend zum Absturz gebracht oder für die Nutzer langsamer werden, sodass falsch positive Ergebnisse entstehen. Verlangsamen Sie die Crawl-Geschwindigkeit, um sicherzustellen, dass Ihre Ergebnisse die Nutzererfahrung auf der Website repräsentieren.

Um Ihr Audit zu verlangsamen, haben Sie in Ihren Konfigurationseinstellungen mehrere Optionen:

- Sagen Sie Semrush, dass es 1 URL pro 2 Sekunden crawlen soll. Dies stellt sicher, dass das Crawling den Server Ihrer Website nicht mit zu vielen Aktivitäten in kurzer Zeit überfordert.

- Legen Sie eine benutzerdefinierte Crawl-Verzögerung in der robots.txt Datei Ihrer Website fest. Wenn Sie die Option „robots.txt beachten“ in den Schritten bei der Konfiguration auswählen, wird unser Bot angewiesen, die Seiten nur in der von Ihnen mitgeteilten Geschwindigkeit zu crawlen.

Wenn Sie beispielsweise „Crawl-delay: 5“ zu Ihrer robots.txt-Datei hinzufügen, wird dem Bot gesagt, dass er 5 Sekunden warten soll, bevor er die Website aufruft, um eine weitere Seite anzusehen. Auch dies stellt sicher, dass das Crawling in einem Tempo erfolgt, das die Website nicht abstürzen lässt oder sie verlangsamt (siehe unten).User-agent: SemrushBot Crawl-delay: 5 User-agent: SiteAuditBot Crawl-delay: 5

Bitte beachten Sie: Die maximale Crawl-Verzögerung, die wir anwenden können, beträgt 30. Alles darüber hinaus wird von unserem Bot als 30 interpretiert.

Falls Sie weiterhin Probleme beim Ausführen Ihres Site Audit haben, probieren Sie es mit unserem Leitfaden zur Fehlerbehebung oder kontaktieren Sie unser Support-Team.