Läuft Ihr Site Audit nicht richtig?

Es gibt eine Reihe von Gründen, warum Webseiten aufgrund ihrer Konfiguration und Struktur für den Site Audit Crawler blockiert sein können:

- Robots.txt blockiert Crawler

- Crawl-Bereich, der bestimmte Bereiche der Website ausschließt

- Die Website ist aufgrund des gemeinsamen Hostings nicht direkt online

- Die Größe der Landing-Page überschreitet 2 MB

- Die Seiten befinden sich hinter einem Gateway / Nutzerbereich der Website

- Crawler durch noindex-Tag blockiert

- Domain konnte nicht vom DNS aufgelöst werden – die bei der Einrichtung angegebene Domain ist offline

- Website-Inhalte, die auf JavaScript basieren – obwohl Site Audit JS-Code rendern kann, kann er dennoch die Ursache einiger Probleme sein

Schritte zur Fehlerbehebung

Befolgen Sie diese Schritte zur Fehlerbehebung, um herauszufinden, ob Sie selbst Anpassungen vornehmen können, bevor Sie sich an unser Support-Team wenden, um Hilfe zu erhalten.

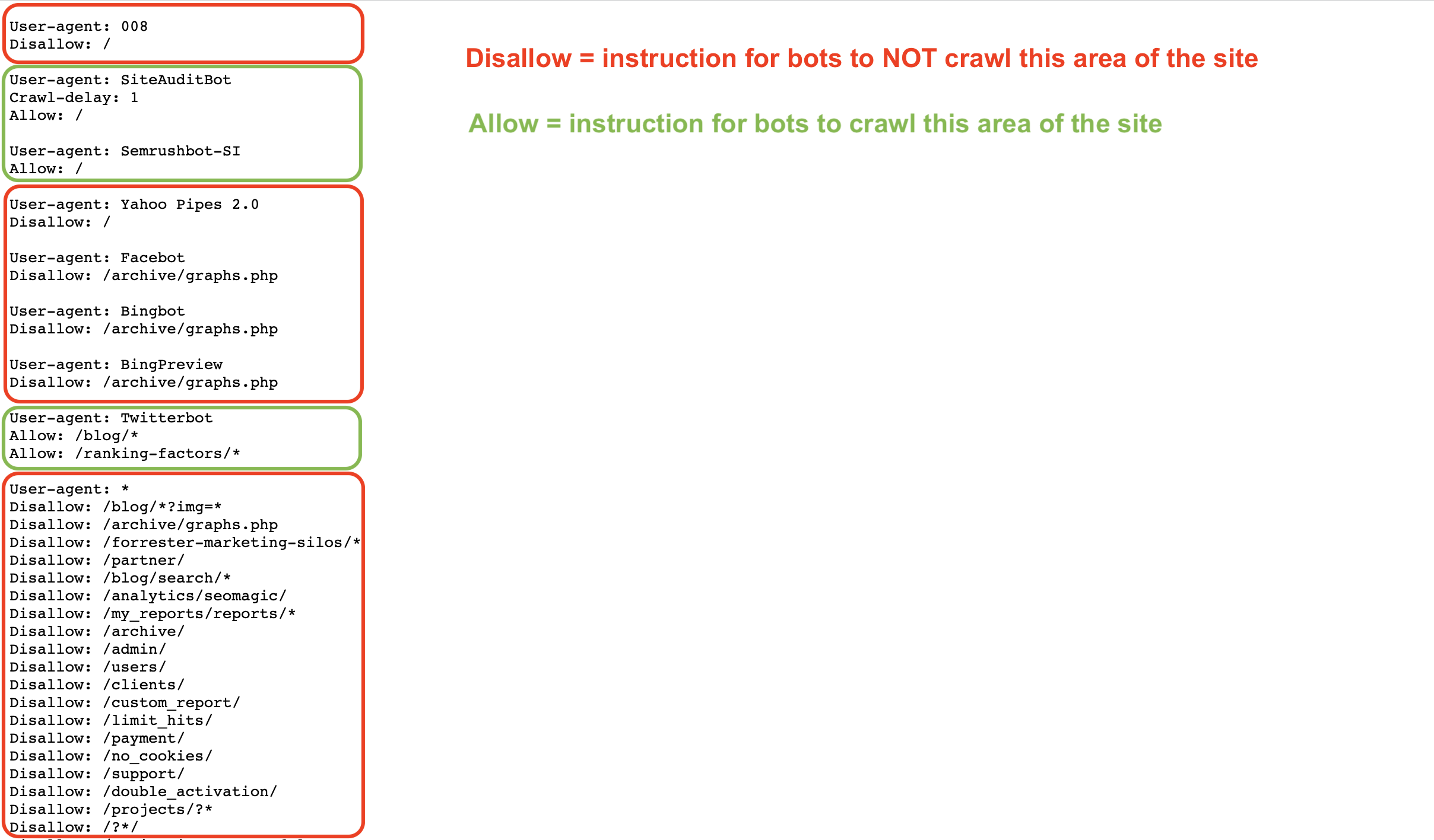

Die Datei Robots.txt gibt den Bots Anweisungen, wie sie die Seiten einer Website crawlen (oder nicht crawlen) sollen. Sie können Bots wie Googlebot oder Semrushbot erlauben und verbieten, Ihre gesamte Website oder bestimmte Bereiche zu crawlen, indem Sie Befehle wie Allow, Disallow, und Crawl Delay verwenden.

Wenn Ihre robots.txt unseren Bot daran hindert, Ihre Website zu crawlen, kann unser Site Audit Tool Ihre Website nicht überprüfen.

Sie können Ihre Robots.txt auf Disallow-Befehle überprüfen, die es Crawlern wie unseren unmöglich machen würden, auf Ihre Website zuzugreifen.

Um dem Semrush Site Audit-Bot (SiteAuditBot) zu erlauben, Ihre Website zu crawlen, fügen Sie Folgendes zu Ihrer robots.txt-Datei hinzu:

User Agent: SiteAuditBot

Disallow:

(machen Sie nach „Disallow:” ein Leerzeichen)

Hier ist ein Beispiel, wie eine robots.txt-Datei aussehen kann:

Beachten Sie die verschiedenen Befehle je nach User Agent (Crawler), an den die Datei gerichtet ist.

Diese Dateien sind öffentlich und müssen, um gefunden zu werden, auf der obersten Ebene einer Website gehostet werden. Um die robots.txt-Datei einer Website zu finden, geben Sie die Root-Domain einer Website gefolgt von /robots.txt in Ihren Browser ein. Die robots.txt-Datei auf Semrush.com befindet sich zum Beispiel unter https://semrush.com/robots.txt.

Einige Begriffe, die Sie in einer robots.txt-Datei sehen können, sind:

- User-Agent = der Web-Crawler, dem Sie Anweisungen geben.

- Beispiel: SiteAuditBot, Googlebot

- Allow = ein Befehl (nur für Googlebot), der dem Bot mitteilt, dass er eine bestimmte Seite oder einen bestimmten Bereich einer Website crawlen kann, auch wenn die übergeordnete Seite oder der übergeordnete Ordner nicht erlaubt ist.

- Disallow = ein Befehl, der den Bot anweist, eine bestimmte URL oder einen Unterordner einer Website nicht zu crawlen.

- Beispiel: Disallow: /admin/

- Crawl Delay = ein Befehl, der den Bots sagt, wie viele Sekunden sie warten sollen, bevor sie eine andere Seite laden und crawlen.

- Sitemap = gibt an, wo sich die sitemap.xml-Datei für eine bestimmte URL befindet.

- / = Verwenden Sie das "/"-Symbol nach einem Disallow-Befehl, um dem Bot mitzuteilen, dass er nicht die gesamte Website crawlen soll

- * = ein Platzhalter-Symbol, das eine beliebige Folge möglicher Zeichen in einer URL darstellt und verwendet wird, um einen Bereich einer Website oder alle User Agents anzugeben.

- Beispiel: Disallow: /blog/* zeigt alle URLs im Blog-Unterordner einer Website an

- Beispiel: User Agent: * zeigt Anweisungen für alle Bots an

Lesen Sie mehr über die Robots.txt-Anforderungen von Google oder auf dem Semrush Blog.

Wenn Sie den folgenden Code auf der Hauptseite einer Website sehen, bedeutet dies, dass wir die Links nicht indexieren bzw. ihnen nicht folgen dürfen und dass unser Zugriff blockiert ist.

<meta name="robots" content="noindex, nofollow" >

Oder Seite enthält mindestens eine der folgenden Angaben: „noindex", „nofollow", „none". Dies führt zu einem Fehler beim Crawling.

Damit unser Bot eine solche Seite crawlen kann, entfernen Sie diese „noindex"-Tags aus dem Code Ihrer Seite. Weitere Informationen zum noindex-Tag findest du in diesem Google Hilfe-Artikel.

Um den Bot auf die Whitelist zu setzen, wenden Sie sich an Ihren Webmaster oder Hosting-Provider und bitten Sie ihn, SiteAuditBot auf die Whitelist zu setzen.

Die IP-Adressen des Bots sind: 85.208.98.128/25 (ein Subnetz, das nur von Site Audit verwendet wird)

Der Bot verwendet die Standard-Ports 80 HTTP und 443 HTTPS für die Verbindung.

Wenn Sie Plugins (z.B. Wordpress) oder CDNs (Content Delivery Networks) zur Verwaltung Ihrer Website verwenden, müssen Sie die Bot-IP auch in diesen auf die Whitelist setzen.

Für das Whitelisting bei Wordpress wenden Sie sich bitte an Wordpress Support.

Zu den gängigen CDNs, die unseren Crawler blockieren, gehören:

- Cloudflare - Hier erfahren Sie, wie Sie eine Whitelist erstellen

- Imperva - Hier erfahren Sie, wie Sie eine Whitelist erstellen

- ModSecurity - Hier erfahren Sie, wie Sie eine Whitelist erstellen

- Sucuri - Hier erfahren Sie, wie Sie eine Whitelist erstellen

Bitte beachten Sie: Wenn Sie Shared Hosting nutzen, kann es sein, dass Ihr Hostinganbieter Ihnen nicht erlaubt, Bots auf die Whitelist zu setzen oder die Datei Robots.txt zu bearbeiten.

Hosting-Anbieter

Im Folgenden finden Sie eine Liste der beliebtesten Hosting-Anbieter im Internet und erfahren, wie Sie einen Bot auf die Whitelist setzen oder das Support-Team um Hilfe bitten können:

- Siteground - Anweisungen zum Erstellen von Whitelists

- 1&1 IONOS - Anweisungen zum Erstellen von Whitelists

- Bluehost* - Anweisungen zum Erstellen von Whitelists

- Hostgator* - Anweisungen zum Erstellen von Whitelists

- Hostinger - Anweisungen zum Erstellen von Whitelists

- GoDaddy - Anweisungen zum Erstellen von Whitelists

- GreenGeeks - Anweisungen zum Erstellen von Whitelists

- Big Commerce - Sie müssen den Support kontaktieren

- Liquid Web - Sie müssen den Support kontaktieren

- iPage - Sie müssen den Support kontaktieren

- InMotion - Sie müssen den Support kontaktieren

- Glowhost - Sie müssen den Support kontaktieren

- Hosting – Sie müssen den Support kontaktieren

- DreamHost - Sie müssen den Support kontaktieren

* Bitte beachten Sie: Diese Anweisungen gelten für HostGator und Bluehost, wenn Sie eine Website auf VPS oder Dedicated Hosting haben.

Wenn die Größe Ihrer Landing-Page oder die Gesamtlänge der JavaScript/CSS-Dateien 2 MB überschreitet, können unsere Crawler sie aufgrund technischer Einschränkungen des Tools nicht verarbeiten.

Weitere Informationen zu den möglichen Ursachen für die Zunahme der Größe und zur Lösung dieses Problems finden Sie in diesem Artikel auf unserem Blog.

Um zu sehen, wie viel von Ihrem aktuellen Crawl-Budget bereits verbraucht wurde, gehen Sie zu Profil – Paketinfo und suchen Sie unter „SEO Toolkit" nach „Zu crawlende Seiten".

Je nach Ihrer Paketstufe ist die Anzahl der Seiten, die Sie pro Monat crawlen können, begrenzt (monatliches Crawl-Budget). Wenn Sie die Anzahl der in Ihrem Abonnement erlaubten Seiten überschreiten, müssen Sie zusätzliche Limits erwerben oder warten, bis der nächste Monat beginnt, in dem Ihre Limits zurückgesetzt werden.

Wenn Sie während der Einrichtung die Fehlermeldung „Sie haben das Limit für gleichzeitige Kampagnen erreicht“ erhalten, bedeutet dies, dass Sie die maximale Anzahl von Site Audits erreicht haben, die in Ihrem Abonnement gleichzeitig ausgeführt werden dürfen.

Jede Paketstufe hat unterschiedliche Limits:

- Kostenloses Konto: 1 Site Audit gleichzeitig

- SEO Toolkit Pro: Bis zu 2 Site Audits gleichzeitig

- SEO Toolkit Guru: Bis zu 2 Site Audits gleichzeitig

- SEO Toolkit Business: Bis zu 5 Site Audits gleichzeitig

Wenn die Domain nicht über DNS aufgelöst werden konnte, bedeutet dies wahrscheinlich, dass die Domain, die Sie bei der Konfiguration eingegeben haben, offline ist. Häufig haben Benutzer dieses Problem, wenn sie eine Root-Domain (Beispiel.com) eingeben, ohne zu wissen, dass die Root-Domain-Version ihrer Website nicht existiert und stattdessen die WWW-Version ihrer Website eingegeben werden muss (www.example.com).

Um dieses Problem zu vermeiden, könnte der Website-Besitzer eine Weiterleitung von der ungesicherten „beispiel.com" zur gesicherten „www.beispiel.com" einrichten, die auf dem Server existiert. Dieses Problem kann auch andersherum auftreten, wenn die Root-Domain einer Person gesichert ist, die WWW-Version aber nicht. In einem solchen Fall müssten Sie die WWW-Version einfach auf die Root-Domain umleiten.

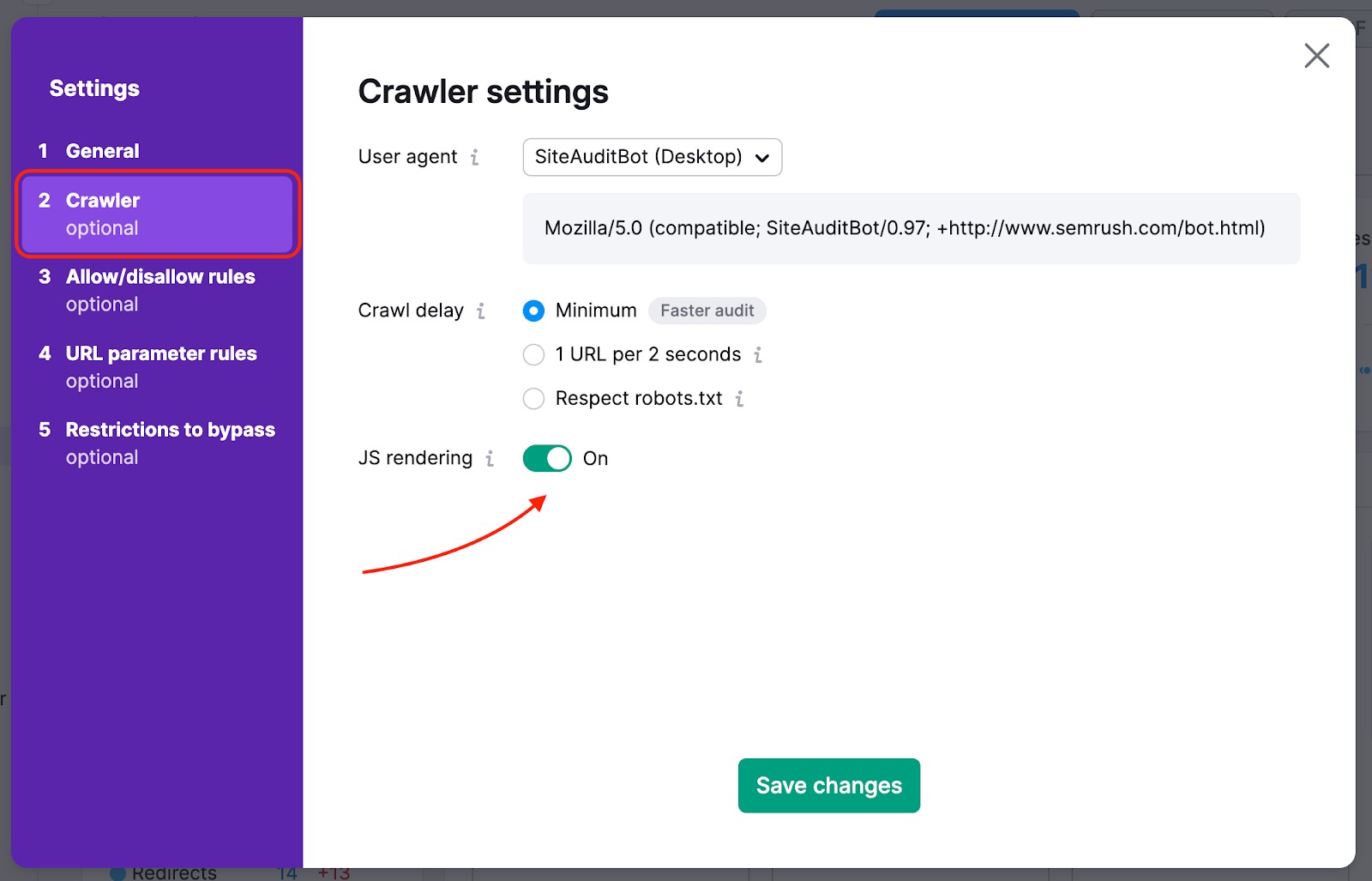

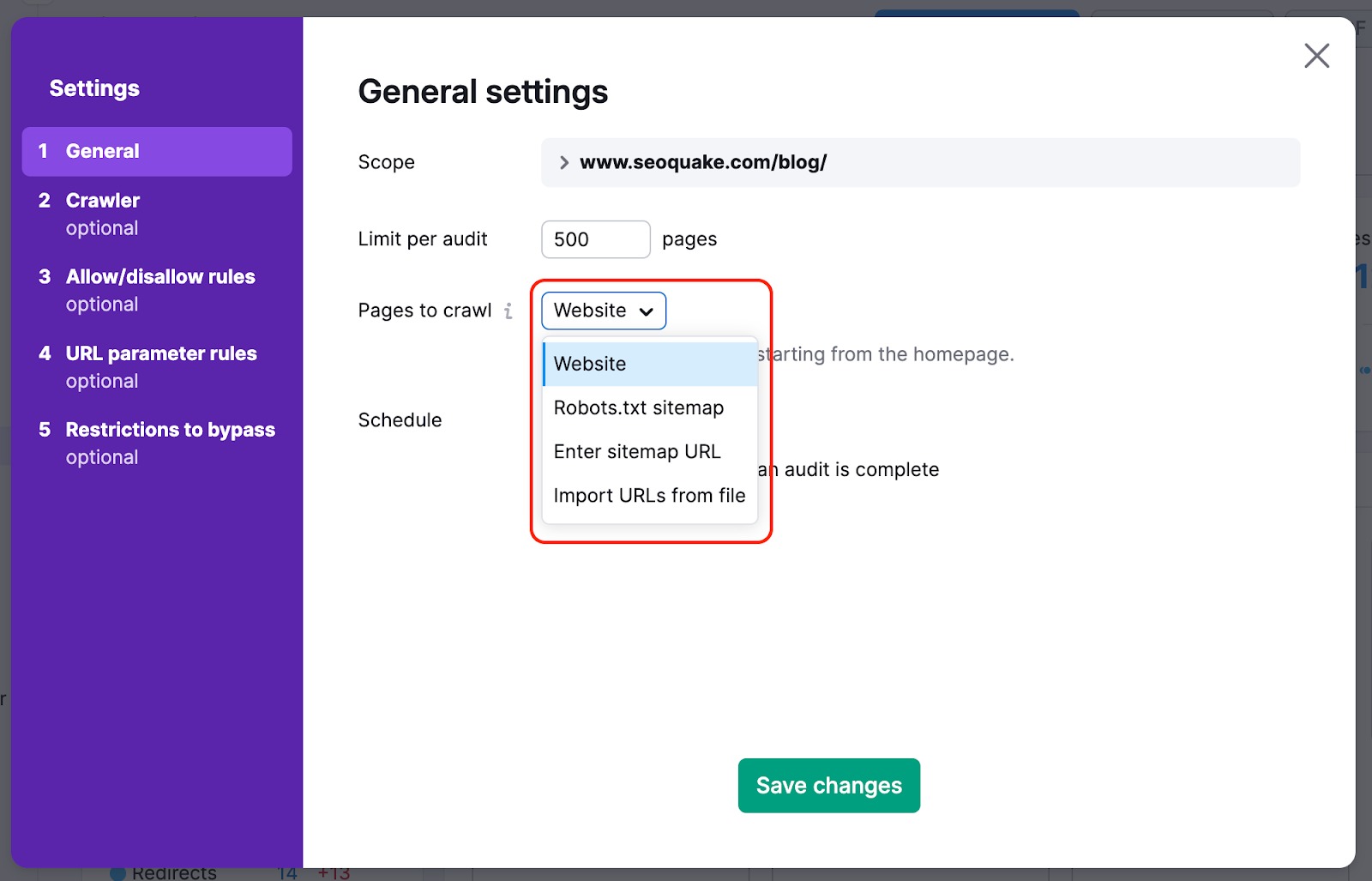

Wenn Ihre Homepage Links zum Rest Ihrer Website enthält, die in JavaScript-Elementen versteckt sind, müssen Sie JS-Rendering aktivieren, damit wir sie lesen und diese Seiten crawlen können. Diese Funktion ist in den Paketstufen Guru oder Business des Abonnements für das SEO Toolkit verfügbar.

Um die wichtigsten Seiten Ihrer Website bei unserem Crawl nicht zu übersehen, können Sie Ihre Crawl-Quelle von Website auf Sitemap ändern – auf diese Weise entgehen den Crawlern bei der Überprüfung keine Seiten, die auf der Website schwierig zu finden sind.

Wir können auch den HTML-Code einer Seite mit einigen JS-Elementen crawlen und die Parameter Ihrer JS- und CSS-Dateien mit unseren Performance-Checks überprüfen.

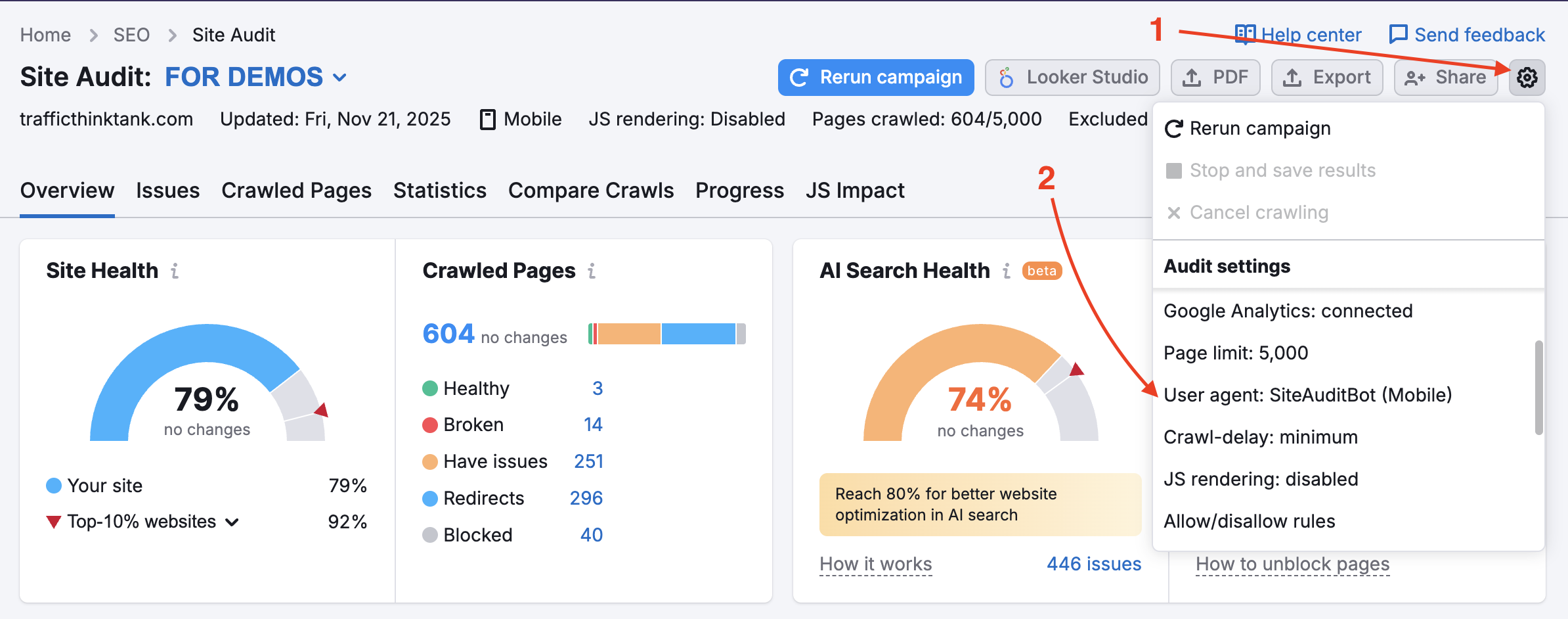

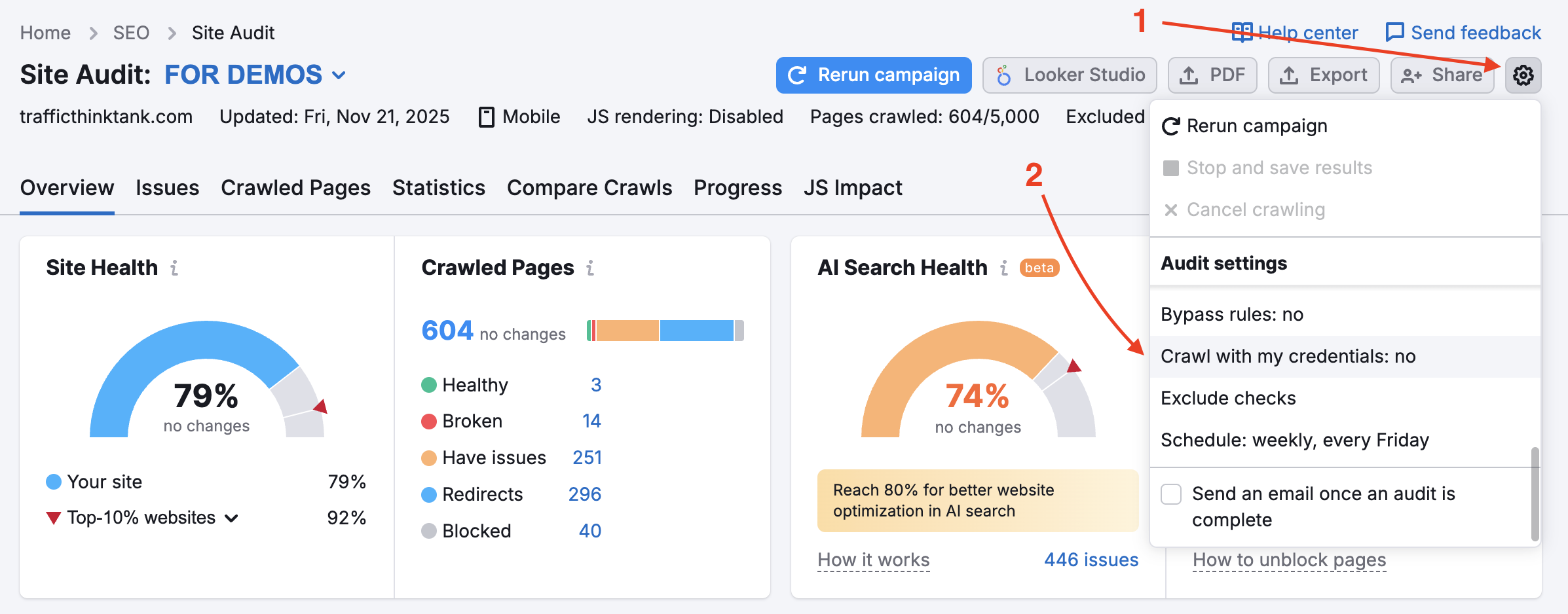

Möglicherweise blockiert Ihre Website den SemrushBot in Ihrer robots.txt-Datei. Sie können den User Agent von SemrushBot auf GoogleBot ändern, und Ihre Website wird wahrscheinlich dem User Agent von Google das Crawlen erlauben. Um diese Änderung vorzunehmen, suchen Sie in Ihrem Projekt das Zahnrad für die Einstellungen und wählen Sie „User Agent".

Wenn diese Option verwendet wird, werden blockierte interne Ressourcen und Seiten, die für Crawl-Checks nicht freigegeben sind, nicht ausgelöst. Beachten Sie bitte, dass die Rechte an der Website überprüft werden müssen, um diese Funktion nutzen zu können.

Dies ist nützlich für Websites, die gerade gewartet werden. Es ist auch hilfreich, wenn der Websitebesitzer die robots.txt-Datei nicht ändern möchte.

Um private Bereiche Ihrer Website, die durch ein Passwort geschützt sind, zu überprüfen, geben Sie Ihre Anmeldedaten in der Option „Crawling mit Ihren Anmeldedaten" unter dem Einstellungsrad ein.

Dies ist sehr empfehlenswert für Websites, die sich noch in der Entwicklung befinden oder die privat und vollständig passwortgeschützt sind.

„Ihre Crawler-Einstellungen haben sich seit Ihrem vorigen Audit geändert. Dies kann sich auf Ihre aktuellen Audit-Ergebnisse und die Anzahl der erkannten Probleme auswirken.“

Diese Benachrichtigung erscheint in Site Audit, nachdem Sie die Einstellungen aktualisiert und die Prüfung erneut durchgeführt haben. Dies ist kein Hinweis auf ein Problem, sondern eher darauf, dass, falls sich die Crawl-Ergebnisse unerwartet verändert haben, dies wahrscheinlich der Grund dafür ist.

Schauen Sie sich unseren Blogbeitrag Häufige SEO-Probleme & wie man sie behebt an.