Warum werden mir funktionierende Seiten als defekt angezeigt?

Es kann von Zeit zu Zeit vorkommen, dass das Site Audit einige deiner internen Seiten als defekt meldet, obwohl diese vollständig funktionieren. Das kommt nicht oft vor, aber es führt zu Verwirrungen einiger Benutzer.

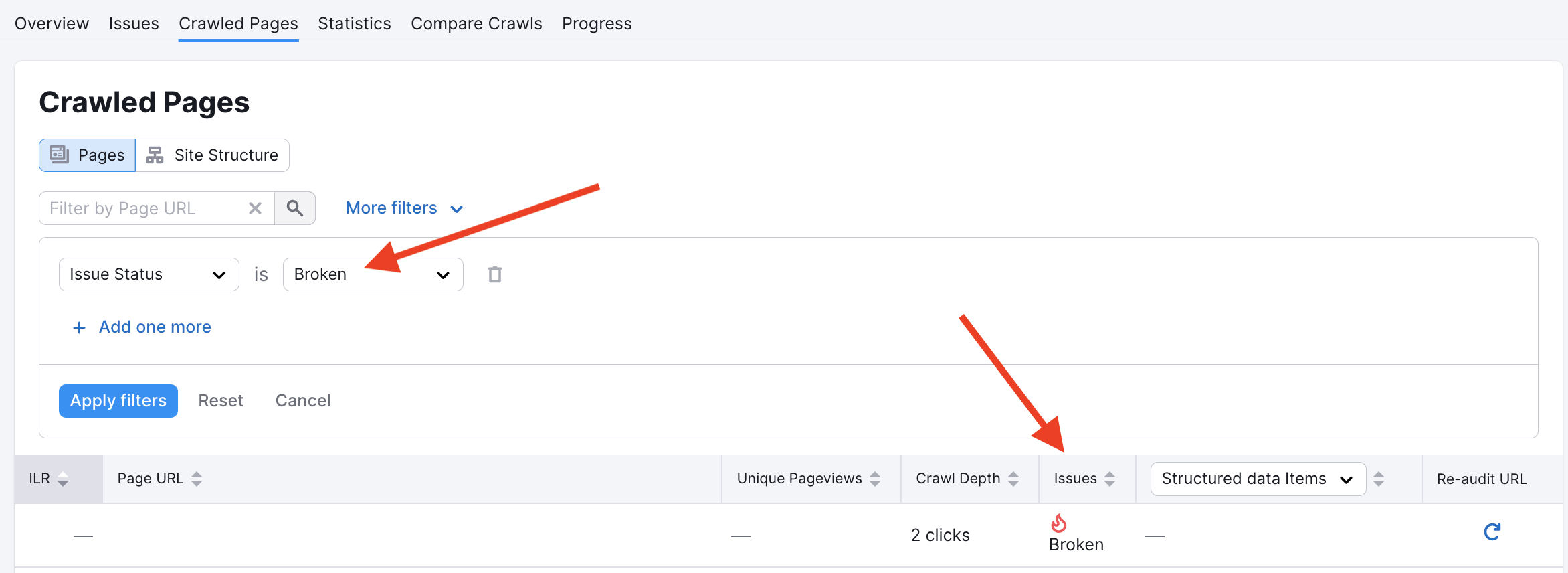

Grundsätzlich liegt es an einem falsch-positiven Ergebnis. Die drei häufigsten Gründe für ein falsch-positives Ergebnis sind:

- Unser Crawler könnte für einige Seiten in der Datei robots.txt oder durch noindex-Tags blockiert worden sein

- Hosting-Anbieter blockieren möglicherweise unsere Bots, da sie glauben, dass es sich um einen DDoS-Angriff handelt (massive Anzahl von Treffern in kurzer Zeit)

- Zum Zeitpunkt des erneuten Crawls der Kampagne konnte die DNS der Domain nicht aufgelöst werden

Wenn du glaubst, es liegt ein Fehler beim Crawlen vor, dann erfährst du in diesem umfassenden Artikel, wie du die Probleme mit robots.txt beheben kannst.

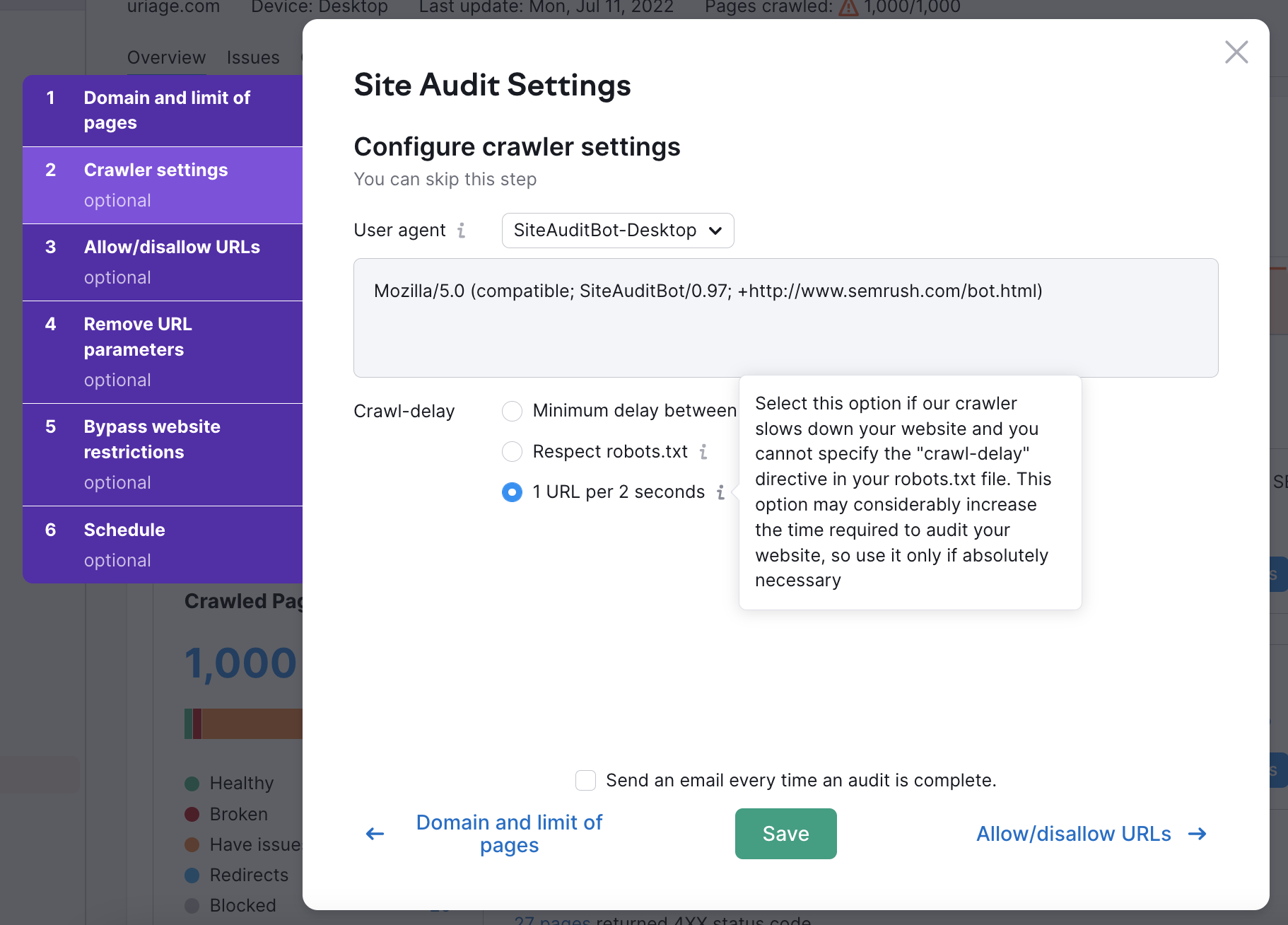

Du kannst auch die Geschwindigkeit beim Crawlen verlangsamen, um eine große Anzahl von Zugriffen auf deinen Seiten zur gleichen Zeit zu verhindern. Darin liegt der Grund dafür, dass unser Bot die Seiten als defekt meldete, obwohl sie einwandfrei funktionierten. Das nennt man ein falsch-positives Ergebnis.

- What Issues Can Site Audit Identify?

- How many pages can I crawl in a Site Audit?

- Wie lange dauert das Crawlen einer Webseite? Ich habe den Eindruck, mein Audit hängt fest.

- Wie überprüfe ich eine Subdomain?

- Can I manage the automatic Site Audit re-run schedule?

- Can I set up a custom re-crawl schedule?

- Wie wird der Site Health Score im Site Audit Tool berechnet?

- How Does Site Audit Select Pages to Analyze for Core Web Vitals?

- How do you collect data to measure Core Web Vitals in Site Audit?

- Why is there a difference between GSC and Semrush Core Web Vitals data?

- Weshalb werden nur wenige Seiten meiner Website gecrawlt?

- Warum werden mir funktionierende Seiten als defekt angezeigt?

- Why can’t I find URLs from the Audit report on my website?

- Why does Semrush say I have duplicate content?

- Why does Semrush say I have an incorrect certificate?

- What are unoptimized anchors and how does Site Audit identify them?

- What do the Structured Data Markup Items in Site Audit Mean?

- Can I stop a current Site Audit crawl?

- Using JS Impact Report to Review a Page

- Site Audit konfigurieren

- Fehlerbehebung bei Site Audit

- Site Audit Overview Report

- Thematische Berichte in Site Audit

- Reviewing Your Site Audit Issues

- Bericht „Gecrawlte Seiten“ in Site Audit

- Site Audit Statistics

- Compare Crawls and Progress

- Exporting Site Audit Results

- So optimierst du die Crawling-Geschwindigkeit deines Site Audits

- So integrierst du Site Audit mit Zapier

- JS Impact Report